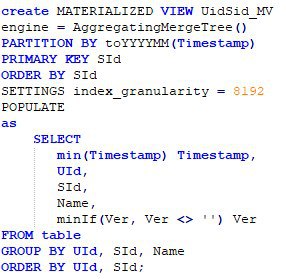

Всем привет! Подскажите по созданию MATERIALIZED VIEW и AggregatingMergeTree. Хочу использовать AggregatingMergeTree в представлении для группировки данных по полям UId, SId, Name, с дополнительными условиями - минимальным timestamp и минимальным непустым значением Ver.

create MATERIALIZED VIEW UidSid_MV

engine = AggregatingMergeTree()

PARTITION BY toYYYYMM(Timestamp)

PRIMARY KEY SId

ORDER BY SId

SETTINGS index_granularity = 8192

POPULATE

as

SELECT

min(Timestamp) Timestamp,

UId,

SId,

Name,

minIf(Ver, Ver <> '') Ver

FROM table

GROUP BY UId, SId, Name

ORDER BY UId, SId;

Создал это Mat View, и ещё одно с таким же запросом, но с движком MergeTree, чтобы сравнить производительность. Результаты производительности примерно одинаковы, если делать "SELECT *" по одному конкретному UId (1.2-1.5 сек в моем случае в каждом запросе). Я ожидал лучшую производительность в случае использования AggregatingMergeTree. Почему так? Может я неверно написал запрос?