S

Size: a a a

2020 July 16

Добрый день, подскажите пожалуйста название этого визуала

S

А

Чатик есть, но там зубры сидят.. с решениями немного другого порядка сложности.

Эх нам бы свой, но ради этого стоит ли его создавать? Не знаю. Тут мы как бы не очень интересны со своими проблемами. Общаться с Hadoop гуру тоже не наша тема..

А

А чат на 10 человек.. ну не знаю.

АО

Потому что к самой архитектуре данных PowerBI имеет посредственное отношение.

Архитектура - это то, что идет ДО PowerBI, и вариантов бесчисленное множество, кстати, для нее отедельный чатик в ТГ есть, так и называется "Архитектура данных".

Архитектура - это то, что идет ДО PowerBI, и вариантов бесчисленное множество, кстати, для нее отедельный чатик в ТГ есть, так и называется "Архитектура данных".

И Дог Смаил, как-то подсказал мне, процитировав итальянцев - что модель снежинка может работать медленнее чем звезда. Я люблю делать некоторые показатели фактов отдельной табличкой через PQ и присоединять её к основным таблицам факта связью. И с того момента у меня возник вопрос а как лучше и в каких ситуациях??? Я не знаю как работает PQ, по какой логике делает вычисления и в каких случаях это нужно, а в каких нет! :)

Реально очень мало знаний!!! :)

Реально очень мало знаний!!! :)

EH

а где есть хадуп гуру?

АО

Александр

Эх нам бы свой, но ради этого стоит ли его создавать? Не знаю. Тут мы как бы не очень интересны со своими проблемами. Общаться с Hadoop гуру тоже не наша тема..

Много чатов - это не сильно хорошо!!! :)

DL

Александр

Эх нам бы свой, но ради этого стоит ли его создавать? Не знаю. Тут мы как бы не очень интересны со своими проблемами. Общаться с Hadoop гуру тоже не наша тема..

Оставааааааааааайся! :)

А

А размытость темы тоже не вариант. Давайте опрос - сколько нас

А

Оставааааааааааайся! :)

Может ты создашь? Только сначала опрос надо провести.

AK

:) Спасибо.

AK

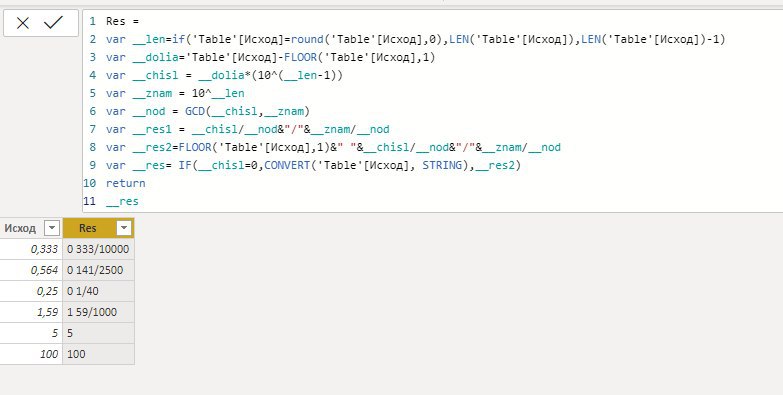

Res =

var __len=if('Table'[Исход]=round('Table'[Исход],0),LEN('Table'[Исход]),LEN('Table'[Исход])-1)

var __dolia='Table'[Исход]-FLOOR('Table'[Исход],1)

var __chisl = __dolia*(10^(__len-1))

var __znam = 10^__len

var __nod = GCD(__chisl,__znam)

var __res1 = __chisl/__nod&"/"&__znam/__nod

var __res2=FLOOR('Table'[Исход],1)&" "&__chisl/__nod&"/"&__znam/__nod

var __res= IF(__chisl=0,CONVERT('Table'[Исход], STRING),__res2)

return

__res

var __len=if('Table'[Исход]=round('Table'[Исход],0),LEN('Table'[Исход]),LEN('Table'[Исход])-1)

var __dolia='Table'[Исход]-FLOOR('Table'[Исход],1)

var __chisl = __dolia*(10^(__len-1))

var __znam = 10^__len

var __nod = GCD(__chisl,__znam)

var __res1 = __chisl/__nod&"/"&__znam/__nod

var __res2=FLOOR('Table'[Исход],1)&" "&__chisl/__nod&"/"&__znam/__nod

var __res= IF(__chisl=0,CONVERT('Table'[Исход], STRING),__res2)

return

__res

DS

Res =

var __len=if('Table'[Исход]=round('Table'[Исход],0),LEN('Table'[Исход]),LEN('Table'[Исход])-1)

var __dolia='Table'[Исход]-FLOOR('Table'[Исход],1)

var __chisl = __dolia*(10^(__len-1))

var __znam = 10^__len

var __nod = GCD(__chisl,__znam)

var __res1 = __chisl/__nod&"/"&__znam/__nod

var __res2=FLOOR('Table'[Исход],1)&" "&__chisl/__nod&"/"&__znam/__nod

var __res= IF(__chisl=0,CONVERT('Table'[Исход], STRING),__res2)

return

__res

var __len=if('Table'[Исход]=round('Table'[Исход],0),LEN('Table'[Исход]),LEN('Table'[Исход])-1)

var __dolia='Table'[Исход]-FLOOR('Table'[Исход],1)

var __chisl = __dolia*(10^(__len-1))

var __znam = 10^__len

var __nod = GCD(__chisl,__znam)

var __res1 = __chisl/__nod&"/"&__znam/__nod

var __res2=FLOOR('Table'[Исход],1)&" "&__chisl/__nod&"/"&__znam/__nod

var __res= IF(__chisl=0,CONVERT('Table'[Исход], STRING),__res2)

return

__res

Спасибо!

А

Нужен ли отдельный чат по Архитектуре данных для BI?

Анонимный опрос

Проголосовало: 41A

Чатик есть, но там зубры сидят.. с решениями немного другого порядка сложности.

Да, по крайней мере, pbi-чат очень активный, тут живое общение.

по поводу архитектуры

Я бы начал с малого и просто разделил данные, поступающие в PBI на 3 группы:

1. Сырые

2. Подготовленные кем-то

3. Подготовленные вами

Откуда они поступают - тоже вопрос, но для отдельного обсуждения.

Сырые данные - это плохо? Не всегда, конечно. Особенно в самом начале в маленькой задачке нет смысла заморачиваться о каких-то витринах и т.п. Так что берем сырые данные, причесываем в PQ и смело делаем отчёт. Чем больше у нас становится отчетов, тем больше мы тратим времени на то, чтобы данные причесать, значит тем больше возрастает необходимость в их предварительной обработке.

Подготовленные кем-то - это, вообще, как? А очень просто. Вы - аналитик, сотрудник большой компании. И не нужно забивать вам голову тем, как данные готовятся. Эскалируйте это на уровень ниже - пусть за вас этим занимается другой департамент/отдел. PQ тут стоит ипспользовать по минимуму, чтобы было однозначное понимание не только у вас, а у всех, с какими данными работает отчёт. Можно еще сюда добавить промежуточный этап - кубы, скажем, данные готовятся для вас где-то еще, а самим кубом управляете уже вы, только оттуда они попадают в отчёт, только там формируются меры.

Некому готовить данные? Не беда, сделаем это сами. Поднимем СУБД (любую - на вкус и цвет, как говорится) и приступим к созданию нашего маленького хранилища данных.

Тут любые средства хороши - начнём с ETL, соберем все, что нам нужно, в одном месте, потом создадим витрину для нашего отчёта (желательно по схеме звезда, чтобы все было понятно от одного взгляда на схему внутри отчёта), а дальше прицепимся к ней и (см. п.2.)

Но проблема в том, что СУБД великое множество, ETL - Тоже, тут, наверное, стоит обсуждать только какие-то хорошие архитектурные практики, не заморачиваясь на средствах.

по поводу архитектуры

Я бы начал с малого и просто разделил данные, поступающие в PBI на 3 группы:

1. Сырые

2. Подготовленные кем-то

3. Подготовленные вами

Откуда они поступают - тоже вопрос, но для отдельного обсуждения.

Сырые данные - это плохо? Не всегда, конечно. Особенно в самом начале в маленькой задачке нет смысла заморачиваться о каких-то витринах и т.п. Так что берем сырые данные, причесываем в PQ и смело делаем отчёт. Чем больше у нас становится отчетов, тем больше мы тратим времени на то, чтобы данные причесать, значит тем больше возрастает необходимость в их предварительной обработке.

Подготовленные кем-то - это, вообще, как? А очень просто. Вы - аналитик, сотрудник большой компании. И не нужно забивать вам голову тем, как данные готовятся. Эскалируйте это на уровень ниже - пусть за вас этим занимается другой департамент/отдел. PQ тут стоит ипспользовать по минимуму, чтобы было однозначное понимание не только у вас, а у всех, с какими данными работает отчёт. Можно еще сюда добавить промежуточный этап - кубы, скажем, данные готовятся для вас где-то еще, а самим кубом управляете уже вы, только оттуда они попадают в отчёт, только там формируются меры.

Некому готовить данные? Не беда, сделаем это сами. Поднимем СУБД (любую - на вкус и цвет, как говорится) и приступим к созданию нашего маленького хранилища данных.

Тут любые средства хороши - начнём с ETL, соберем все, что нам нужно, в одном месте, потом создадим витрину для нашего отчёта (желательно по схеме звезда, чтобы все было понятно от одного взгляда на схему внутри отчёта), а дальше прицепимся к ней и (см. п.2.)

Но проблема в том, что СУБД великое множество, ETL - Тоже, тут, наверное, стоит обсуждать только какие-то хорошие архитектурные практики, не заморачиваясь на средствах.

А

И Дог Смаил, как-то подсказал мне, процитировав итальянцев - что модель снежинка может работать медленнее чем звезда. Я люблю делать некоторые показатели фактов отдельной табличкой через PQ и присоединять её к основным таблицам факта связью. И с того момента у меня возник вопрос а как лучше и в каких ситуациях??? Я не знаю как работает PQ, по какой логике делает вычисления и в каких случаях это нужно, а в каких нет! :)

Реально очень мало знаний!!! :)

Реально очень мало знаний!!! :)

Ну так это начало только... Что бы знать, нужно это конкретно учить, как в институте или на курсах...

Как по мне было бы круто иметь что то вроде методички с напоминалками, как например напоминалки по обьеденению в PQ или для чего использовать вижуал

В общей методе что как и для чего со ссылками на великих и отдельно напоминалки

Как по мне было бы круто иметь что то вроде методички с напоминалками, как например напоминалки по обьеденению в PQ или для чего использовать вижуал

В общей методе что как и для чего со ссылками на великих и отдельно напоминалки

АО

Ну так это начало только... Что бы знать, нужно это конкретно учить, как в институте или на курсах...

Как по мне было бы круто иметь что то вроде методички с напоминалками, как например напоминалки по обьеденению в PQ или для чего использовать вижуал

В общей методе что как и для чего со ссылками на великих и отдельно напоминалки

Как по мне было бы круто иметь что то вроде методички с напоминалками, как например напоминалки по обьеденению в PQ или для чего использовать вижуал

В общей методе что как и для чего со ссылками на великих и отдельно напоминалки

Я знаю, что учить нужно, Вот только у меня другое образование, и в институт я не могу сейчас пойти, но рано или поздно я это буду знать!!! Я же как то дошёл до моего сегодняшнего уровня. Значит и в пять раз выше прыгну!:)

А

Александр

Нужен ли отдельный чат по Архитектуре данных для BI?

Анонимный опрос

Проголосовало: 41Продолжаем голосовать

KK

И Дог Смаил, как-то подсказал мне, процитировав итальянцев - что модель снежинка может работать медленнее чем звезда. Я люблю делать некоторые показатели фактов отдельной табличкой через PQ и присоединять её к основным таблицам факта связью. И с того момента у меня возник вопрос а как лучше и в каких ситуациях??? Я не знаю как работает PQ, по какой логике делает вычисления и в каких случаях это нужно, а в каких нет! :)

Реально очень мало знаний!!! :)

Реально очень мало знаний!!! :)

Не боись, чтобы ездить на машине, не обязательно знать, как она устроена