D

Size: a a a

2020 February 27

Тогда жди завтра, гляну что у меня а launch configuration

кажыцца, поборол

D

#SecurityGroups:

# - !Ref "JenkinsSG"

SecurityGroupIds:

- Fn::GetAtt:

- JenkinsSG

- GroupId

SubnetId:

"Fn::ImportValue": !Sub "${VPCEnvironmentName}-PrivateSubnet1"

# - !Ref "JenkinsSG"

SecurityGroupIds:

- Fn::GetAtt:

- JenkinsSG

- GroupId

SubnetId:

"Fn::ImportValue": !Sub "${VPCEnvironmentName}-PrivateSubnet1"

D

именно в такой паре - похоже работает как надо

D

и надо попробовать задать именно имя SG, а не ид, видел где-то что может помочб

lk

привет, может быть у кого-то была задача посчитать трафик уходящий из авса и сделать аларм если его стало слижком много?

V

На расходы можно ставить алармы. Возможно тотже механизм заработает по трафику

D

чем можно сконвертить уже работающий кластер в шаблон? Пусть выглядеть будет страшно, мне оттуда отдельные куски нужны

V

CloudFormer

D

оно картинку же сделает, а мне нужен cfn template.. или шаблоны умеет?

AV

чем можно сконвертить уже работающий кластер в шаблон? Пусть выглядеть будет страшно, мне оттуда отдельные куски нужны

I

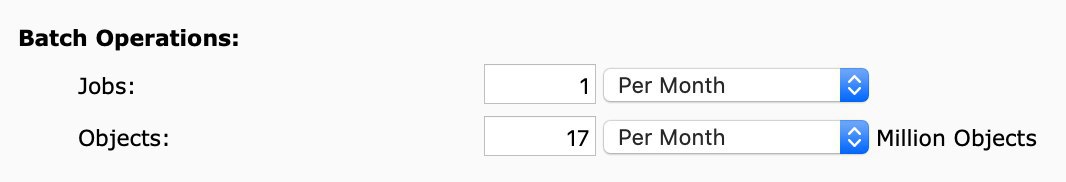

Господа! Кто пользовался S3 batch operations? Меня интересует конкретно COPY. Задача: засинкать ранее существовавшие объекты в бакете со свежевключенной cross-region репликой. Вводные данные: 8 Тб, 17 миллионов объектов. Как рассчитать стоимость джобы? Верно ли, что достаточно посчитать количество джоб + объектов и это будет точная стоимость? Или надо все же считать дополнительно исходящий/входящий траффик + GET/PUT запросы и что-то еще?

D

да, уже выше было, потискал его