S

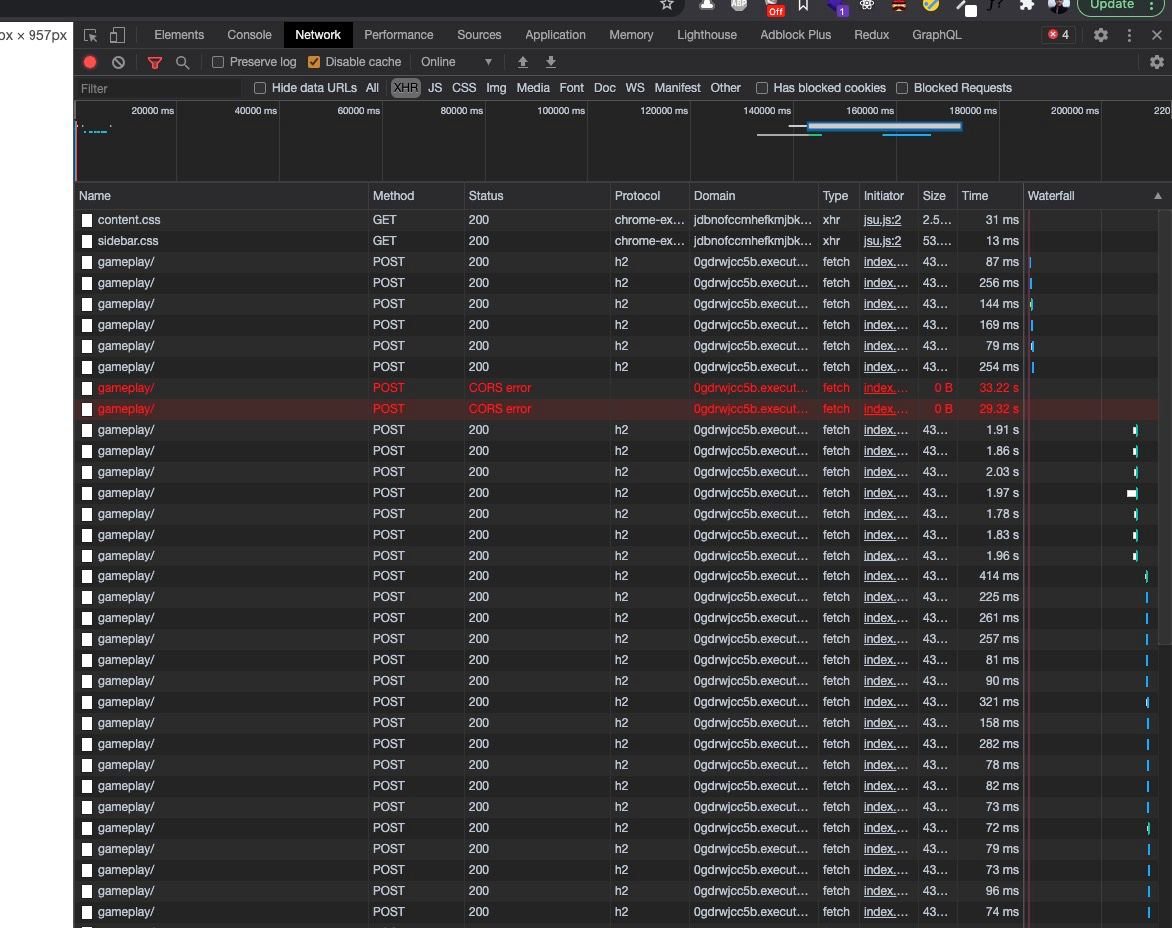

Есть клустер в AWS, поднятый терраформом. Поставил туда autoscaler - все работает (ноды создаются\удаляются), но теперь при попытке сделать kubectl exec в подах, созданных на нодах от автоскейлера, получаю

error: unable to upgrade connection: Authorization error (user=kube-apiserver-kubelet-client, verb=create, resource=nodes, subresource=proxy)