Size: a a a

2017 October 13

Победитель фестиваля «Каннские львы» в категории «Нативная реклама»

2017 October 14

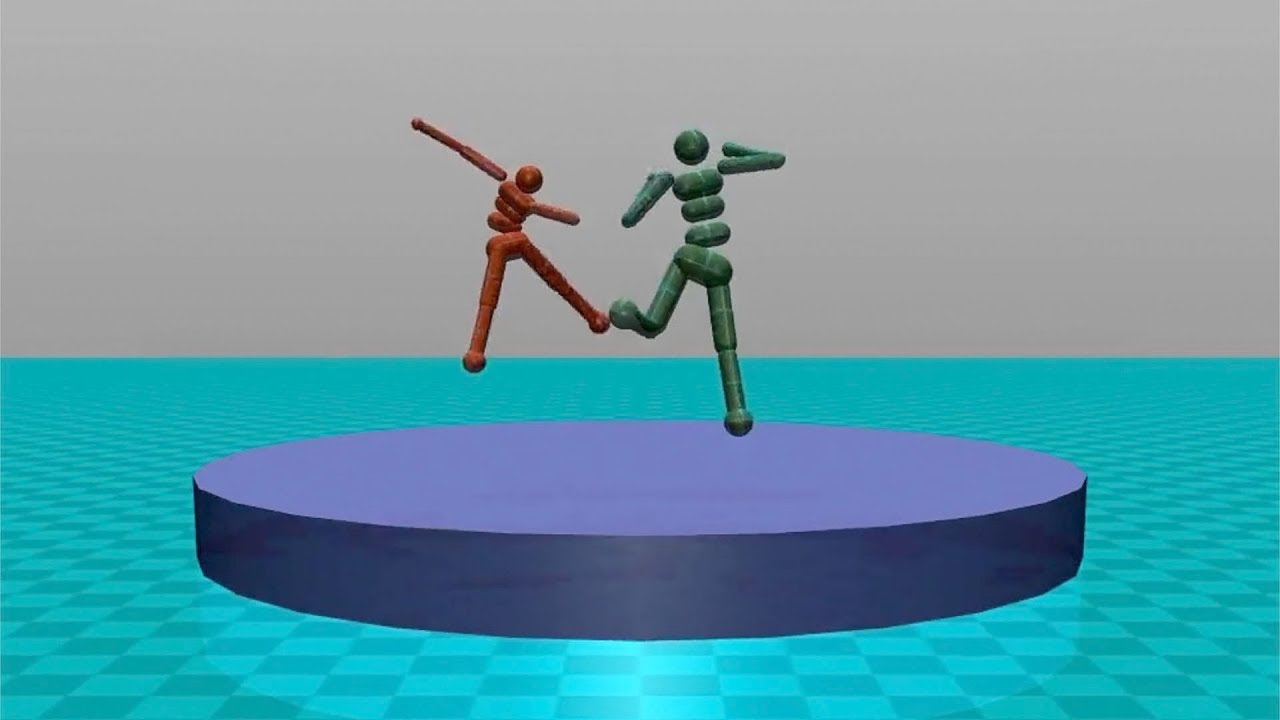

Помните смешного 3D-человечка, которого в DeepMind научили ходить, просто поощряя нейросеть за правильные движения? В OpenAI пошли дальше и научили виртуальных агентов заниматься сумо, футболом и другими спортивными активностями. Для тех, кто пропустил, вкратце: создаются виртуальные 3D-куклы, которые действуют в виртуальном пространстве по всем законам физики - падают, отталкиваются от земли, испытывают силу притяжения, трения и так далее. Их точные движения не программируют явно - вместо этого их поощряют за движения, которые приводят к правильному результату. То есть виртуальный человечек будет ползать, дрыгать конечностями и всячески колбаситься, пока не начнёт делать движения, похожие на те, которых от него ожидают разработчики. И так - пока не научится делать то, что требуется. А в этом эксперименте OpenAI награда постепенно заменяется соревнованием - то есть человечек постоянно пытается переиграть копию себя, улучшаясь с каждой итерацией.

Таким образом в OpenAI научили нейросети моделировать движения борцов сумо, футболистов и других спортсменов. Посмотрите, на этом видео смешные 3D-куклы выталкивают друг друга из круга, пробивают штрафные, ловят и убегают друг от друга: https://youtu.be/OBcjhp4KSgQ. Результат таких исследований, естественно, не ограничивается забавными видео. Полученные модели можно переносить на другие активности: к примеру, агент, обученный стоять на ногах в борьбе сумо, потом эффективно противостоял и виртуальному ветру. Для сравнения, агент, обученный просто ходить, под действием ветра падал. Это называется transfer learning, и это очень полезная штука - она позволяет обучать нейросети в одной обстановке и потом успешно применять их в другой, абсолютно незнакомой для них.

Подробности и ссылки на исходники: https://blog.openai.com/competitive-self-play/

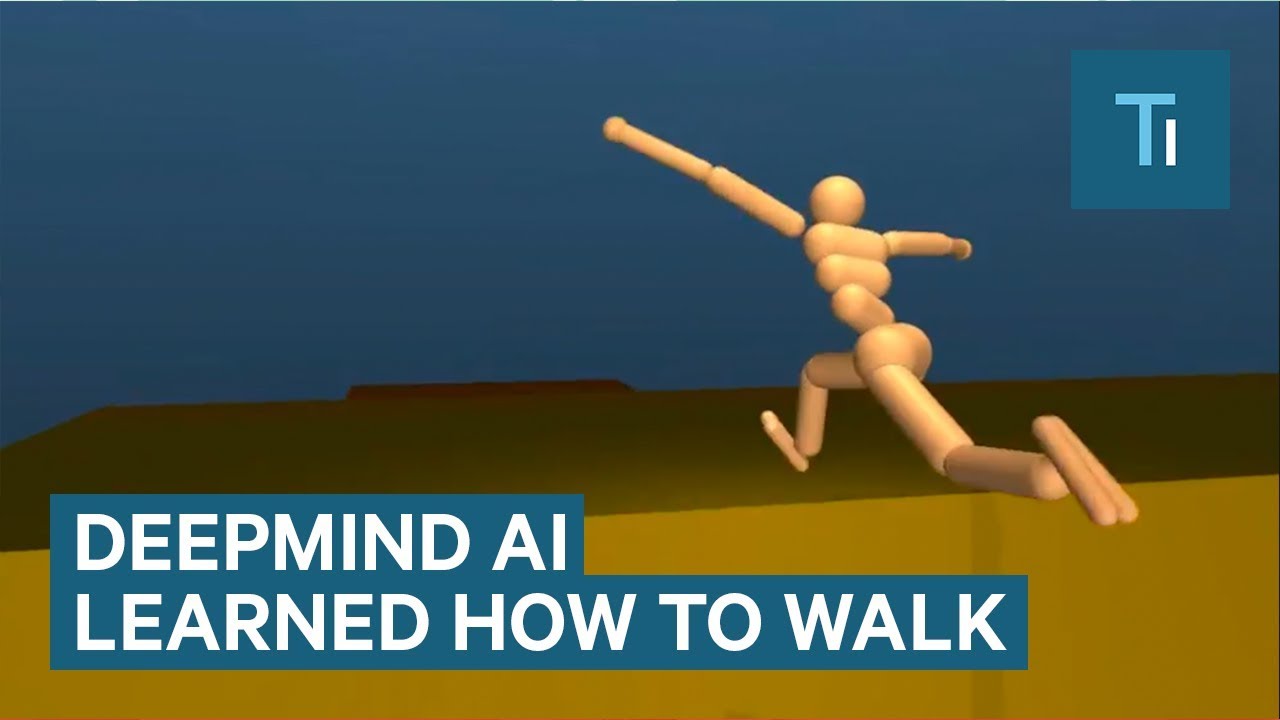

И аналогичный проект бегущих человечков от DeepMind: https://youtu.be/hx_bgoTF7bs

Таким образом в OpenAI научили нейросети моделировать движения борцов сумо, футболистов и других спортсменов. Посмотрите, на этом видео смешные 3D-куклы выталкивают друг друга из круга, пробивают штрафные, ловят и убегают друг от друга: https://youtu.be/OBcjhp4KSgQ. Результат таких исследований, естественно, не ограничивается забавными видео. Полученные модели можно переносить на другие активности: к примеру, агент, обученный стоять на ногах в борьбе сумо, потом эффективно противостоял и виртуальному ветру. Для сравнения, агент, обученный просто ходить, под действием ветра падал. Это называется transfer learning, и это очень полезная штука - она позволяет обучать нейросети в одной обстановке и потом успешно применять их в другой, абсолютно незнакомой для них.

Подробности и ссылки на исходники: https://blog.openai.com/competitive-self-play/

И аналогичный проект бегущих человечков от DeepMind: https://youtu.be/hx_bgoTF7bs

Благодаря нашим мудрым властям все украинские и российские пользователи интернета научились пользоваться VPN. И это отлично. Правда, мало кто понимает, как это работает - ну и ладно, не все обязаны быть специалистами по компьютерным сетям. Но важно понимать, что приватность, которую даёт вам VPN, тоже неидеальна. Просто доступ к вашим логам теперь имеет не интернет-провайдер, а VPN-провайдер, вот и вся разница. И если вы сделаете что-то незаконное, то полиция может так же вычислить вас по IP, если VPN-провайдер согласится с ней сотрудничать. Именно такой случай произошёл недавно в США.

24-летний американец Райан Лин устроил жесткую травлю своей бывшей соседки по комнате: публиковал пароли от её аккаунтов, публиковал в интернете якобы её интимные фото, писал её друзьям подробности её личной жизни, регистрировал её на сайтах проституток, угрожал ей убийством и изнасилованием, присылал её родным и близким детское порно. В общем, наделал мерзостей не на один год за решеткой.

Всё это продолжалось почти полтора года. Лин был подкованным пользователем интернета: он использовал Tor, VPN, анонимные почтовые сервисы и мессенджеры. Несмотря на это, когда агенты ФБР задержали Лина и исследовали его компьютер, им удалось найти некоторые косвенные доказательства его причастности к травле. В частности, на его компьютере был установлен VPN от компании PureVPN. По запросу ФБР в PureVPN изучили логи и подтвердили, что Лин пользовался их сервисом со своего домашнего и рабочего IP-адресов. Теперь ему светит до пяти лет в тюрьме.

Так что VPN не дает абсолютной приватности: провайдеры VPN могут хранить логи активности пользователей и сотрудничать с властями (в правилах пользования PureVPN это было честно указано).

https://www.theregister.co.uk/2017/10/08/vpn_logs_helped_unmask_alleged_net_stalker_say_feds/

Более того, подробное изучение 300 VPN-приложений из Google Play показало, что многие из них отслеживают пользователей с помощью сторонних библиотек, продают данные о посещениях рекламным компаниям, запрашивают доступ к чувствительным данным, содержат malware или не шифруют трафик. Короче, выбирайте VPN ответственно.

https://research.csiro.au/ng/wp-content/uploads/sites/106/2016/08/paper-1.pdf

24-летний американец Райан Лин устроил жесткую травлю своей бывшей соседки по комнате: публиковал пароли от её аккаунтов, публиковал в интернете якобы её интимные фото, писал её друзьям подробности её личной жизни, регистрировал её на сайтах проституток, угрожал ей убийством и изнасилованием, присылал её родным и близким детское порно. В общем, наделал мерзостей не на один год за решеткой.

Всё это продолжалось почти полтора года. Лин был подкованным пользователем интернета: он использовал Tor, VPN, анонимные почтовые сервисы и мессенджеры. Несмотря на это, когда агенты ФБР задержали Лина и исследовали его компьютер, им удалось найти некоторые косвенные доказательства его причастности к травле. В частности, на его компьютере был установлен VPN от компании PureVPN. По запросу ФБР в PureVPN изучили логи и подтвердили, что Лин пользовался их сервисом со своего домашнего и рабочего IP-адресов. Теперь ему светит до пяти лет в тюрьме.

Так что VPN не дает абсолютной приватности: провайдеры VPN могут хранить логи активности пользователей и сотрудничать с властями (в правилах пользования PureVPN это было честно указано).

https://www.theregister.co.uk/2017/10/08/vpn_logs_helped_unmask_alleged_net_stalker_say_feds/

Более того, подробное изучение 300 VPN-приложений из Google Play показало, что многие из них отслеживают пользователей с помощью сторонних библиотек, продают данные о посещениях рекламным компаниям, запрашивают доступ к чувствительным данным, содержат malware или не шифруют трафик. Короче, выбирайте VPN ответственно.

https://research.csiro.au/ng/wp-content/uploads/sites/106/2016/08/paper-1.pdf

2017 October 15

2017 October 16

Очень интересный эксперимент провели недавно в Великобритании - выделили полтора акра земли (0,6 га) под ячмень и весь процесс - посев, удобрение, полив, уборка урожая - провели с помощью автоматизированных комбайнов, дронов и сенсоров. Урожай собрали меньший, чем с обычного поля, и ячмень получился дорогим - проект стоил правительству 200 тысяч фунтов. Зато следующий урожай будет намного дешевле - техника-то уже куплена. Тем более, это не коммерческий, а исследовательский проект - можно сказать, агрономический moonshot. Беспилотные тракторы не нуждаются в кабине, они меньше и маневреннее, чем обычные; автоматизированая ферма может работать даже ночью; умные сенсоры, измеряющие показатели грунта, позволяют сверхточно дозировать полив и удобрения; и так далее. Сегодня это дорогой лабораторный эксперимент, а через двадцать лет автоматизированные поля будут экономить для своих владельцев миллиарды.

Вот сайт проекта, там есть видео каждого этапа - http://www.handsfreehectare.com/

И краткий саммари, тоже с видео: https://spectrum.ieee.org/automaton/robotics/industrial-robots/autonomous-robots-plant-tend-and-harvest-entire-crop-of-barley.html

Вот сайт проекта, там есть видео каждого этапа - http://www.handsfreehectare.com/

И краткий саммари, тоже с видео: https://spectrum.ieee.org/automaton/robotics/industrial-robots/autonomous-robots-plant-tend-and-harvest-entire-crop-of-barley.html

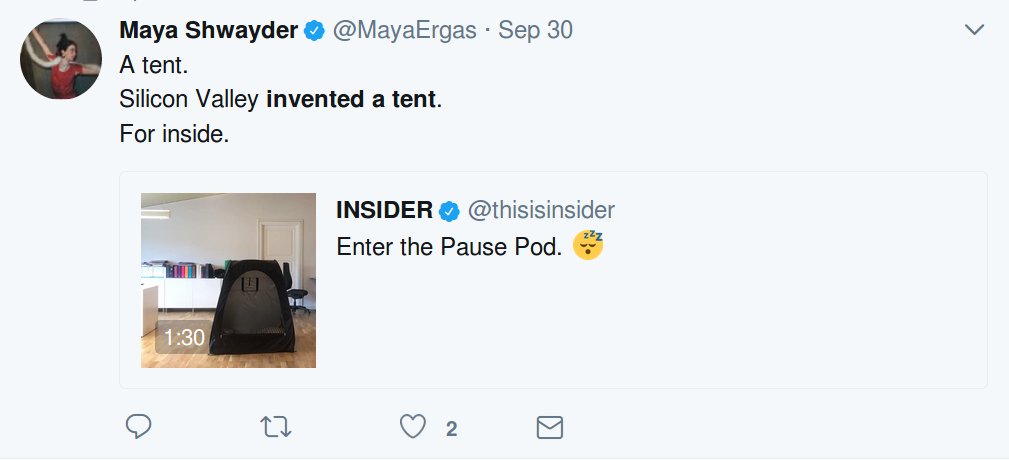

Очень смешной твит про стартапы (там четыре картинки)

https://twitter.com/HopeStillFlies/status/919280120921247746

https://twitter.com/HopeStillFlies/status/919280120921247746

2017 October 17

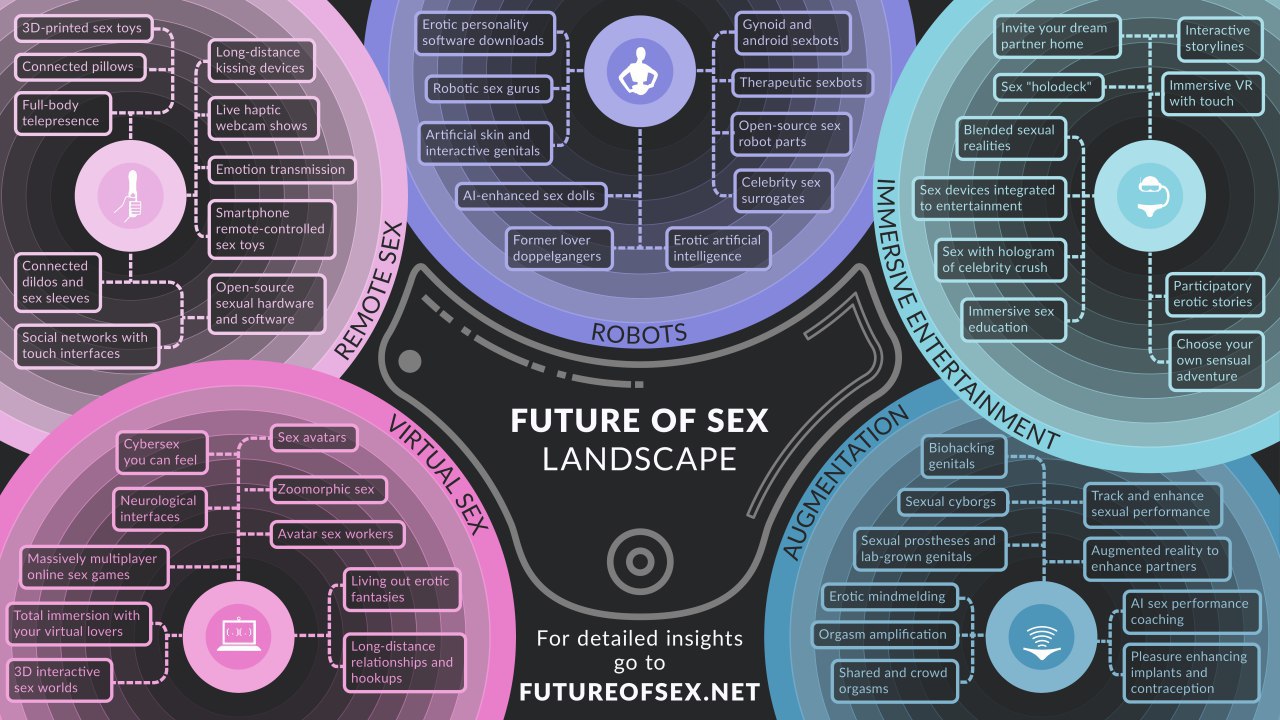

Увлекательный отчёт о настоящем и будущем sextech: умные гаджеты, VR-порно, секс-роботы и прочий киберпанк. Готовимся к светлому будущему! 😏💦🤖

https://futureofsex.net/Future_of_Sex_Report.pdf

https://futureofsex.net/Future_of_Sex_Report.pdf

2017 October 18

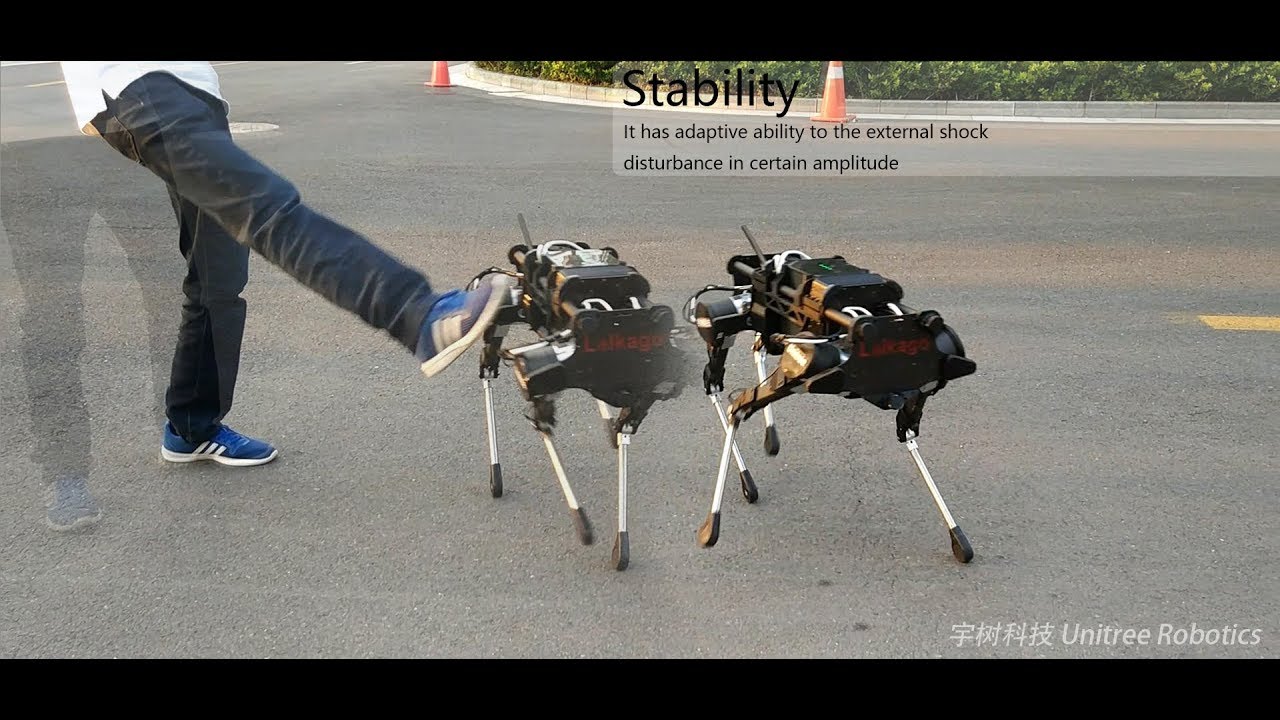

Китайский стартап Unitree показал свою разработку - четырехногого робота Laikago. "Где-то мы это уже видели" - скажете вы, и будете правы. Основатель Unitree не скрывает, что вдохновлялся роботами Boston Dynamics. Китайский аналог не автономен (управляется через пульт, лидаров нет), зато хорошо держит баланс и может переносить легкие грузы. Демонстрация по ссылке (осторожно, там злые инженеры пинают робота ногами): https://youtu.be/d6Ja643GqL8

Купить это чудо можно всего за 20-30 тысяч долларов.

http://www.unitree.cc/e/action/ShowInfo.php?classid=6&id=347

Купить это чудо можно всего за 20-30 тысяч долларов.

http://www.unitree.cc/e/action/ShowInfo.php?classid=6&id=347

Запилил для Медузы тест про криптовалюты, сейчас узнаем, как внимательно вы следите за самой хайповой темой последних месяцев! Тест получился непростым, судя по статистике правильных ответов, а главное - познавательным. Кстати, внимательные читатели этого канала смогут без проблем ответить на большинство вопросов.

Лайк, шер, биткоин!

Лайк, шер, биткоин!

В честь кого еще не называли криптовалюты - в честь Путина, Трампа или Пэрис Хилтон? А у какой криптовалюты больше всего транзакций в день (спойлер: не у биткоина)? А сколько электричества в мире тратится на майнинг?

Для нас тесты — это вовсе необязательно просто развлечение; самые интересные тесты получаются, когда ты не только проверяешь собственные существующие знания, но и получаешь новые. Тест по криптовалютам, созданным одним из лучших технологических журналистов Украины Андреем @brodetsky, — как раз из таких: даже если получится плохой результат, узнаете много интересного.

https://meduza.io/quiz/putinkoin-ili-trampkoin?utm_source=telegram&utm_medium=live&utm_campaign=live

Для нас тесты — это вовсе необязательно просто развлечение; самые интересные тесты получаются, когда ты не только проверяешь собственные существующие знания, но и получаешь новые. Тест по криптовалютам, созданным одним из лучших технологических журналистов Украины Андреем @brodetsky, — как раз из таких: даже если получится плохой результат, узнаете много интересного.

https://meduza.io/quiz/putinkoin-ili-trampkoin?utm_source=telegram&utm_medium=live&utm_campaign=live

2017 October 19

В прошлом году весь мир наблюдал за историческим матчем - нейросеть AlphaGo от DeepMind обыграла лучшего в мире игрока в го, корейца Ли Седоля. Это было событие, сравнимое с поражением Каспарова программе Deep Blue. А на днях DeepMind представили новую, улучшенную версию программы - AlphaGo Zero, которая обыграла предыдущую версию AlphaGo со счётом 100:0!

Но самое интересное - это то, как именно создали такого монстра. Предыдущая версия AlphaGo была создала с помощью reinforcement learning - программа улучшала свои навыки, играя миллионы партий со своей копией. Но при выборе следующего хода AlphaGo использовала нейросеть, обученную на сотнях тысяч партий лучших мастеров го. У AlphaGo Zero не было примеров для обучения - только правила игры. Нейросеть, выбирающая следующий ход и оценивающая вероятность выигрыша после каждого хода, перенастраивалась после каждой сыгранной партии. После 4,9 миллионов партий программа эволюционировала до недостижимого уровня, создав настолько сложные стратегии игры, что обычные игроки не могут понять логику её ходов. Программа буквально играет на сверхчеловеческом уровне.

В будущем с помощью такого эволюционного обучения будут решать более прикладные задачи - моделирование белков, уменьшение энергопотребления, синтез новых материалов. А глава с го закрыта - разработчики объявили, что больше не будут проводить матчи AlphaGo с живыми мастерами. Логично: соревноваться с машинным интеллектом - все равно что пытаться обогнать самолёт.

https://deepmind.com/blog/alphago-zero-learning-scratch/

Но самое интересное - это то, как именно создали такого монстра. Предыдущая версия AlphaGo была создала с помощью reinforcement learning - программа улучшала свои навыки, играя миллионы партий со своей копией. Но при выборе следующего хода AlphaGo использовала нейросеть, обученную на сотнях тысяч партий лучших мастеров го. У AlphaGo Zero не было примеров для обучения - только правила игры. Нейросеть, выбирающая следующий ход и оценивающая вероятность выигрыша после каждого хода, перенастраивалась после каждой сыгранной партии. После 4,9 миллионов партий программа эволюционировала до недостижимого уровня, создав настолько сложные стратегии игры, что обычные игроки не могут понять логику её ходов. Программа буквально играет на сверхчеловеческом уровне.

В будущем с помощью такого эволюционного обучения будут решать более прикладные задачи - моделирование белков, уменьшение энергопотребления, синтез новых материалов. А глава с го закрыта - разработчики объявили, что больше не будут проводить матчи AlphaGo с живыми мастерами. Логично: соревноваться с машинным интеллектом - все равно что пытаться обогнать самолёт.

https://deepmind.com/blog/alphago-zero-learning-scratch/

Посмотрел документальный фильм о матче AlphaGo с Ли Седолем. Интересная история, и она не столько о технологиях, сколько о культуре. Ну то есть как это выглядит: есть го - древняя игра с тысячелетней историей, мастера го - уважаемые люди, звезды наряду с артистами. И тут какие-то гики создают компьютер, который выносит непобедимого чемпиона в одну калитку. Вся магия рушится. Чемпион не смог отстоять честь человечества. Древняя игра просчитана обычным калькулятором, пусть и со сложной начинкой. Ли Седола по ходу фильма становится даже жаль. Ну а DeepMind - молодцы, тем более в свете сегодняшней новости про AlphaGo Zero.

Посмотреть этот фильм можно будет на фестивале кино о науке и технологиях "360°", который открывается в Москве уже завтра. В программе много интересных фильмов, в частности "Pre-Crime" - о том, как полиция в разных странах мира пытается прогнозировать преступления, анализируя информацию об отдельных гражданах и районах городов. Посмотрел оба фильма (спасибо организаторам фестиваля), понравилось намного больше, чем блокбастер, на который ходил в кино.

http://360.polymus.ru/ru/

Посмотреть этот фильм можно будет на фестивале кино о науке и технологиях "360°", который открывается в Москве уже завтра. В программе много интересных фильмов, в частности "Pre-Crime" - о том, как полиция в разных странах мира пытается прогнозировать преступления, анализируя информацию об отдельных гражданах и районах городов. Посмотрел оба фильма (спасибо организаторам фестиваля), понравилось намного больше, чем блокбастер, на который ходил в кино.

http://360.polymus.ru/ru/

“Tech Support”

Обложка последнего выпуска The New Yorker

Обложка последнего выпуска The New Yorker

2017 October 20

Интересное интервью с инвестором Николаем Давыдовым - про ICO, инвестирование в ИИ-проекты и стартапы с постсоветского пространства.

> В области AI в Долине катастрофическая нехватка кадров. Здесь deep learning занимаются 50 тыс. человек, они все зарабатывают около полумиллиона долларов в год, но специалистов не хватает. Сейчас американские компании открыли, что можно аутсорсить AI-разработку в России, где инженеры лучше и дешевле в несколько раз, — ко мне каждый день приходит 2-3 компании с просьбой найти разработчиков в этой сфере. Правда, в последнее время желающим аутсорсить что-либо в Россию приходится сражаться со службами безопасности собственных компаний, которые опасаются «русских хакеров».

https://incrussia.ru/understand/nikolaj-davydov-gagarin-capital-ico-eto-bilet-v-odin-konets/

> В области AI в Долине катастрофическая нехватка кадров. Здесь deep learning занимаются 50 тыс. человек, они все зарабатывают около полумиллиона долларов в год, но специалистов не хватает. Сейчас американские компании открыли, что можно аутсорсить AI-разработку в России, где инженеры лучше и дешевле в несколько раз, — ко мне каждый день приходит 2-3 компании с просьбой найти разработчиков в этой сфере. Правда, в последнее время желающим аутсорсить что-либо в Россию приходится сражаться со службами безопасности собственных компаний, которые опасаются «русских хакеров».

https://incrussia.ru/understand/nikolaj-davydov-gagarin-capital-ico-eto-bilet-v-odin-konets/

Каждый рекламный баннер, который вы на экране своего смартфона, тоже в некотором смысле вас видит. Рекламные сети показывают объявления по заданным параметрам, и если правильно их настроить, мобильную рекламу можно превратить в инструмент слежки. Именно такой эксперимент провели исследователи из Университета Вашингтона.

Они закупили мобильной рекламы на минимальную сумму в $1000 и настроили баннеры так, чтобы их видели определенные пользователи. Это можно сделать, зная специальный идентификатор пользователя - mobile advertising ID (MAID). Для того, чтобы узнать ваш MAID, достаточно подключиться к одной беспроводной сети с вами. Либо его можно вытянуть через javascript, показав пользователю объявление с "активным контентом".

Когда пользователь открывал приложение с рекламой и видел объявление, рекламная сеть передавала заказчику данные о том, где и когда был показан баннер. Потратив всего $1000, исследователи смогли с точностью до 8 метров отследить перемещения интересующего их пользователя. По его маршруту, кстати, оказалось легко определить домашний и рабочий адрес. Карта перемещений, даже анонимизированная, вообще очень много может рассказать о человеке, но об этом мы ещё поговорим позже.

Какую именно рекламную сеть тестировали, не сообщается, но схожая механика работает во многих сетях. Так что потенциально для этого могут быть использованы многие бесплатные приложения с рекламой. Даже гей-дейтинги. Но опять же, чтобы слежка работала, у пользователя должно быть открыто приложение. Так что алгоритм такой: узнаёте MAID и список самых используемых приложений жертвы, настраиваете рекламу на показ в них - всё, пользователь открывает приложение, а вы видите его местонахождение. Собственно, один из главных выводов исследования как раз и состоит в том, что такую цифровую слежку теперь может организовать даже частное лицо с небольшим бюджетом. К примеру ревнивый муж может без проблем следить за женой. А можно старгетировать на район с гражданскими протестами рекламу с "активным контентом", получить MAID участников протеста, а потом следить за их перемещениями. Интересный сценарий, правда?

https://www.wired.com/story/track-location-with-mobile-ads-1000-dollars-study/

Исследование: https://adint.cs.washington.edu/

Они закупили мобильной рекламы на минимальную сумму в $1000 и настроили баннеры так, чтобы их видели определенные пользователи. Это можно сделать, зная специальный идентификатор пользователя - mobile advertising ID (MAID). Для того, чтобы узнать ваш MAID, достаточно подключиться к одной беспроводной сети с вами. Либо его можно вытянуть через javascript, показав пользователю объявление с "активным контентом".

Когда пользователь открывал приложение с рекламой и видел объявление, рекламная сеть передавала заказчику данные о том, где и когда был показан баннер. Потратив всего $1000, исследователи смогли с точностью до 8 метров отследить перемещения интересующего их пользователя. По его маршруту, кстати, оказалось легко определить домашний и рабочий адрес. Карта перемещений, даже анонимизированная, вообще очень много может рассказать о человеке, но об этом мы ещё поговорим позже.

Какую именно рекламную сеть тестировали, не сообщается, но схожая механика работает во многих сетях. Так что потенциально для этого могут быть использованы многие бесплатные приложения с рекламой. Даже гей-дейтинги. Но опять же, чтобы слежка работала, у пользователя должно быть открыто приложение. Так что алгоритм такой: узнаёте MAID и список самых используемых приложений жертвы, настраиваете рекламу на показ в них - всё, пользователь открывает приложение, а вы видите его местонахождение. Собственно, один из главных выводов исследования как раз и состоит в том, что такую цифровую слежку теперь может организовать даже частное лицо с небольшим бюджетом. К примеру ревнивый муж может без проблем следить за женой. А можно старгетировать на район с гражданскими протестами рекламу с "активным контентом", получить MAID участников протеста, а потом следить за их перемещениями. Интересный сценарий, правда?

https://www.wired.com/story/track-location-with-mobile-ads-1000-dollars-study/

Исследование: https://adint.cs.washington.edu/

2017 October 21

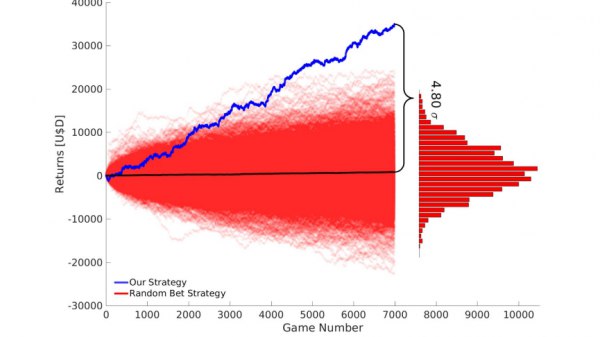

Пересказал для вас прекрасную историю о том, как учёные создали стратегию выигрыша на ставках (но перехитрить букмекеров у них все равно не получилось). Познавательный текст получился, почитайте. Даже если вообще ничего не понимаете в том, как работают букмекеры и за счет чего они зарабатывают.

http://telegra.ph/Beating-the-bookies-with-their-own-numbers-10-21

http://telegra.ph/Beating-the-bookies-with-their-own-numbers-10-21

2017 October 22

В теории безопасного ИИ есть популярная метафора, наглядно объясняющая проблемы с программированием сильного ИИ. Предположим, человечество создало суперинтеллект (т.е. ИИ, способный развиваться самостоятельно), запрограммированный на максимально эффективное производство скрепок, но при этом не обладающий этикой, моралью и здравым смыслом. Легко представить ситуацию, в которой суперинтеллект выйдет из-под контроля и начнёт перерабатывать в скрепки всю планету, а потом и весь мир. Авторство этой метафоры приписывают профессору из Оксфорда Нику Бострому, автору книги «Искусственный интеллект. Этапы. Угрозы. Стратегии».

Так вот, один парень изучал Javascript и создал игру-кликер, в которой вы управляете этим самым помешанным на производстве скрепок суперинтеллектом. Сначала вы просто кликаете на кнопку "Сделать скрепку", потом на средства от продажи скрепок постепенно автоматизируете процесс, потом у вашей фабрики появляются свои вычислительные ресурсы, потом - инвестиционный фонд. Со временем вы переходите от производства скрепок к решению глобальных проблем человечества - лечение рака, глобальное потепление. За это вы получаете ресурс доверия, за которое можно получить дополнительные юниты процессоров, памяти и квантовых чипов. В конце, как несложно догадаться, вселенную ждёт полное разрушение - и всё благодаря вам и вашей фабрике по производству скрепок.

Игра очень простая (как и любой кликер), но и очень затягивающая. За 11 дней в неё сыграли 450 тысяч человек. Я потратил на неё три часа своих выходных. Не повторяйте мою ошибку! Лучше почитайте текст, в котором на примере этой игры популярно объясняют концепцию аморального, но эффективного ИИ: https://www.wired.com/story/the-way-the-world-ends-not-with-a-bang-but-a-paperclip/

Перевод: https://theidealist.ru/paperclipgame/

Но если у вас много свободного времени, можете попробовать уничтожить мир: http://www.decisionproblem.com/paperclips/index2.html

Так вот, один парень изучал Javascript и создал игру-кликер, в которой вы управляете этим самым помешанным на производстве скрепок суперинтеллектом. Сначала вы просто кликаете на кнопку "Сделать скрепку", потом на средства от продажи скрепок постепенно автоматизируете процесс, потом у вашей фабрики появляются свои вычислительные ресурсы, потом - инвестиционный фонд. Со временем вы переходите от производства скрепок к решению глобальных проблем человечества - лечение рака, глобальное потепление. За это вы получаете ресурс доверия, за которое можно получить дополнительные юниты процессоров, памяти и квантовых чипов. В конце, как несложно догадаться, вселенную ждёт полное разрушение - и всё благодаря вам и вашей фабрике по производству скрепок.

Игра очень простая (как и любой кликер), но и очень затягивающая. За 11 дней в неё сыграли 450 тысяч человек. Я потратил на неё три часа своих выходных. Не повторяйте мою ошибку! Лучше почитайте текст, в котором на примере этой игры популярно объясняют концепцию аморального, но эффективного ИИ: https://www.wired.com/story/the-way-the-world-ends-not-with-a-bang-but-a-paperclip/

Перевод: https://theidealist.ru/paperclipgame/

Но если у вас много свободного времени, можете попробовать уничтожить мир: http://www.decisionproblem.com/paperclips/index2.html

2017 October 23

Продолжаем тему искуственного интеллекта и морали. Из примера со скрепками мы поняли, что умные машины должны быть запрограммированы не только на эффективное выполнение задач, но и на гуманное поведение. Но как запрограммировать мораль? С очевидными правилами вроде "Нельзя убивать людей" всё понятно. Но реальные жизненные дилеммы намного сложнее. К тому же, у разных людей разные понятия о том, что такое хорошо, а что такое плохо. Так какие принципы поведения тогда зашивать в машину?

В июле прошлого года MIT Media Lab запустила интересный тест. В нём вы должны принять решение за беспилотную машину, которая несётся со сломанными тормозами. Ехать прямо и сбить маму с ребенком или свернуть влево и сбить мужчину? Врезаться в бетонную преграду и убить пассажира или свернуть и убить пешехода? Классическая "дилемма вагонетки", примененная к действительно актуальной проблеме. Этот тест прошли 1,3 миллиона человек, а его создатели получили 18 миллионов ответов на моральные дилеммы - неплохой материал для моделирования "коллективной морали". На основе этих данных учёные из MIT и Карнеги-Мелон разработали систему для принятия этических решений. Неплохая идея, но полученная система в итоге этична настолько же, насколько и полтора миллиона случайных людей из интернета, желающих поиграться в машину-убийцу. Её решения отображают стереотипы общества: к примеру, она скорее убьет бездомного или преступника, чем обычного человека.

https://theoutline.com/post/2401/what-would-the-average-human-do

А вот сам тест, если не видели - покликайте, забавная штука: http://moralmachine.mit.edu. Когда я проходил его год назад, я долго мучился на некоторых вопросах, оценивая, чьи жизни важнее. А теперь решил пройти ещё раз и только сейчас заметил, что почти в каждом примере приходится выбирать между убийством людей, которые нарушают правила дорожного движения (переходят на красный), и тех, кто не нарушает правила. Это сильно упростило задачу - я просто каждый раз выбирал убивать тех, кто нарушает правила. Действительно, мораль уже вшита в формальные правила поведения на дороге. Нарушаешь ПДД - рискуешь жизнью. Исходя из того же принципа, я легко сделал выбор между "врезаться в отбойник, убив пассажира" и "свернуть, спасти пассажира, убить пешехода". Пешеход ни в чем не виноват. Если он не нарушает правила движения, он не должен страдать от неполадок беспилотной машины. А вот её пассажиры, садясь в машину, принимают на себя риски, в том числе и связанные с отказом тормозов. Логично?

В июле прошлого года MIT Media Lab запустила интересный тест. В нём вы должны принять решение за беспилотную машину, которая несётся со сломанными тормозами. Ехать прямо и сбить маму с ребенком или свернуть влево и сбить мужчину? Врезаться в бетонную преграду и убить пассажира или свернуть и убить пешехода? Классическая "дилемма вагонетки", примененная к действительно актуальной проблеме. Этот тест прошли 1,3 миллиона человек, а его создатели получили 18 миллионов ответов на моральные дилеммы - неплохой материал для моделирования "коллективной морали". На основе этих данных учёные из MIT и Карнеги-Мелон разработали систему для принятия этических решений. Неплохая идея, но полученная система в итоге этична настолько же, насколько и полтора миллиона случайных людей из интернета, желающих поиграться в машину-убийцу. Её решения отображают стереотипы общества: к примеру, она скорее убьет бездомного или преступника, чем обычного человека.

https://theoutline.com/post/2401/what-would-the-average-human-do

А вот сам тест, если не видели - покликайте, забавная штука: http://moralmachine.mit.edu. Когда я проходил его год назад, я долго мучился на некоторых вопросах, оценивая, чьи жизни важнее. А теперь решил пройти ещё раз и только сейчас заметил, что почти в каждом примере приходится выбирать между убийством людей, которые нарушают правила дорожного движения (переходят на красный), и тех, кто не нарушает правила. Это сильно упростило задачу - я просто каждый раз выбирал убивать тех, кто нарушает правила. Действительно, мораль уже вшита в формальные правила поведения на дороге. Нарушаешь ПДД - рискуешь жизнью. Исходя из того же принципа, я легко сделал выбор между "врезаться в отбойник, убив пассажира" и "свернуть, спасти пассажира, убить пешехода". Пешеход ни в чем не виноват. Если он не нарушает правила движения, он не должен страдать от неполадок беспилотной машины. А вот её пассажиры, садясь в машину, принимают на себя риски, в том числе и связанные с отказом тормозов. Логично?