Size: a a a

2019 June 03

нововведение в apple watch: теперь там есть калькулятор. Зал визжит от восторга. Теперь то заживем. Вот чего нам не хватало

2019 June 04

если вас спросят зачем вам 3D принтер - покажите им эти фотографии

2019 June 05

Новости IT, среда, 05.06.2019

Глава Bethesda: Люди купят что угодно, но предлагать им это

необязательно

https://u.to/kIqXFQ

Новый удар по Китаю. AMD лишила страну технологий по производству процессоров

https://u.to/o4mXFQ

Apple посмеялась над Android на презентации iOS 13

https://u.to/iD6XFQ

AMD и Samsung добавят графику Radeon на смартфоны

https://u.to/dUaXFQ

Рендеры и подробности по неанонсированной защищенке Samsung XCover 4s

https://u.to/FkeXFQ

#news

Глава Bethesda: Люди купят что угодно, но предлагать им это

необязательно

https://u.to/kIqXFQ

Новый удар по Китаю. AMD лишила страну технологий по производству процессоров

https://u.to/o4mXFQ

Apple посмеялась над Android на презентации iOS 13

https://u.to/iD6XFQ

AMD и Samsung добавят графику Radeon на смартфоны

https://u.to/dUaXFQ

Рендеры и подробности по неанонсированной защищенке Samsung XCover 4s

https://u.to/FkeXFQ

#news

Факапы, история 2

Мы используем kubernetes в google и эта история будет про него.

У гугла с кубом довольно интересный момент, который вы не контролируете. Эти друзья могут в любой момент без предупреждения вырубить вашу ноду. Чем это для вас может грозить? Начнем с того, что окей, кубернетес умеет переподнимать убитые контейнеры, но как бы то ни было это все равно время. Хорошо, если у вас были настроены реплики и попали они на разные ноды, а гугл их вырубил в разное время. Если же нет - вас ожидает сюрприз в виде небольшого простоя. Когда умирает один контейнер и куб поднимает его на другой ноде - это все происходит быстро. Когда у вас умирает целая нода, на которой быть может 100-200-300 или больше контейнеров - это уже немножечко больно. Как минимум потому что нужно скачать образа (если их нет), а затем все это запустить. Все эти контейнеры, отправленные в свободный полет размажутся по кластеру и будут там запущены. На этом бы история закончилась, но в этот момент вылезла проблема - на нодах стала кончаться память. Как это происходит? на сервер набивается некоторое количество контейнеров, кто-то обжирается памяти, приходит OOM и прибивает обожравшийся контейнер. Верно? на самом деле нет. В реалиях ООМ убивает что под руку подвернется. Что происходит дальше? А дальше идет веселуха с Liveness, Readiness пробами. Это такой волшебный функционал, который позволяет приложению выполнять селфчек (например, доступность разнообразных бэкендов) а затем отчитываться кластеру, что приложение готово к работе. Или не готово. И тогда кластер пытается перезапустить приложение. А теперь смотрите что происходит. Перезапуск приложения по ООМ чаще всего ведет к тому что приложение мигрирует на другой сервер. Перезапуск по пробе - обычно ведет к тому что приложение локально перезапускается. Смигрировавшее на другой сервер приложение (приложения) приводят к тому, что добрый дядюшка ООМ приходит на эти сервера. И убивает их там. Или не их, а кого-то еще. Это ведет к тому, что чей-то бекенд (кого убили) может стать недоступен и из-за этого кто-то помирает по пробе. А этот кто помер по пробе снова может быть чьей-то зависимостью. И он тоже помрет по пробе. И вот такая карусель будет продолжаться пока у вас на перезапущенную ноду не приедет достаточное колиество приложений, которые с нее уехали и стали мешать другим нодам.

Вы спросите, почему не распределяется нагрузка равномерно? Всего этого можно было бы избежать, если бы были настроены лимиты. В кубернетесе существуют ограничения по ресурсам для приложения, которое можно ограничить с двух сторон - requests (сколько приложению требуется) и limits (верхний потолок сколько мы разрешаем приложению потреблять). Таким образом, вычисляется сумма всех request приложений приехавших на ноду и новые приложения, если их request < количества свободной памяти уже на ноду не приедут.

Ну и на сладкое. Гугл после перезагрузки ноды может сменить ее белый адрес. Если у вас есть какой-то внешний сервис, который по iptables ограничивает трафик и принимает его только с этого адреса ноды, вас ждет сюрприз. После ребута ноды вы можете этот трафик потерять. Придется идти и править фильтруемое значение.

З.Ы. эта история является продолжением предыдущего факапа и случилась примерно в одно и то же время с ней. Поэтому прошу не думать, что мы не учимся на своих ошибках и не ввели лимиты с прошлого раза.

#fuckup

Мы используем kubernetes в google и эта история будет про него.

У гугла с кубом довольно интересный момент, который вы не контролируете. Эти друзья могут в любой момент без предупреждения вырубить вашу ноду. Чем это для вас может грозить? Начнем с того, что окей, кубернетес умеет переподнимать убитые контейнеры, но как бы то ни было это все равно время. Хорошо, если у вас были настроены реплики и попали они на разные ноды, а гугл их вырубил в разное время. Если же нет - вас ожидает сюрприз в виде небольшого простоя. Когда умирает один контейнер и куб поднимает его на другой ноде - это все происходит быстро. Когда у вас умирает целая нода, на которой быть может 100-200-300 или больше контейнеров - это уже немножечко больно. Как минимум потому что нужно скачать образа (если их нет), а затем все это запустить. Все эти контейнеры, отправленные в свободный полет размажутся по кластеру и будут там запущены. На этом бы история закончилась, но в этот момент вылезла проблема - на нодах стала кончаться память. Как это происходит? на сервер набивается некоторое количество контейнеров, кто-то обжирается памяти, приходит OOM и прибивает обожравшийся контейнер. Верно? на самом деле нет. В реалиях ООМ убивает что под руку подвернется. Что происходит дальше? А дальше идет веселуха с Liveness, Readiness пробами. Это такой волшебный функционал, который позволяет приложению выполнять селфчек (например, доступность разнообразных бэкендов) а затем отчитываться кластеру, что приложение готово к работе. Или не готово. И тогда кластер пытается перезапустить приложение. А теперь смотрите что происходит. Перезапуск приложения по ООМ чаще всего ведет к тому что приложение мигрирует на другой сервер. Перезапуск по пробе - обычно ведет к тому что приложение локально перезапускается. Смигрировавшее на другой сервер приложение (приложения) приводят к тому, что добрый дядюшка ООМ приходит на эти сервера. И убивает их там. Или не их, а кого-то еще. Это ведет к тому, что чей-то бекенд (кого убили) может стать недоступен и из-за этого кто-то помирает по пробе. А этот кто помер по пробе снова может быть чьей-то зависимостью. И он тоже помрет по пробе. И вот такая карусель будет продолжаться пока у вас на перезапущенную ноду не приедет достаточное колиество приложений, которые с нее уехали и стали мешать другим нодам.

Вы спросите, почему не распределяется нагрузка равномерно? Всего этого можно было бы избежать, если бы были настроены лимиты. В кубернетесе существуют ограничения по ресурсам для приложения, которое можно ограничить с двух сторон - requests (сколько приложению требуется) и limits (верхний потолок сколько мы разрешаем приложению потреблять). Таким образом, вычисляется сумма всех request приложений приехавших на ноду и новые приложения, если их request < количества свободной памяти уже на ноду не приедут.

Ну и на сладкое. Гугл после перезагрузки ноды может сменить ее белый адрес. Если у вас есть какой-то внешний сервис, который по iptables ограничивает трафик и принимает его только с этого адреса ноды, вас ждет сюрприз. После ребута ноды вы можете этот трафик потерять. Придется идти и править фильтруемое значение.

З.Ы. эта история является продолжением предыдущего факапа и случилась примерно в одно и то же время с ней. Поэтому прошу не думать, что мы не учимся на своих ошибках и не ввели лимиты с прошлого раза.

#fuckup

2019 June 06

Новости IT, четверг, 06.06.2019

iPadOS: она существует и мы ее уже установили!

https://u.to/hBaZFQ

Huawei выпустила новую прошивку EMUI 9 для множества популярных смартфонов.

https://u.to/cReZFQ

URCDKeys: ключи для Windows 10 и Microsoft Office по смешным ценам

https://u.to/dBiZFQ

«Яндекс.Телефон» сокрушительно рухнул в цене. Сейчас его продают за копейки

https://u.to/jRmZFQ

#news

iPadOS: она существует и мы ее уже установили!

https://u.to/hBaZFQ

Huawei выпустила новую прошивку EMUI 9 для множества популярных смартфонов.

https://u.to/cReZFQ

URCDKeys: ключи для Windows 10 и Microsoft Office по смешным ценам

https://u.to/dBiZFQ

«Яндекс.Телефон» сокрушительно рухнул в цене. Сейчас его продают за копейки

https://u.to/jRmZFQ

#news

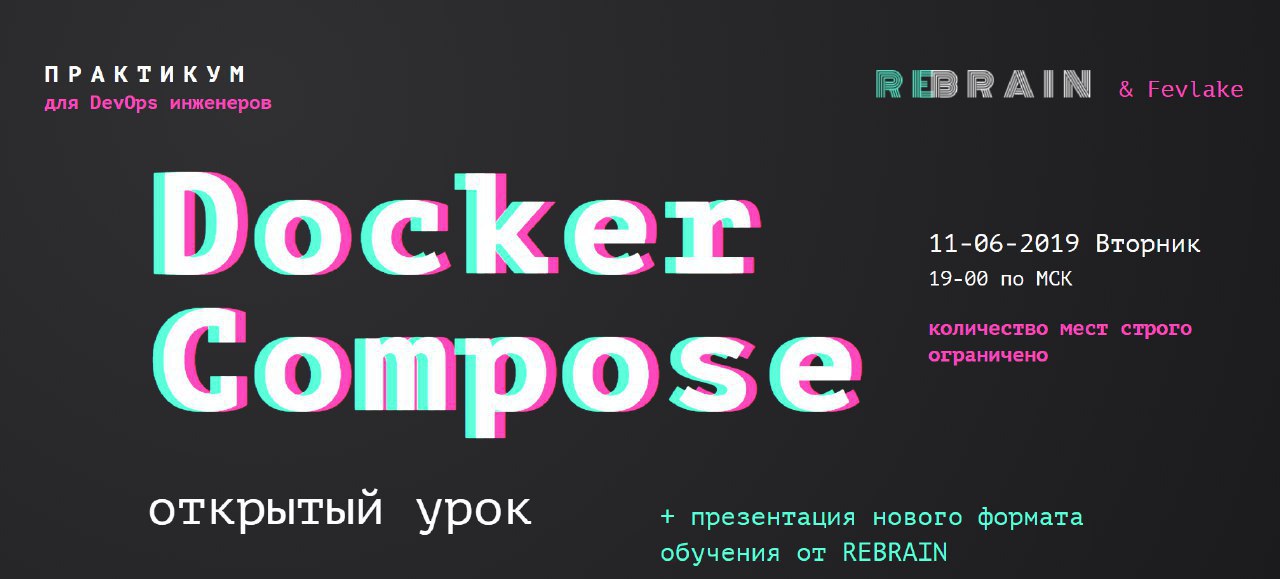

Бесплатный онлайн практикум DevOps by REBRAIN: Docker Compose

Регистрация - http://bit.ly/2XslsAr

Количество мест строго ограничено!

Практикум по освоению DevOps

Время проведения:

11 Июня (Вторник) в 19:00 по МСК

Что будет на практикуме?

🔹Как докер объединяет контейнеры?

🔹Используем разные сети для разделения контейнеров.

🔹Зачем докеру iptables или как работает сеть.

🔹Запускаем redash с помощью docker compose.

Кто ведет?

Василий Озеров - основатель агентства Fevlake (fevlake.com) и действующий Devops-инженер (опыт в Devops более 5 лет). Регулярно выступает на RootConf, DevOpsConf Russia, HighLoad.

Открытые еженедельные DevOps практикумы - https://bit.ly/2CGmm3C

Присоединяйтесь!

#реклама

Регистрация - http://bit.ly/2XslsAr

Количество мест строго ограничено!

Практикум по освоению DevOps

Время проведения:

11 Июня (Вторник) в 19:00 по МСК

Что будет на практикуме?

🔹Как докер объединяет контейнеры?

🔹Используем разные сети для разделения контейнеров.

🔹Зачем докеру iptables или как работает сеть.

🔹Запускаем redash с помощью docker compose.

Кто ведет?

Василий Озеров - основатель агентства Fevlake (fevlake.com) и действующий Devops-инженер (опыт в Devops более 5 лет). Регулярно выступает на RootConf, DevOpsConf Russia, HighLoad.

Открытые еженедельные DevOps практикумы - https://bit.ly/2CGmm3C

Присоединяйтесь!

#реклама

Регистрация: http://bit.ly/2XslsAr

Можно в телеграме качать книги

Канал - @flibustafreebook

Чат - @flibustabotgroup

Вопросы и предложения - @iliya_c https://t.me/flibustafreebookbot

Канал - @flibustafreebook

Чат - @flibustabotgroup

Вопросы и предложения - @iliya_c https://t.me/flibustafreebookbot

для забывчивых людей...

UPD: добавлен выход если кол-во аргументов пустое

#bash_alias

kubectl ()Написал несколько функций, которые при использовании команд helm, kubectl подставляют вам в PS1 имя текущего контекста. Помогает когда у вас более нескольких кластеров и вы иногда выполняете команды не в том кластере, в котором хотели.

{

PS1="\e[1;31m $(/usr/bin/kubectl config current-context) \e[m \[\e]0;\u@\h: \w\a\]\[\033[01;32m\]\u@\h\[\033[00m\]:\[\033[01;34m\]\w\[\033[00m\]$ "

if [[ "$#" == "0" ]]; then return; fi

/usr/bin/kubectl "$@"

PS1="\e[1;31m $(/usr/bin/kubectl config current-context) \e[m \[\e]0;\u@\h: \w\a\]\[\033[01;32m\]\u@\h\[\033[00m\]:\[\033[01;34m\]\w\[\033[00m\]$ "

}

helm ()

{

PS1="\e[1;31m $(/usr/bin/kubectl config current-context) \e[m \[\e]0;\u@\h: \w\a\]\[\033[01;32m\]\u@\h\[\033[00m\]:\[\033[01;34m\]\w\[\033[00m\]$ "

if [[ "$#" == "0" ]]; then return; fi

read -p "Context $(tput setaf 1)$(/usr/bin/kubectl config current-context)$(tput sgr 0) is proper? [Y/n]: " userinput

if [[ ! "$userinput" == "" ]]; then return; fi

/usr/local/bin/helm "$@"

}

UPD: добавлен выход если кол-во аргументов пустое

#bash_alias

2019 June 07

Новости IT, пятница, 07.06.2019

Популярные приложения из Google Play выводят из строя Android-смартфоны

https://u.to/cByZFQ

Amazon показала шестиугольный беспилотник для доставки товаров.

https://u.to/swGbFQ

Появились скриншоты операционной системы Hongmeng

https://u.to/GOqaFQ

Группа разработчиков приложений для iOS подала в суд на Apple — они недовольны требованиями в App Store

https://u.to/AOuaFQ

Правительство РФ заступилось за «Яндекс» в конфликте с ФСБ

https://u.to/IeyaFQ

#news

Популярные приложения из Google Play выводят из строя Android-смартфоны

https://u.to/cByZFQ

Amazon показала шестиугольный беспилотник для доставки товаров.

https://u.to/swGbFQ

Появились скриншоты операционной системы Hongmeng

https://u.to/GOqaFQ

Группа разработчиков приложений для iOS подала в суд на Apple — они недовольны требованиями в App Store

https://u.to/AOuaFQ

Правительство РФ заступилось за «Яндекс» в конфликте с ФСБ

https://u.to/IeyaFQ

#news

2019 June 10

Новости IT, понедельник, 10.06.2019

Как создавался новый Mac Pro

https://u.to/iF6gFQ

MSI троллит Apple: зачем покупать подставку для монитора за $1000, если за $1300 можно купить монитор 5К с подставкой?

https://u.to/4F6gFQ

Смартфоном с лучшей камерой оказался неожиданный кандидат

https://u.to/q1_gFQ

Почему Android Q больше не будет автоматически подключаться к Wi-Fi, от которого вы отключились

https://u.to/c2CgFQ

Нейросеть NTechLab заняла второе место на конкурсе NIST по распознаванию действий на видео

https://u.to/WGGgFQ

#news

Как создавался новый Mac Pro

https://u.to/iF6gFQ

MSI троллит Apple: зачем покупать подставку для монитора за $1000, если за $1300 можно купить монитор 5К с подставкой?

https://u.to/4F6gFQ

Смартфоном с лучшей камерой оказался неожиданный кандидат

https://u.to/q1_gFQ

Почему Android Q больше не будет автоматически подключаться к Wi-Fi, от которого вы отключились

https://u.to/c2CgFQ

Нейросеть NTechLab заняла второе место на конкурсе NIST по распознаванию действий на видео

https://u.to/WGGgFQ

#news

wanna play a game? @offzone2019hackquest

Как и в прошлый раз, хакквест будет проводиться в боте @offzone_hq_bot

Для начала потребуется зарегистрироваться как участник командной /register

После можно посмотреть правила /rules, но там ничего нового не появилось, даже бонусный флаг прежний, правда на этот раз это просто пример.

В случае, если вам показалось, что что-то пошло не так, можно через бота отправить сообщением нам, с помощью команды /report

Кроме того, в этот раз мы запустили чат для общения участников, чтобы вам проще было обмениваться хинтами: @hackQuestByWallarm

И для того, чтобы растянуть удовольствие, задания будут открываться по одному в день. Первый таск будет сегодня, через час. Все открытые задания можно посмотреть командой /tasks

Для начала потребуется зарегистрироваться как участник командной /register

После можно посмотреть правила /rules, но там ничего нового не появилось, даже бонусный флаг прежний, правда на этот раз это просто пример.

В случае, если вам показалось, что что-то пошло не так, можно через бота отправить сообщением нам, с помощью команды /report

Кроме того, в этот раз мы запустили чат для общения участников, чтобы вам проще было обмениваться хинтами: @hackQuestByWallarm

И для того, чтобы растянуть удовольствие, задания будут открываться по одному в день. Первый таск будет сегодня, через час. Все открытые задания можно посмотреть командой /tasks

Выступал сегодня на ctf.moscow 2019. Большое спасибо @Dok2d за видеобработку!