ВН

Size: a a a

2021 January 16

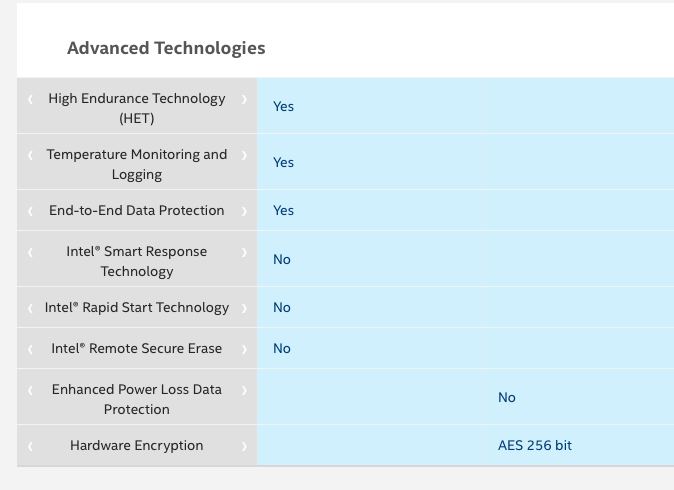

а на dc 4800 вообще этой характеристики нет 😳

А я нашел

ВН

Интересно шо они этим хотят сказать

Am

Интересно шо они этим хотят сказать

есть кондеры и нет кондеров

ВН

есть кондеры и нет кондеров

Ну вроде бы и да но вроде ж они писали что оптанам они нинужны

Am

Ну вроде бы и да но вроде ж они писали что оптанам они нинужны

я такого не видел. по идее у них все равно есть какой-то минимальный кеш на контролере вот его и надо защитиь

Am

понятно что там в идеале должно быть полторы операции

A

Всем здоровья, вот такую штуку сегодня словил, при копировании снапшота из одного пула в другой:

[Sat Jan 16 01:22:13 2021] EXT4-fs (rbd4): write access unavailable, skipping orphan cleanupПосле этого rbd4 естественно неалё, и при попытке сделать unmap ловим:

[Sat Jan 16 01:22:13 2021] EXT4-fs (rbd4): mounted filesystem without journal. Opts: noload

[Sat Jan 16 01:22:13 2021] EXT4-fs (rbd6): mounted filesystem with ordered data mode. Opts: (null)

[Sat Jan 16 01:52:34 2021] EXT4-fs error (device rbd4): ext4_lookup:1593: inode #9311514: comm rsync: deleted inode referenced: 9306121

[Sat Jan 16 01:52:34 2021]

Assertion failure in rbd_queue_workfn() at line 4035:

rbd_assert(op_type == OBJ_OP_READ || rbd_dev->spec->snap_id == CEPH_NOSNAP);

[Sat Jan 16 01:52:34 2021] ------------[ cut here ]------------

[Sat Jan 16 01:52:34 2021] kernel BUG at drivers/block/rbd.c:4035!

[Sat Jan 16 01:52:34 2021] invalid opcode: 0000 [#1] SMP NOPTI

...

rbd: sysfs write failedВопрос: можно-ли как-то обходить подобное без ребута?

TASK ERROR: can't unmap rbd device /dev/rbd/rbd_pool2/vm-107-disk-0@snap1: rbd: sysfs write failed

ceph version 12.2.13 (98af9a6b9a46b2d562a0de4b09263d70aeb1c9dd) luminous (stable)

Е

Всем здоровья, вот такую штуку сегодня словил, при копировании снапшота из одного пула в другой:

[Sat Jan 16 01:22:13 2021] EXT4-fs (rbd4): write access unavailable, skipping orphan cleanupПосле этого rbd4 естественно неалё, и при попытке сделать unmap ловим:

[Sat Jan 16 01:22:13 2021] EXT4-fs (rbd4): mounted filesystem without journal. Opts: noload

[Sat Jan 16 01:22:13 2021] EXT4-fs (rbd6): mounted filesystem with ordered data mode. Opts: (null)

[Sat Jan 16 01:52:34 2021] EXT4-fs error (device rbd4): ext4_lookup:1593: inode #9311514: comm rsync: deleted inode referenced: 9306121

[Sat Jan 16 01:52:34 2021]

Assertion failure in rbd_queue_workfn() at line 4035:

rbd_assert(op_type == OBJ_OP_READ || rbd_dev->spec->snap_id == CEPH_NOSNAP);

[Sat Jan 16 01:52:34 2021] ------------[ cut here ]------------

[Sat Jan 16 01:52:34 2021] kernel BUG at drivers/block/rbd.c:4035!

[Sat Jan 16 01:52:34 2021] invalid opcode: 0000 [#1] SMP NOPTI

...

rbd: sysfs write failedВопрос: можно-ли как-то обходить подобное без ребута?

TASK ERROR: can't unmap rbd device /dev/rbd/rbd_pool2/vm-107-disk-0@snap1: rbd: sysfs write failed

ceph version 12.2.13 (98af9a6b9a46b2d562a0de4b09263d70aeb1c9dd) luminous (stable)

а как так-то? Примапили с двух точек?

2021 January 17

A

а как так-то? Примапили с двух точек?

Да нет, просто свалилось во время копирования

AG

Коллеги добрый день, подскажите что можно сдеть в RGW для ускорения?

rgw 13.2.4

на PUT в несколько тредов не получается получить больше 30мб\с

если сделать 4 rgw с haproxy перед ними - картина абсолютно такая же

тоже почему-то никаких изменений не привносит

rgw 13.2.4

rgw frontends = beast port=7480 tcp_nodelay=1

на PUT в несколько тредов не получается получить больше 30мб\с

если сделать 4 rgw с haproxy перед ними - картина абсолютно такая же

rgw frontends = civetweb port=7480 num_threads=1000

rgw cache enabled = true

rgw cache lru size = 100000

тоже почему-то никаких изменений не привносит

подбил?

YG

добрый день. подскажите, где указывать свои конфигурационные данные при разворачивании кластера с помощью ceph-deploy. указываю osd_pool_default_size: 1 в ceph.conf (в директории откуда запускаю ceph-deploy), а на выходе получаю кластер с osd_pool_default_size: 3

YG

мб на каком-то этапе нужен ключ --overwrite-conf?

YG

получилось. неправильно конфигурил

k

получилось. неправильно конфигурил

В воскресенье - вообще не правильно

YG

2021 January 18

VO

ебздысь!

2021-01-18 00:17:40.137 7f57b4dd4c00 0 <cls> /build/ceph-14.2.16/src/cls/cephfs/cls_cephfs.cc:197: loading cephfs

2021-01-18 00:17:40.141 7f57b4dd4c00 0 _get_class not permitted to load kvs

2021-01-18 00:17:40.141 7f57b4dd4c00 0 _get_class not permitted to load lua

2021-01-18 00:17:40.153 7f57b4dd4c00 0 <cls> /build/ceph-14.2.16/src/cls/hello/cls_hello.cc:296: loading cls_hello

2021-01-18 00:17:40.153 7f57b4dd4c00 0 _get_class not permitted to load sdk

2021-01-18 00:17:40.153 7f57b4dd4c00 0 osd.330 118985 crush map has features 432629239337189376, adjusting msgr requires for clients

2021-01-18 00:17:40.153 7f57b4dd4c00 0 osd.330 118985 crush map has features 432629239337189376 was 8705, adjusting msgr requires for mons

2021-01-18 00:17:40.153 7f57b4dd4c00 0 osd.330 118985 crush map has features 3314933000854323200, adjusting msgr requires for osds

2021-01-18 00:17:40.417 7f57b4dd4c00 0 osd.330 118985 load_pgs

2021-01-18 00:17:45.701 7f57b4dd4c00 -1 *** Caught signal (Aborted) **

in thread 7f57b4dd4c00 thread_name:ceph-osd

ceph version 14.2.16 (762032d6f509d5e7ee7dc008d80fe9c87086603c) nautilus (stable)

1: (()+0x12980) [0x7f57b29b6980]

2: (gsignal()+0xc7) [0x7f57b1668fb7]

3: (abort()+0x141) [0x7f57b166a921]

4: (()+0x8c957) [0x7f57b205d957]

5: (()+0x92ae6) [0x7f57b2063ae6]

6: (()+0x92b21) [0x7f57b2063b21]

7: (()+0x92d54) [0x7f57b2063d54]

8: (()+0x1424b) [0x7f57b428424b]

9: (tc_new()+0x283) [0x7f57b42a5943]

10: (PGLog::IndexedLog::IndexedLog(PGLog::IndexedLog const&)+0xdd) [0x5606a8231a6d]

11: (void PGLog::read_log_and_missing<pg_missing_set<true> >(ObjectStore*, boost::intrusive_ptr<ObjectStore::CollectionImpl>&, ghobject_t, pg_info_t const&, PGLog::IndexedLog&, pg_missing_set<true>&, std::__cxx11::basic_ostringstream<char, std::char_traits<char>, std::allocator<char> >&, bool, bool*, DoutPrefixProvid

er const*, std::set<std::__cxx11::basic_string<char, std::char_traits<char>, std::allocator<char> >, std::less<std::__cxx11::basic_string<char, std::char_traits<char>, std::allocator<char> > >, std::allocator<std::__cxx11::basic_string<char, std::char_traits<char>, std::allocator<char> > > >*, bool)+0x6b7) [0x5606a823

b887]

YG

health: HEALTH_WARN

3 pool(s) have no replicas configured

application not enabled on 1 pool(s)

подскажите пожалуйста как сделать кластер "здоровым". мне не нужна репликация, osd_pool_default_size: 1 выставлено, но варны приходят. и при создании rbd выскакивает application not enabled on 1 pool(s). это как-то можно победить?

3 pool(s) have no replicas configured

application not enabled on 1 pool(s)

подскажите пожалуйста как сделать кластер "здоровым". мне не нужна репликация, osd_pool_default_size: 1 выставлено, но варны приходят. и при создании rbd выскакивает application not enabled on 1 pool(s). это как-то можно победить?

AS

В доке поиск по “ceph osd pool application enable <pool-name> <app-name>”

ответ на второй алерт