AN

Size: a a a

2021 September 06

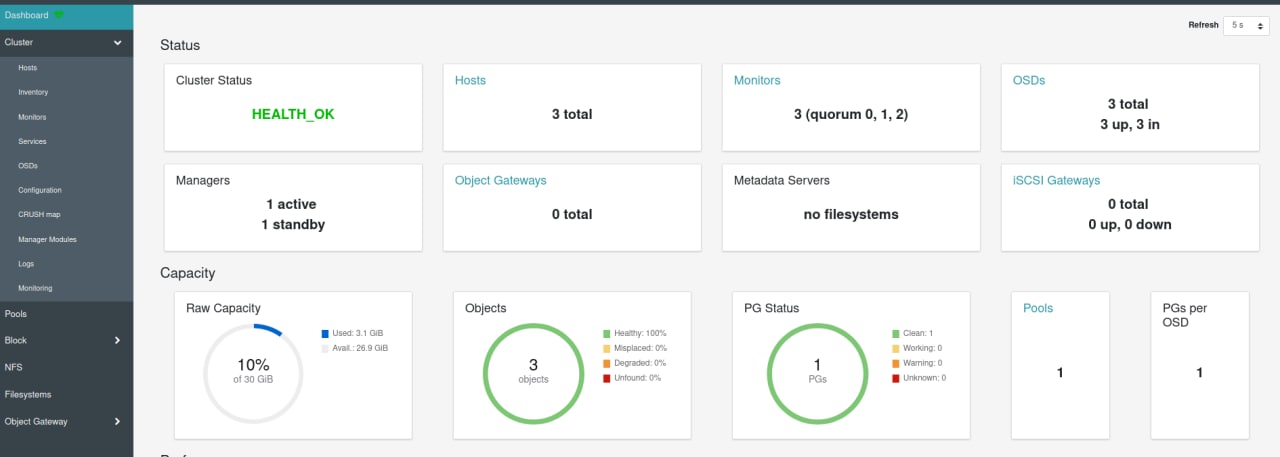

Запусти принудительно scrub на всех OSD.

DR

посмотри через ceph -s, посмотри ceph df, какой пул забит

(кстати, capacity в 30 гб - мощно)

(кстати, capacity в 30 гб - мощно)

DR

плюс, как я понял, у тебя rbd, а там есть отложенное удаление

DR

rbd trash ls

AS

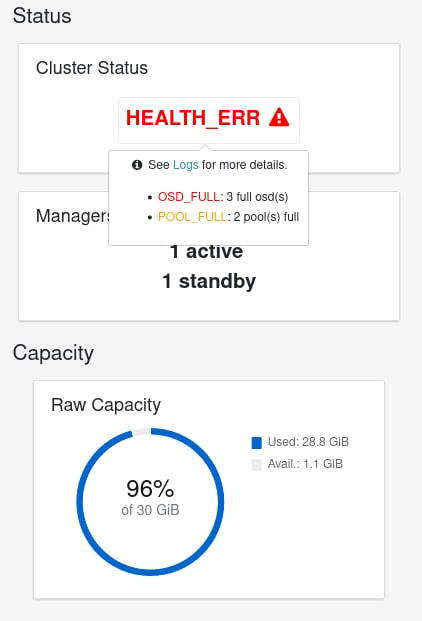

походу накрылось все медным тазом

я почему не могу удалить replicapool

я так понял что его и нет

[root@rook-ceph-tools-77f4f75cdd-7mklh /]# rbd trash list

rbd: error opening default pool 'rbd'

Ensure that the default pool has been created or specify an alternate pool name.

я почему не могу удалить replicapool

я так понял что его и нет

[root@rook-ceph-tools-77f4f75cdd-7mklh /]# rbd trash list

rbd: error opening default pool 'rbd'

Ensure that the default pool has been created or specify an alternate pool name.

AS

[root@rook-ceph-tools-77f4f75cdd-7mklh /]# ceph df

--- RAW STORAGE ---

CLASS SIZE AVAIL USED RAW USED %RAW USED

hdd 30 GiB 914 MiB 26 GiB 29 GiB 97.02

TOTAL 30 GiB 914 MiB 26 GiB 29 GiB 97.02

--- POOLS ---

POOL ID PGS STORED OBJECTS USED %USED MAX AVAIL

device_health_metrics 1 1 52 KiB 3 155 KiB 100.00 0 B

replicapool 2 32 8.7 GiB 2.32k 26 GiB 100.00 0 B

--- RAW STORAGE ---

CLASS SIZE AVAIL USED RAW USED %RAW USED

hdd 30 GiB 914 MiB 26 GiB 29 GiB 97.02

TOTAL 30 GiB 914 MiB 26 GiB 29 GiB 97.02

--- POOLS ---

POOL ID PGS STORED OBJECTS USED %USED MAX AVAIL

device_health_metrics 1 1 52 KiB 3 155 KiB 100.00 0 B

replicapool 2 32 8.7 GiB 2.32k 26 GiB 100.00 0 B

W

Дропни replicapool, он у тебя все место выжрал. Или данные в нём.

Или

ceph osd pool remove replicapool replicapool --yes-bletИли

rbd -p replicapool lsrbd remove replicapool/$image_nameAS

Спасибо, ожил ceph

W

Ну прост доку почитай как rbd юзать и всё. А ещё лучше смотреть стату через консольку. Надежнее и проще, дашборд порой отваливается и тупит. Им вообще я давно не пользовался...

google:

ceph statusceph healt detailceph osd tree

ceph osd df

google:

ceph rbd usageceph perfomanceceph troubleshootingAS

90%

storage: 9Gi

где 20% нужно оставлять?

storage: 9Gi

где 20% нужно оставлять?

AS

опять та же хреть

AS

volume намертво повисает

E

у тебя 30 гигабайт всего на дисках, сохраняешь ты три копии данных, тоесть 30/3 = 10Гб стореджа у тебя всего доступно, чтобы диск небыл забит, надо хранить не больше 8Гб

ВН

30 гб это пикокластер

ВН

Там базы же одни по паре гигов сожрут на каждом осд

Am

да не, на таких объемах не сожрут

E

та я думаю не сожрут, там данных нет чтобы жрать :)

E

тут больше вопрос при создании OSD сколько он от диска отожрет для резерва под базу