VI

clickhouse:

image: yandex/clickhouse-server

volumes:

- ./var/docker/clickhouse:/var/lib/clickhouse

ports:

- 8124:8123

- 9001:9000

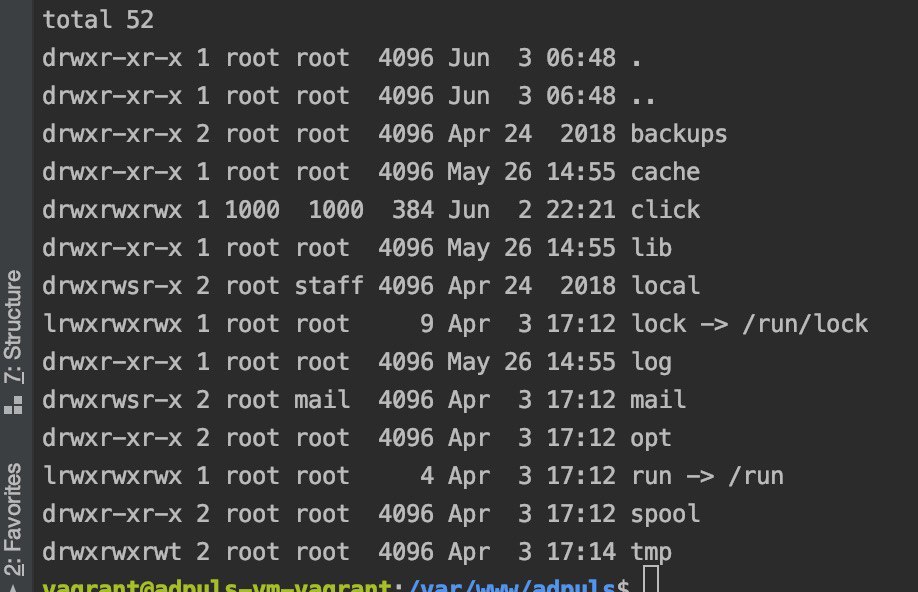

у меня почему-то падает контейнер

Size: a a a

VI

clickhouse:

image: yandex/clickhouse-server

volumes:

- ./var/docker/clickhouse:/var/lib/clickhouse

ports:

- 8124:8123

- 9001:9000

A

A

MATERIALIZED VIEW … TO … и навесить еще одно представление к конечной таблицы что бы из нее переливать в другую таблицу?DC

MATERIALIZED VIEW … TO … и навесить еще одно представление к конечной таблицы что бы из нее переливать в другую таблицу?DC

MATERIALIZED VIEW … TO … и навесить еще одно представление к конечной таблицы что бы из нее переливать в другую таблицу?DC

KG

_date Date MATERIALIZED toDate(time),.read_shard_0.destination_cluster.mybase.events_test WHERE (toDate(_date) = ('2020-06-01' AS partition_key)) LIMIT 1DC

_date Date MATERIALIZED toDate(time),.read_shard_0.destination_cluster.mybase.events_test WHERE (toDate(_date) = ('2020-06-01' AS partition_key)) LIMIT 1KG

KG

АО

VI

clickhouse:

image: yandex/clickhouse-server

volumes:

- ./var/docker/clickhouse:/var/lib/clickhouse

ports:

- 8124:8123

- 9001:9000

DS

clickhouse:

image: yandex/clickhouse-server

volumes:

- ./var/docker/clickhouse:/var/lib/clickhouse

ports:

- 8124:8123

- 9001:9000

VI

VI

DS

DS

DS

DS

M