DS

Size: a a a

2020 June 11

так и должно быть?

DS

select count(uuid) from access_test;

665

—

а для столбца работает.

665

—

а для столбца работает.

АО

день добрый !

А есть возможность из постгреса получить доступ к данным в клике?

А есть возможность из постгреса получить доступ к данным в клике?

a

было в чате

"можно подключить через fdw к Postgres"

что такое fdw не знаю )

"можно подключить через fdw к Postgres"

что такое fdw не знаю )

АО

Спасибо! сейчас в этом направлении гляну

AT

было в чате

"можно подключить через fdw к Postgres"

что такое fdw не знаю )

"можно подключить через fdw к Postgres"

что такое fdw не знаю )

foreign data wrapper, просто подключаетесь к постгре по сети

a

Спасибо. почитал уже )

D

так и должно быть?

может этому и есть хитрое объяснение ( например count(*) оптимизирован и не читает сами данные), но с высоты полета пользователя КХ это явный баг...

SZ

Добрый день! Прочитал про модель hot-cold данных с ssd/hdd дисками. Кто использовал, можете поделиться опытом с какими трудностями сталкивались?

OB

Привет, всем. Поделитесь настройками конфига для правильной работы TTL. Сейчас у меня в конфиге есть такое

<merge_tree>создаю таблицу так:

<merge_with_ttl_timeout>600</merge_with_ttl_timeout>

<old_parts_lifetime>300</old_parts_lifetime>

<merge_max_block_size>16384</merge_max_block_size>

<temporary_directories_lifetime>600</temporary_directories_lifetime>

<max_part_removal_threads>20</max_part_removal_threads>

</merge_tree>

CREATE TABLE test_ttl ON CLUSTER clusterпри этом данные удаляются по строчно: через 10 минут удалится это

(

dt DateTime,

a String,

b String

)

ENGINE=ReplicatedMergeTree('/clickhouse/tables/{shard}/test_ttl', '{replica}')

PARTITION BY a

PRIMARY KEY (a, b)

ORDER BY (a, b)

ttl dt + interval 10 minute;

CREATE TABLE d_test_ttl ON CLUSTER cluster AS test_ttl

ENGINE = Distributed(cluster, default, test_ttl, halfMD5(a, b));

INSERT INTO d_test_ttl VALUES (now(), 'aaa', '1'),

(now(), 'bbb', '2'),

(now(), 'ccc', '3');

(now(), 'ccc', '3');затем ещё через 10 минут это

(now(), 'bbb', '2')и через 30 минут это

(now(), 'aaa', '1'). Как это пофиксить, чтобы сразу удалялись все устаревшие данные?

АА

всем привет

АА

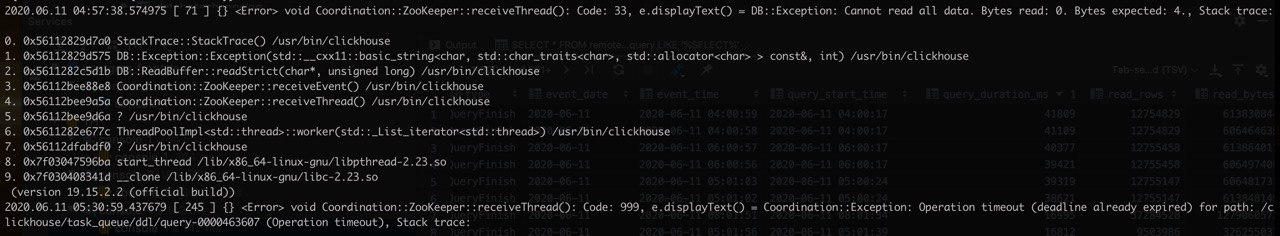

кто-то сталкивался с такой ошибкой?

АА

я предполагаю это из-за того что ЗК находится на той же машине где и КХ

D

Привет, всем. Поделитесь настройками конфига для правильной работы TTL. Сейчас у меня в конфиге есть такое

<merge_tree>создаю таблицу так:

<merge_with_ttl_timeout>600</merge_with_ttl_timeout>

<old_parts_lifetime>300</old_parts_lifetime>

<merge_max_block_size>16384</merge_max_block_size>

<temporary_directories_lifetime>600</temporary_directories_lifetime>

<max_part_removal_threads>20</max_part_removal_threads>

</merge_tree>

CREATE TABLE test_ttl ON CLUSTER clusterпри этом данные удаляются по строчно: через 10 минут удалится это

(

dt DateTime,

a String,

b String

)

ENGINE=ReplicatedMergeTree('/clickhouse/tables/{shard}/test_ttl', '{replica}')

PARTITION BY a

PRIMARY KEY (a, b)

ORDER BY (a, b)

ttl dt + interval 10 minute;

CREATE TABLE d_test_ttl ON CLUSTER cluster AS test_ttl

ENGINE = Distributed(cluster, default, test_ttl, halfMD5(a, b));

INSERT INTO d_test_ttl VALUES (now(), 'aaa', '1'),

(now(), 'bbb', '2'),

(now(), 'ccc', '3');

(now(), 'ccc', '3');затем ещё через 10 минут это

(now(), 'bbb', '2')и через 30 минут это

(now(), 'aaa', '1'). Как это пофиксить, чтобы сразу удалялись все устаревшие данные?

раз в 10 минут запускается *один* мердж. если эти три строки в разных партах, они удалятся за 3 итерации.

можете сделать optimize после вставки в вашем примере, и тогда все 3 удалятся за раз.

можете сделать optimize после вставки в вашем примере, и тогда все 3 удалятся за раз.

АА

так же еще ошибка:

Operation timeout (deadline already expired) for path: /clickhouse/task_queue/ddl/query-0000463607, но я посмотрел даную задача она завершилась

D

Привет, всем. Поделитесь настройками конфига для правильной работы TTL. Сейчас у меня в конфиге есть такое

<merge_tree>создаю таблицу так:

<merge_with_ttl_timeout>600</merge_with_ttl_timeout>

<old_parts_lifetime>300</old_parts_lifetime>

<merge_max_block_size>16384</merge_max_block_size>

<temporary_directories_lifetime>600</temporary_directories_lifetime>

<max_part_removal_threads>20</max_part_removal_threads>

</merge_tree>

CREATE TABLE test_ttl ON CLUSTER clusterпри этом данные удаляются по строчно: через 10 минут удалится это

(

dt DateTime,

a String,

b String

)

ENGINE=ReplicatedMergeTree('/clickhouse/tables/{shard}/test_ttl', '{replica}')

PARTITION BY a

PRIMARY KEY (a, b)

ORDER BY (a, b)

ttl dt + interval 10 minute;

CREATE TABLE d_test_ttl ON CLUSTER cluster AS test_ttl

ENGINE = Distributed(cluster, default, test_ttl, halfMD5(a, b));

INSERT INTO d_test_ttl VALUES (now(), 'aaa', '1'),

(now(), 'bbb', '2'),

(now(), 'ccc', '3');

(now(), 'ccc', '3');затем ещё через 10 минут это

(now(), 'bbb', '2')и через 30 минут это

(now(), 'aaa', '1'). Как это пофиксить, чтобы сразу удалялись все устаревшие данные?

можно заскедулить alter table... materialize ttl;

Оно чистит скопом

Оно чистит скопом

OB

можно заскедулить alter table... materialize ttl;

Оно чистит скопом

Оно чистит скопом

Как это сделать? Средствами СУБД.

D

Как это сделать? Средствами СУБД.

никак (средствами СУБД)

D

Как это сделать? Средствами СУБД.

и вообще каждые 10 минут запускать мердж, если данных много, это зло

OB

и вообще каждые 10 минут запускать мердж, если данных много, это зло

это понятно, я для проверки такой интервал выставил.