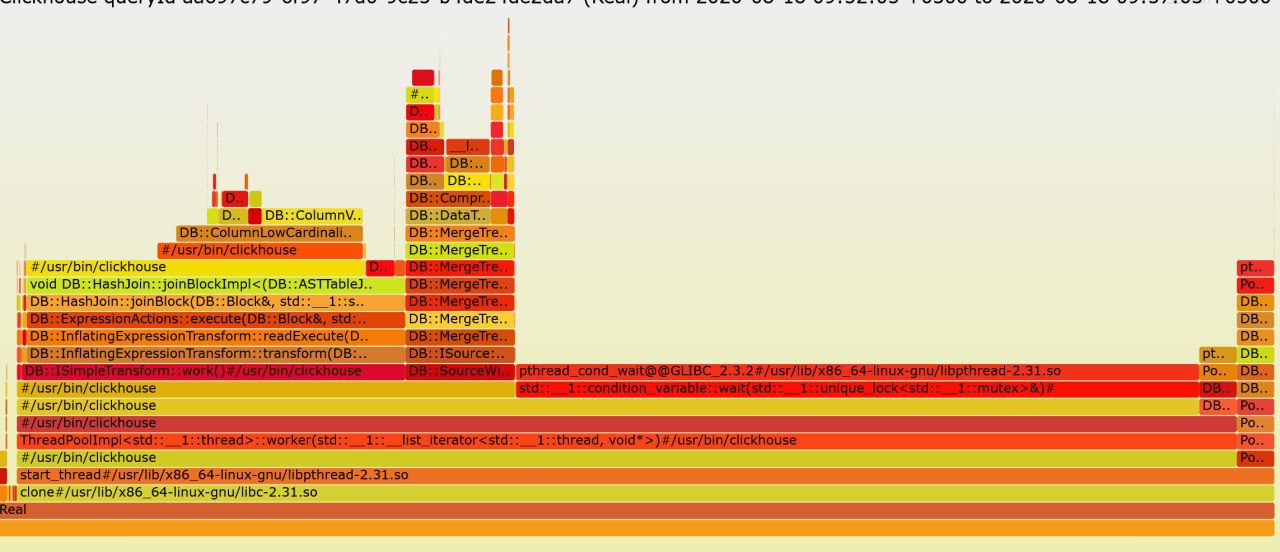

проблема в правой таблице (создании хеша)

create table t1 (f0 UInt64, f1 UInt64, f2 Float64, f3 UInt64) Engine=MergeTree order by f0;

insert into t1 select number, number, number/4345345, intDiv(number,4345345) from numbers(50000000);

set max_threads=1

select t.f0, t.f3, s.* from (select * from t1 limit 1) t asof join t1 s using f0, f2 format Null;

Elapsed: 14.853 sec. Processed 50.00 million rows

set max_threads=16

select t.f0, t.f3, s.* from (select * from t1 limit 1) t asof join t1 s using f0, f2 format Null;

Elapsed: 12.620 sec. Processed 50.00 million rows

select t.f0, t.f3, s.* from t1 t asof join t1 s using f0, f2

Elapsed: 14.174 sec. Processed 100.00 million rows