b

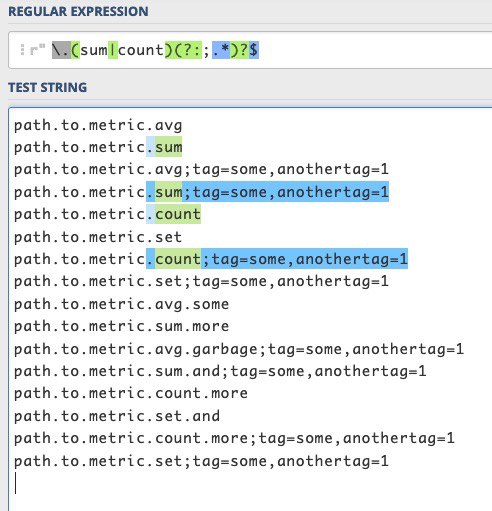

<regexp>click_cost</regexp> без всяких якорей, что обычно является суффиксом метрики, поэтому и задумался.Если прилетают графитовые метрики вроде

system.resources.servicename.worker.click_cost;host=2,env=dev, то сработает ли <regexp>\.click_cost$</regexp> или следует усложнить регулярку?