G

Size: a a a

2020 September 06

А, ну вы в локальную вставляете, тогда вам уменьшать кол-во кафка таблиц не выйдет.

Верно ли я делаю?

IT

А ну и можно zfs в конце концов проверить.

надо бы оформить тесты - zfs не дает performance, проигрывает hw raid10

2020 September 07

G

2020.09.06 21:49:33.763939 [ 302 ] {4ff92d4b-c781-4fb1-97a6-ca5f53828eb2} <Debug> DDLWorker: Processing tasks

2020.09.06 21:49:33.764017 [ 62 ] {} <Debug> DDLWorker: Cleaning queue

2020.09.06 21:49:33.770005 [ 302 ] {4ff92d4b-c781-4fb1-97a6-ca5f53828eb2} <Debug> DDLWorker: Processing task query-0000000333 (DROP TABLE data.sourc_event ON CLUSTER clustername)

2020.09.06 21:49:33.788441 [ 302 ] {4ff92d4b-c781-4fb1-97a6-ca5f53828eb2} <Debug> DDLWorker: Executing query: DROP TABLE data.source_event

2020.09.06 21:49:33.788803 [ 302 ] {52bb0e01-4490-4580-b630-2e09ba378f0b} <Debug> executeQuery: (from 0.0.0.0:0, user: ) /* ddl_entry=query-0000000333 */ DROP TABLE data.source_event

2020.09.06 21:49:33.858074 [ 376 ] {} <Fatal> BaseDaemon: ########################################

2020.09.06 21:49:33.858706 [ 376 ] {} <Fatal> BaseDaemon: (version 20.5.2.7 (official build), build id: F0C03E91ED7C0BB7) (from thread 145) (no query) Received signal Segmentation fault (11)

2020.09.06 21:49:33.858835 [ 376 ] {} <Fatal> BaseDaemon: Address: 0x8 Access: read. Address not mapped to object.

2020.09.06 21:49:33.858889 [ 376 ] {} <Fatal> BaseDaemon: Stack trace: 0xe3602ca 0xd999b1d 0xd9b6d5e 0xe351155 0xe351a69 0xdb40869 0xdb40cf2 0xdb40e22 0x95f6e97 0x95f5383 0x7f799983d609 0x7f7999753103

2020.09.06 21:49:33.861300 [ 376 ] {} <Fatal> BaseDaemon: 3. DB::KafkaBlockInputStream::readImpl() @ 0xe3602ca in /usr/bin/clickhouse

2020.09.06 21:49:33.861547 [ 376 ] {} <Fatal> BaseDaemon: 4. DB::IBlockInputStream::read() @ 0xd999b1d in /usr/bin/clickhouse

2020.09.06 21:49:33.861634 [ 376 ] {} <Fatal> BaseDaemon: 5. DB::copyData(DB::IBlockInputStream&, DB::IBlockOutputStream&, std::__1::atomic<bool>*) @ 0xd9b6d5e in /usr/bin/clickhouse

2020.09.06 21:49:33.861675 [ 376 ] {} <Fatal> BaseDaemon: 6. DB::StorageKafka::streamToViews() @ 0xe351155 in /usr/bin/clickhouse

2020.09.06 21:49:33.861729 [ 376 ] {} <Fatal> BaseDaemon: 7. DB::StorageKafka::threadFunc() @ 0xe351a69 in /usr/bin/clickhouse

2020.09.06 21:49:33.861934 [ 376 ] {} <Fatal> BaseDaemon: 8. DB::BackgroundSchedulePoolTaskInfo::execute() @ 0xdb40869 in /usr/bin/clickhouse

2020.09.06 21:49:33.861987 [ 376 ] {} <Fatal> BaseDaemon: 9. DB::BackgroundSchedulePool::threadFunction() @ 0xdb40cf2 in /usr/bin/clickhouse

2020.09.06 21:49:33.862018 [ 376 ] {} <Fatal> BaseDaemon: 10. ? @ 0xdb40e22 in /usr/bin/clickhouse

2020.09.06 21:49:33.862187 [ 376 ] {} <Fatal> BaseDaemon: 11. ThreadPoolImpl<std::__1::thread>::worker(std::__1::__list_iterator<std::__1::thread, void*>) @ 0x95f6e97 in /usr/bin/clickhouse

2020.09.06 21:49:33.862236 [ 376 ] {} <Fatal> BaseDaemon: 12. ? @ 0x95f5383 in /usr/bin/clickhouse

2020.09.06 21:49:33.862421 [ 376 ] {} <Fatal> BaseDaemon: 13. start_thread @ 0x9609 in /usr/lib/x86_64-linux-gnu/libpthread-2.31.so

2020.09.06 21:49:33.862524 [ 376 ] {} <Fatal> BaseDaemon: 14. __clone @ 0x122103 in /usr/lib/x86_64-linux-gnu/libc-2.31.soG

Валится все

После применения параметров

После применения параметров

SS

Всем привет!

У меня странная проблема, я пытаюсь заинсертить в большую таблицу данные, если сделать по 1 строчке - то все ок, проходит, если же сделать даже 10 строк за 1 инсерт - то будет ошибка -

У меня странная проблема, я пытаюсь заинсертить в большую таблицу данные, если сделать по 1 строчке - то все ок, проходит, если же сделать даже 10 строк за 1 инсерт - то будет ошибка -

Attempt to read after eof

SS

Если например заинсертить 10 строк, но при этом внутри данные некоторые заменить на null (чтобы облегчить инстерт), то тоже проходит

SS

видимо проблема именно в том, что много данных вставляется в широкую таблицу

SS

Кто-нибудь знает, какие конфиги надо увеличить? Я просто не шарю в этом 🙁

AK

если кол-во строк почти одинаковое то разницы не будет.

У вас кстати в MV не хватает полей в order by , у вас там кривые данные, UId и Name вычислены как any

У вас кстати в MV не хватает полей в order by , у вас там кривые данные, UId и Name вычислены как any

Спасибо, добавил.

НМ

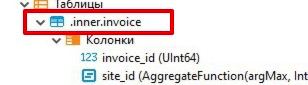

доброго утра, сейчас пытаемся забэкапить бд, и столкнулись со странными таблицами, судя по названию - это что-то либо временное, либо системное.

хотелось бы собственно выяснить, откуда берутся такие таблицы, и чревато ли их удалять, ибо они мешают бэкапу

хотелось бы собственно выяснить, откуда берутся такие таблицы, и чревато ли их удалять, ибо они мешают бэкапу

IP

Тут созрел вопрос, есть ли функциональное отличие между ключем партиции типа date и типа uint

D

Тут созрел вопрос, есть ли функциональное отличие между ключем партиции типа date и типа uint

Date = uint16

D

К которому можно применять функции работы с датой и прочее

D

Но под капотом как и везде цифра

D

Привет всем! Подскажите пожалуйста, после старта (или рестарта) CH пишется: clickhouse-server service is stopped, однако по факту он продолжает работать, и тем самым не удается применить измененный конфиг, может кто то сталкивался с подобной ошибкой?

IP

Date = uint16

это на многое отвечает спасибо

IP

К которому можно применять функции работы с датой и прочее

тоесть по факту для ttl партиций можно использовать и uint выражения? типа toYearWeek(clock) + 2

SS

Всем привет!

У меня странная проблема, я пытаюсь заинсертить в большую таблицу данные, если сделать по 1 строчке - то все ок, проходит, если же сделать даже 10 строк за 1 инсерт - то будет ошибка -

Если например заинсертить 10 строк, но при этом внутри данные некоторые заменить на null (чтобы облегчить инстерт), то тоже проходит

видимо проблема именно в том, что много данных вставляется в широкую таблицу

Кто-нибудь знает, какие конфиги надо увеличить? Я просто не шарю в этом 🙁

У меня странная проблема, я пытаюсь заинсертить в большую таблицу данные, если сделать по 1 строчке - то все ок, проходит, если же сделать даже 10 строк за 1 инсерт - то будет ошибка -

Attempt to read after eofЕсли например заинсертить 10 строк, но при этом внутри данные некоторые заменить на null (чтобы облегчить инстерт), то тоже проходит

видимо проблема именно в том, что много данных вставляется в широкую таблицу

Кто-нибудь знает, какие конфиги надо увеличить? Я просто не шарю в этом 🙁

D

тоесть по факту для ttl партиций можно использовать и uint выражения? типа toYearWeek(clock) + 2

вы путаете теплое с мягким. типы то разные. под капотом одинаковые, снаружи нет.

https://clickhouse.tech/docs/ru/engines/table-engines/mergetree-family/mergetree/#table_engine-mergetree-ttl

Для ТТЛ:

Выражения должны возвращать тип Date или DateTime.

Все что надо, кастите, и оно будет сравниваться с текущим временем на момент проверки.

ЗЫ. я так и не понял чего вы хотили добиться этим : "toYearWeek(clock) + 2" ? вам сколько надо хранить

https://clickhouse.tech/docs/ru/engines/table-engines/mergetree-family/mergetree/#table_engine-mergetree-ttl

Для ТТЛ:

Выражения должны возвращать тип Date или DateTime.

Все что надо, кастите, и оно будет сравниваться с текущим временем на момент проверки.

ЗЫ. я так и не понял чего вы хотили добиться этим : "toYearWeek(clock) + 2" ? вам сколько надо хранить