V

Size: a a a

2020 September 15

по идее есть лишние поля и нужен --input_format_skip_unknown_fields=1

Спасибо, проверю

D

всем доброго дня,

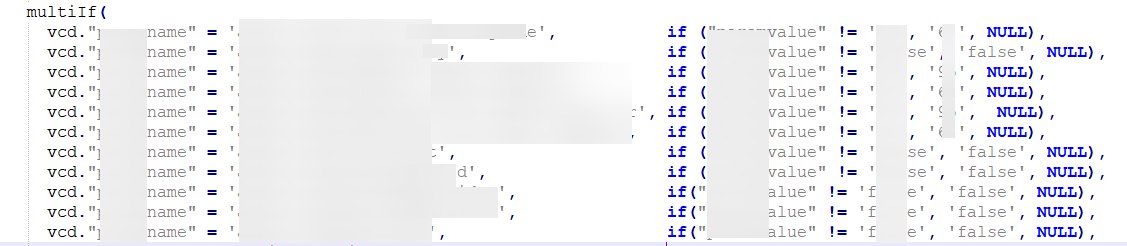

имеем вот такой неимоверный multi-if их 100500 условий.

https://i.imgur.com/7frdGRm.png

КХ тормозит и жрет CPU (видимо потому, что делает в параллели все проверки).

без этого же multiIf работает в 16-17 раз быстрее...

как такое можно оптимизировать?

имеем вот такой неимоверный multi-if их 100500 условий.

https://i.imgur.com/7frdGRm.png

КХ тормозит и жрет CPU (видимо потому, что делает в параллели все проверки).

без этого же multiIf работает в 16-17 раз быстрее...

как такое можно оптимизировать?

вдогонку.

с правой стороны соответственно может быть не только !=, но и другие операции сравнения, IN, Like :)

уот так уот

с правой стороны соответственно может быть не только !=, но и другие операции сравнения, IN, Like :)

уот так уот

DC

Раньше скриптом закидывалось напрямую в кликхаус, передалал, чтобы скрипт заливал данные в кафка, а кх уже из кафки. Еще есть 3 других топика, там и поток выше и данных больше и все нормально, а здесь такая ошибка.

вы издеваетесь? я спрашиваю через вот так как вы kafka+jsonEachrow пытаетесь сделать работало или нет? А вы рассказываете как ваш дедушка партизан фрицев под окос пускал.

V

вы издеваетесь? я спрашиваю через вот так как вы kafka+jsonEachrow пытаетесь сделать работало или нет? А вы рассказываете как ваш дедушка партизан фрицев под окос пускал.

Я говорю, что сейчас есть 3 kafka+jsonEachRow параллельно и там все ок. Но скорее всего дело действительно в лишних полях

SG

В таблице есть поле

ctime Nullable(DateTime) DEFAULT now()SG

ctime возвращает всегда текущий datetime

SG

Ожидалось немного другое поведение, при инсерте поле по дефолту должно заполняться текущим datetime'ом, подскажите как реализовать

DT

В таблице есть поле

ctime Nullable(DateTime) DEFAULT now()Default now() был добавлен уже ALTER TABLE ?

SG

Не могу сказать точно

DT

Просто выглядит именно так, в таком случае для данных вставленных до добавления DEFAULT оно считает это значение на ходу.

SG

Не знал про эту особенность, спасибо

АМ

Коллеги всем привет.

Хотим протестировать хранение данных на разных дисках(ssd + hdd). Однако встал вопрос, ответ на окторый не нашел в документации.

ситуация:

1) допустим у меня есть политика на максимальный размер куска и move_factor и перенос данных с ssd на hdd

2) у меня есть несколько таблиц с этой политикой.

гарантируется ли что при заполнении диска будут переноситься именно самые старые куски а не рандомные?

и можно ли гарантировать что данные будут переносить для всех таблиц, а не для какой-то случайной?

так же если кто-то активно использует данный функционал в проде расскажите сталкивались ли с какими подводными камнями?

Хотим протестировать хранение данных на разных дисках(ssd + hdd). Однако встал вопрос, ответ на окторый не нашел в документации.

ситуация:

1) допустим у меня есть политика на максимальный размер куска и move_factor и перенос данных с ssd на hdd

2) у меня есть несколько таблиц с этой политикой.

гарантируется ли что при заполнении диска будут переноситься именно самые старые куски а не рандомные?

и можно ли гарантировать что данные будут переносить для всех таблиц, а не для какой-то случайной?

так же если кто-то активно использует данный функционал в проде расскажите сталкивались ли с какими подводными камнями?

N

Всем привет, а как такое лечить:

DB::Exception: ALTER ADD INDEX is not supported for tables with the old syntax

N

ENGINE = MergeTree

DC

Всем привет, а как такое лечить:

DB::Exception: ALTER ADD INDEX is not supported for tables with the old syntax

пересоздавать таблицу в новом синтаксисе

N

пересоздавать таблицу в новом синтаксисе

это жестко 🙂

DC

это жестко 🙂

ну так надо было сделать это три года назад еще.

DC

Коллеги всем привет.

Хотим протестировать хранение данных на разных дисках(ssd + hdd). Однако встал вопрос, ответ на окторый не нашел в документации.

ситуация:

1) допустим у меня есть политика на максимальный размер куска и move_factor и перенос данных с ssd на hdd

2) у меня есть несколько таблиц с этой политикой.

гарантируется ли что при заполнении диска будут переноситься именно самые старые куски а не рандомные?

и можно ли гарантировать что данные будут переносить для всех таблиц, а не для какой-то случайной?

так же если кто-то активно использует данный функционал в проде расскажите сталкивались ли с какими подводными камнями?

Хотим протестировать хранение данных на разных дисках(ssd + hdd). Однако встал вопрос, ответ на окторый не нашел в документации.

ситуация:

1) допустим у меня есть политика на максимальный размер куска и move_factor и перенос данных с ssd на hdd

2) у меня есть несколько таблиц с этой политикой.

гарантируется ли что при заполнении диска будут переноситься именно самые старые куски а не рандомные?

и можно ли гарантировать что данные будут переносить для всех таблиц, а не для какой-то случайной?

так же если кто-то активно использует данный функционал в проде расскажите сталкивались ли с какими подводными камнями?

конечно рандомные. Политику сделайте не по размеру, а по времени

N

ну так надо было сделать это три года назад еще.

Спасибо большое за информацию, можно было бы, если бы не проект, который уже не поддерживается 🙂

АМ

конечно рандомные. Политику сделайте не по размеру, а по времени

спасибо а где прочитать про такую конфигурацию в офф доке только

policy_name_N — название политики. Названия политик должны быть уникальны.

volume_name_N — название тома. Названия томов должны быть уникальны.

disk — диск, находящийся внутри тома.

max_data_part_size_bytes — максимальный размер куска данных, который может находится на любом из дисков этого тома.

move_factor — доля свободного места, при превышении которого данные начинают перемещаться на следующий том, если он есть (по умолчанию 0.1).