K

Size: a a a

2021 January 18

это правдивее и проще

AG

Здравствуйте, коллеги. Нужна помощь с добавлением индекса.

clh01 :) alter table traffic add index packetDate_ packetDate type minmax granularity 8192

ALTER TABLE traffic

ADD INDEX packetDate_ packetDate TYPE minmax GRANULARITY 8192

Query id: 2e43efe9-d10a-4720-862a-6a529b9ddd53

Ok.

0 rows in set. Elapsed: 0.022 sec.

clh01 :) alter table traffic materialize index packetDate_

ALTER TABLE traffic

MATERIALIZE INDEX packetDate_

Query id: 33c7de4e-b068-4b41-99e2-88afb045d4ca

Ok.

0 rows in set. Elapsed: 0.013 sec.

clh01 :) optimize table traffic final

OPTIMIZE TABLE traffic FINAL

Query id: cf81bec4-650d-4150-801b-cc4f4d306cba

Timeout exceeded while receiving data from server. Waited for 300 seconds, timeout is 300 seconds.

Cancelling query.

Ok.

Query was cancelled.

0 rows in set. Elapsed: 3431.730 sec.

clh01 :) alter table traffic add index packetDate_ packetDate type minmax granularity 8192

ALTER TABLE traffic

ADD INDEX packetDate_ packetDate TYPE minmax GRANULARITY 8192

Query id: 2e43efe9-d10a-4720-862a-6a529b9ddd53

Ok.

0 rows in set. Elapsed: 0.022 sec.

clh01 :) alter table traffic materialize index packetDate_

ALTER TABLE traffic

MATERIALIZE INDEX packetDate_

Query id: 33c7de4e-b068-4b41-99e2-88afb045d4ca

Ok.

0 rows in set. Elapsed: 0.013 sec.

clh01 :) optimize table traffic final

OPTIMIZE TABLE traffic FINAL

Query id: cf81bec4-650d-4150-801b-cc4f4d306cba

Timeout exceeded while receiving data from server. Waited for 300 seconds, timeout is 300 seconds.

Cancelling query.

Ok.

Query was cancelled.

0 rows in set. Elapsed: 3431.730 sec.

I

Ну у клинтов есть обращения, у них не всегда пишется id, тк в обращение может быть через Ватсап, Телегу итд. В Табло есть дашборд в разных разрезах с кол-вом обращений. Пока ничего лучше что бы увидеть по дням кол-во обращений/активных продавцов не придумали)

K

Ну у клинтов есть обращения, у них не всегда пишется id, тк в обращение может быть через Ватсап, Телегу итд. В Табло есть дашборд в разных разрезах с кол-вом обращений. Пока ничего лучше что бы увидеть по дням кол-во обращений/активных продавцов не придумали)

не увидел ответа как двухнедельный онлайн для каждого ид решает этот вопрос. даже наоборот ощущение что значения будут сильно завышены

K

в общем я думаю надо задачу более полно сформулировать, причем еще на этапе бизнес аналитики.

а если то как понял - проще всего кодом пробежаться и для каждого дня запрос выполнить.

а если то как понял - проще всего кодом пробежаться и для каждого дня запрос выполнить.

I

не увидел ответа как двухнедельный онлайн для каждого ид решает этот вопрос. даже наоборот ощущение что значения будут сильно завышены

Ну типо если он 2 недели не заходил, то наврятли это он писал в поддержку. Короч просто метод узнать тех кто пользуется и щас когда их кол-во как и обращений будет расти, увидеть не полетит ли их отношение. Но это не моя идея, я полностью согласен что варик так себе)

M

Ну типо если он 2 недели не заходил, то наврятли это он писал в поддержку. Короч просто метод узнать тех кто пользуется и щас когда их кол-во как и обращений будет расти, увидеть не полетит ли их отношение. Но это не моя идея, я полностью согласен что варик так себе)

Ну выберете всех юзеров начиная now() - interval 2 weeks

ИМ

Может ли при проставленном insert_distributed_sync = 1 вообще существовать отставания реплик? Если во время вставки через clickhouse-client идёт сохранение на все реплики, то данные гарантировано записаны и отставания друг от друга нет. Я прав или я прав?

k

Привет. Подскажите, как корректно удалить storage policies? Если убрать упоминания из конфига, то они остаются в system.storage_policies

VM

Привет. Подскажите, как корректно удалить storage policies? Если убрать упоминания из конфига, то они остаются в system.storage_policies

full restart сделать и все пройдет

k

Понял, спасибо.

K

я думаю, что нужно создавать две таблицы с разными коннекшенами

так будет более верно на мой взгляд, тк если чето упадет на первой, то весь консюм не стопнется

так будет более верно на мой взгляд, тк если чето упадет на первой, то весь консюм не стопнется

Для меня это не очень опция, так как я перевожу сервис с питона на C# и хочу, чтобы два сервиса некоторое время писали в одну таблицу, чтобы не потерять данные

Можно ли как-то так сделать?

Можно ли как-то так сделать?

M

KirillReal

Для меня это не очень опция, так как я перевожу сервис с питона на C# и хочу, чтобы два сервиса некоторое время писали в одну таблицу, чтобы не потерять данные

Можно ли как-то так сделать?

Можно ли как-то так сделать?

Так они будут продолжать писать в одну таблицу

Вы создадите две Кафка таблицы, потом два MV, которые пишут в нужную таблицу

Вы создадите две Кафка таблицы, потом два MV, которые пишут в нужную таблицу

M

Я бы так делал

K

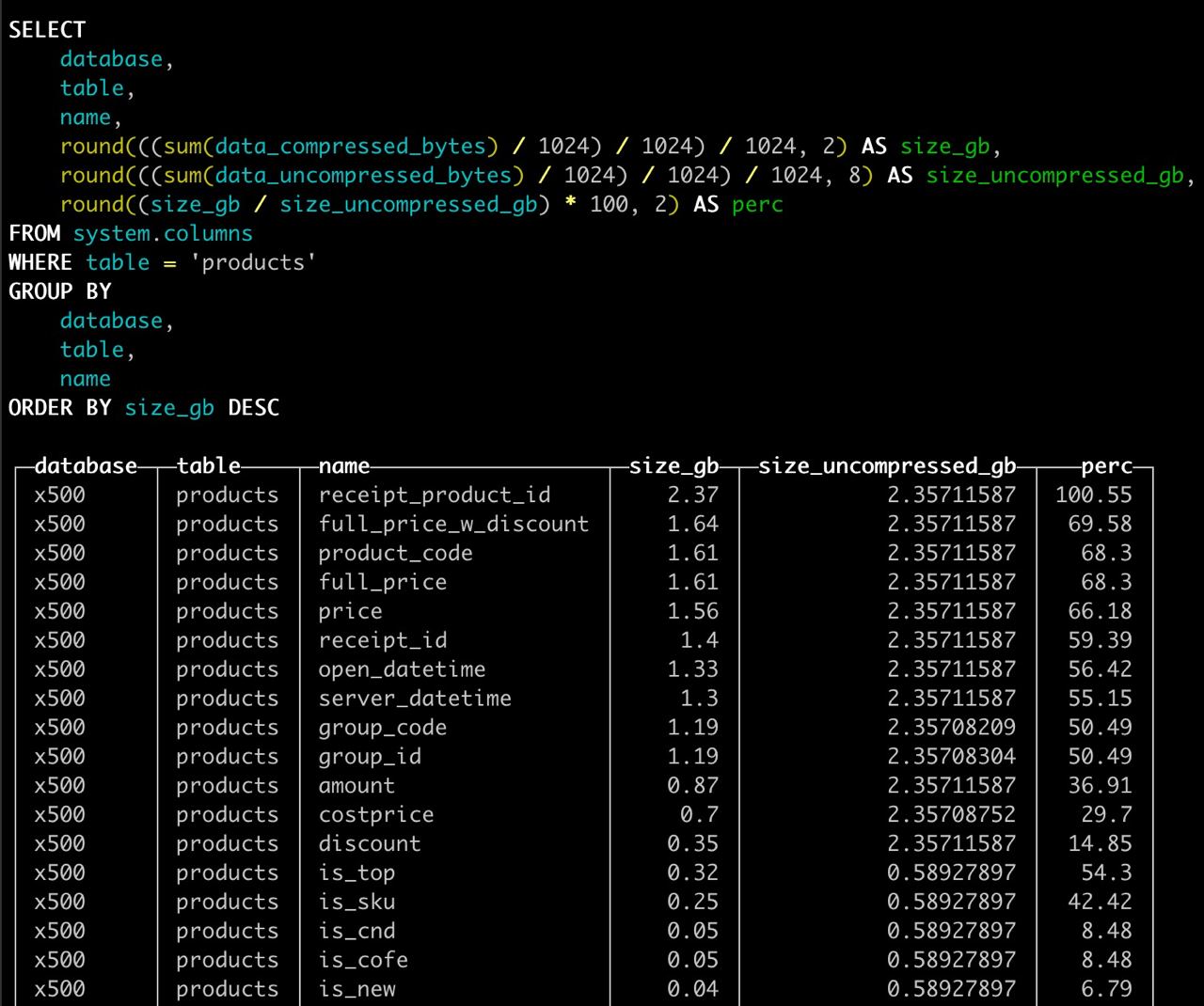

Вопрос по движкам компрессии

Delta и DoubleDelta - насколько эффективны для автоинкремент UInt32 колонок с негарантированной последовательностью вставки? Насколько замедляет выборку(расчет) по этим полям.?

Delta и DoubleDelta - насколько эффективны для автоинкремент UInt32 колонок с негарантированной последовательностью вставки? Насколько замедляет выборку(расчет) по этим полям.?

K

выходит так что это самые жирные поля тк значения в них уникальны

O

Привет

Запрос create table on cluster при поломанности каких-то машин выполнится или зафейлится?

Запрос create table on cluster при поломанности каких-то машин выполнится или зафейлится?

ИМ

На починенных выполнится, на сломанных нет)

A

Подскажите, что означает

TRACKING ONLY и NO LIMITS в выражении для квот? https://clickhouse.tech/docs/ru/sql-reference/statements/create/quota/VN

Есть самописная DMP для внутренних нужд компании и сейчас стоит задача по формированию аттрибутов профилй. Решили взять кх для сборки и обработки сырых данных ( опыта в этом большого нет). В сырые данные сохраняются title и url запросов и куча других полей. Пока работа идет с title и url полями, по ним формируются правила примера если title содержит "нужный текст" то такой запрос относится к аттрибуту под id 400 ( к примеру). Получается по факту пример запроса такой

select uid, positionCaseInsensitiveUTF8(ref, 'https://example.ru') != 0 OR positionCaseInsensitiveUTF8(title, 'Кулинария') != 0 OR positionCaseInsensitiveUTF8(title, 'Рецепт этого блюда') != 0 OR positionCaseInsensitiveUTF8(title, 'Кулинарный рецепт') != 0 as "440" from raw_data where "440" = 1;