✡

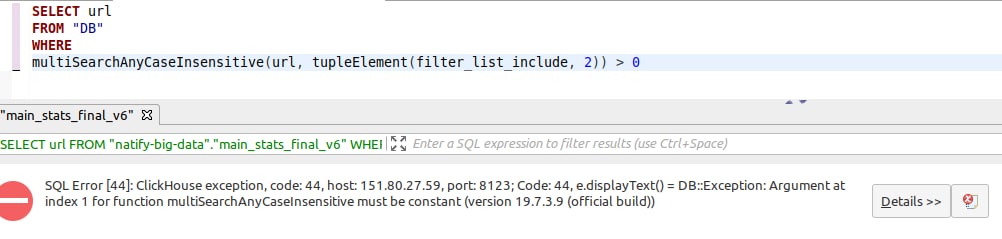

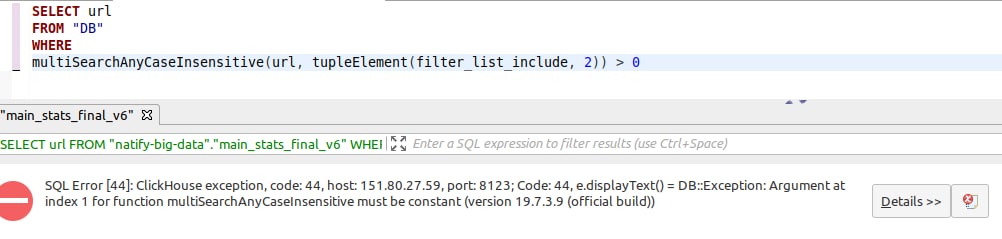

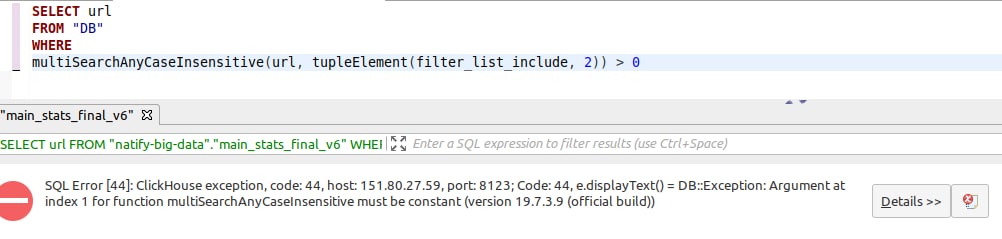

Как можно преобразовать url в константу (надеюсь я достаточно грамотно написал ) 😶

Size: a a a

✡

D

M

✡

D

✡

ИС

JOIN требует строгое сравнение.

SELECT

id AS InternalId,

name AS Name,

round(cost / 100,2) AS Price,

sum(amt) AS Quantity,

round(sum(tot / 100), 2) AS Sum

FROM

db.goods r,

(select '%text%' as Filter, 1 as CompaignId) as pt

WHERE

date >= today()

AND Name like pt.Filter -- Argument at index 1 for function like must be constant

GROUP BY InternalId, Name, Price

LIMIT 10

D

L

```CREATE TABLE IF NOT EXISTS lbas_daily```

(

date Date,

uuid UUID,

created_at DateTime,

type_name String,

bv Int64

) ENGINE = SummingMergeTree(bv)

PARTITION BY toYYYYMM(date)

ORDER BY (date, uuid);

INSERT INTO lbas_daily

SELECT toDate(sample_time) as date,

uuid,

created_at,

type_name,

1 as bv

FROM lbas

WHERE toDate(sample_time) == yesterday();

L

SELECT (SELECT count(*)

FROM lbas

WHERE toDate(sample_time) == yesterday()) as orig_table_cnt,

(SELECT count(*) FROM as_daily) as daily_table_cnt;

D

JOIN требует строгое сравнение.

SELECT

id AS InternalId,

name AS Name,

round(cost / 100,2) AS Price,

sum(amt) AS Quantity,

round(sum(tot / 100), 2) AS Sum

FROM

db.goods r,

(select '%text%' as Filter, 1 as CompaignId) as pt

WHERE

date >= today()

AND Name like pt.Filter -- Argument at index 1 for function like must be constant

GROUP BY InternalId, Name, Price

LIMIT 10

with (select groupArray(flt) from (/* your filter table */select arrayJoin(['ing1', 'ing3', 'ing4']) as flt)) as fltArr

select * from (/* your goods table */select arrayJoin(['String1','String2','String3']) as name) as goods

where multiSearchAny(name, fltArr);

ИС

with (select groupArray(flt) from (/* your filter table */select arrayJoin(['ing1', 'ing3', 'ing4']) as flt)) as fltArr

select * from (/* your goods table */select arrayJoin(['String1','String2','String3']) as name) as goods

where multiSearchAny(name, fltArr);

VB

2021.02.10 10:08:29.829926 [ 22125 ] {} <Warning> StorageKafka (my_kafka_table): Parsing of message (topic: my_topic, partition: 4, offset: 76719) return no rows.

VS

```CREATE TABLE IF NOT EXISTS lbas_daily```

(

date Date,

uuid UUID,

created_at DateTime,

type_name String,

bv Int64

) ENGINE = SummingMergeTree(bv)

PARTITION BY toYYYYMM(date)

ORDER BY (date, uuid);

INSERT INTO lbas_daily

SELECT toDate(sample_time) as date,

uuid,

created_at,

type_name,

1 as bv

FROM lbas

WHERE toDate(sample_time) == yesterday();

L

VS

L

M

2021.02.10 10:08:29.829926 [ 22125 ] {} <Warning> StorageKafka (my_kafka_table): Parsing of message (topic: my_topic, partition: 4, offset: 76719) return no rows.

VS

L