Google записал новый выпуск разрушителей SEO-легенд, в котором Мартин Сплит рассказал про краулинговый бюджет.

https://youtu.be/am4g0hXAA8QОсновные мысли:

— Google хочет просканировать как можно больше контента.

— В то же время нужно не перегрузить сервер.

— Также нет смысла сканировать то, что не меняется.

— Новостные сайты сканируются чаще, чем сайты про историю.

Как Google узнает, что сайт меняется?

— Сохраняется фингерпринт контента и позже сравнивается до и после сканирования.

— Учитывается дата изменения контента. Через микроразметку или элементы даты на странице.

— ETag или Last-Modified, как и другие элементы, где можно задать дату, будут учитываться как подсказки, но не как четкие инструкции.

— Google отслеживает частоту изменений.

— Если автоматически менять Last-Modified в HTTP заголовках и дату в sitemap.xml, при этом без изменений в контенте, то в этом нет смысла, это не поможет, Google не хочет бесполезно тратить ресурсы.

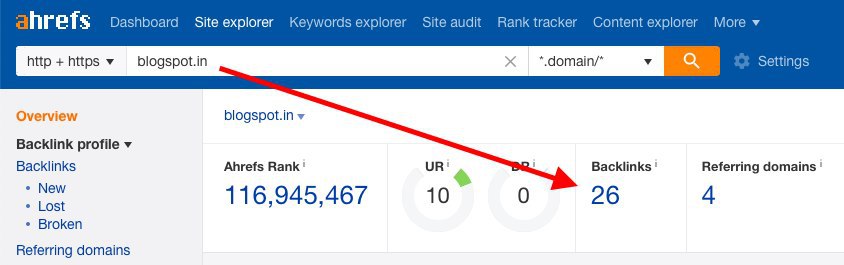

— О краулинговом бюджете должны беспокоиться только большие сайты. С миллионом страниц.

И еще:

— Настройки/скорость сервера это не проблема краулингового бюджета, это проблема вашего сервера. Но Google не понимает, это он вас перегрузил запросами или у вас так всегда со скоростью, поэтому скорость сканирования будет снижаться.

— Качество контента это не проблема краулингового бюджета, хотя Google конечно не будет его индексировать, это проблема качества контента.

— Sitemap помогает узнавать о новых урлах и сканировать их быстрее.

— Но быстрое сканирование не всегда решает настоящие проблемы сайта.

Если говорить про eCommerce, где много маленьких похожих страниц, как Google с этим работает? Мартин предлагает подумать, должны ли похожие страницы вообще существовать? Может имеет смысл небольшие вариации товара (цвет, размер и пр) описать в одной таблице?

При изменениях на сайте Мартин рекомендует делать их постепенно, по одному за раз. А не сразу смена текста, сервера, адресов страниц, домена...

Краулинг и рендеринг происходят не одновременно, так как для рендеринга страницы нужно прокраулить много документов/скриптов/стилей, и снова, при этом не перегрузить сервер. Google кеширует API запросы, если они используют GET, но не кешируют POST-запросы.