SP

Size: a a a

2020 September 23

Если в итоге в job передаётся один большой массив, то лучше в момент сбора данных передавать частями, по крайней мере у меня job так лучше отрабатывает. А при обработке одного большого массива 40к элементов, job отваливается по таймауту, а при его увеличении просто зависает, не обрабатывается полностью.

Я думаю это мина замедленного действия , а если данные растут и скоро будет не 40к а 100k или больше, надо код писать сразу готовым к этому, если знаешь что данные растут

A

Есть модель Post и у нее есть свойство params (array, в миграции как json). Хочу работать с этими параметрами не как с массивом, а как с объектами. Куда лучше копать? кто ниубдь уже делал такое? Чистый класс сделать или наследовать? хотелось чтоб параметры тоже знали про родителя и может умели просить родителя сохраниться в БД

A

да, так и делаю. но по примеру что есть \app\models\AddressModel? ведь он уже не Eloquent, тогда что?)

DK

App/Casts

В

Всем привет! Не могу понять как сделать запрос к модели с несколькими значениями. Есть пользователь с ролью Владелец компании, он может создать n кол-во компаний. Также есть модель Заказ, в котором есть company_id. Как мне вывести все заказы конкретного владельца компаний? Сейчас мой запрос выглядит так Order::where('company_id', Auth::user()->company_id)->get(). Но он возвращает только заказы одной компании.

YS

Всем привет! Не могу понять как сделать запрос к модели с несколькими значениями. Есть пользователь с ролью Владелец компании, он может создать n кол-во компаний. Также есть модель Заказ, в котором есть company_id. Как мне вывести все заказы конкретного владельца компаний? Сейчас мой запрос выглядит так Order::where('company_id', Auth::user()->company_id)->get(). Но он возвращает только заказы одной компании.

Выбрать все компании пользователя и при помощи whereIn выбрать все заказы с выбранным ранее компаниями. Либо whereHas, либо join

РW

как бы правильно прописать файл миграции, если мне нужно применить ключ unique для группы колонок?

Для одной колонки, просто $table->string('mail')->unique();

а если мне нужно для группы? к примеру если

mail и phone ?

Для одной колонки, просто $table->string('mail')->unique();

а если мне нужно для группы? к примеру если

mail и phone ?

В

Выбрать все компании пользователя и при помощи whereIn выбрать все заказы с выбранным ранее компаниями. Либо whereHas, либо join

Да, то что нужно! Спасибо большое🤝💪

A

как бы правильно прописать файл миграции, если мне нужно применить ключ unique для группы колонок?

Для одной колонки, просто $table->string('mail')->unique();

а если мне нужно для группы? к примеру если

mail и phone ?

Для одной колонки, просто $table->string('mail')->unique();

а если мне нужно для группы? к примеру если

mail и phone ?

А если ради разнообразия, просто открыть доку на разделе миграции?

РW

А если ради разнообразия, просто открыть доку на разделе миграции?

а если без если? а просто или ответить или нет. Если бы я там нашел (или разобрался) то бы не писал.

РW

А если ради разнообразия, просто открыть доку на разделе миграции?

и не раздел Миграции а раздел Схемы конструктора, если умничать то с умом.

A

а если без если? а просто или ответить или нет. Если бы я там нашел (или разобрался) то бы не писал.

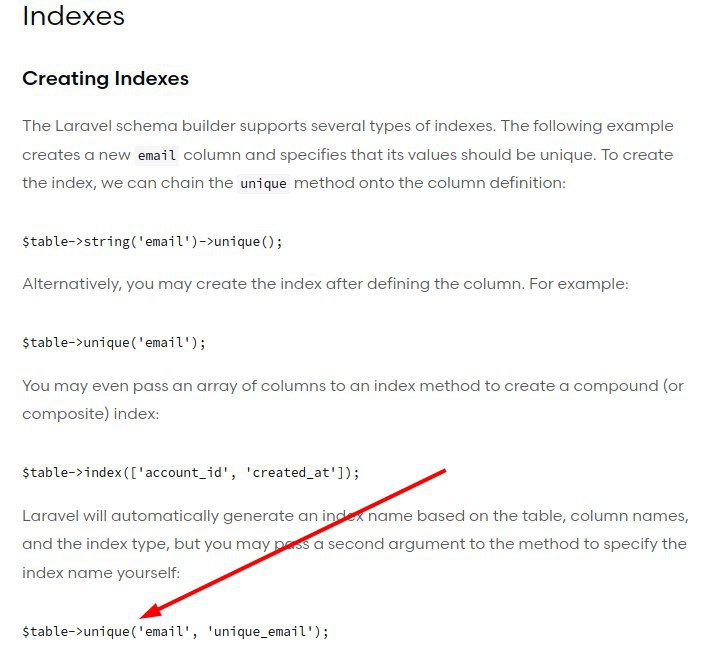

https://laravel.com/docs/8.x/migrations#creating-indexes

Если ты не разобрался в примерах... То боюсь если тебе открытым текстом написать ты все равно не догодаешся что делать 😂

Если ты не разобрался в примерах... То боюсь если тебе открытым текстом написать ты все равно не догодаешся что делать 😂

A

и не раздел Миграции а раздел Схемы конструктора, если умничать то с умом.

Ты доку от какого то детского конструктора там листаешь чтоли? )) Я про доку ларки говорил ))

РW

https://laravel.com/docs/8.x/migrations#creating-indexes

Если ты не разобрался в примерах... То боюсь если тебе открытым текстом написать ты все равно не догодаешся что делать 😂

Если ты не разобрался в примерах... То боюсь если тебе открытым текстом написать ты все равно не догодаешся что делать 😂

ну что же сейчас поразводилось псевдо людей которые только что то пишут...

И где там есть пример группы? Есть как имя индексу задать и что?

И где там есть пример группы? Есть как имя индексу задать и что?

YS

ну что же сейчас поразводилось псевдо людей которые только что то пишут...

И где там есть пример группы? Есть как имя индексу задать и что?

И где там есть пример группы? Есть как имя индексу задать и что?

РW

ПЕРЕВОД : Laravel автоматически сгенерирует имя индекса на основе таблицы, имен столбцов и типа индекса, но вы можете передать второй аргумент методу, чтобы указать имя индекса самостоятельно

A

ну что же сейчас поразводилось псевдо людей которые только что то пишут...

И где там есть пример группы? Есть как имя индексу задать и что?

И где там есть пример группы? Есть как имя индексу задать и что?

оооо как все плохо то 🙈 мозг не включается даже после того как носом тыкнули в ответ... ппц

YS

ПЕРЕВОД : Laravel автоматически сгенерирует имя индекса на основе таблицы, имен столбцов и типа индекса, но вы можете передать второй аргумент методу, чтобы указать имя индекса самостоятельно

а ну да, чуть выше посмотри

РW

оооо как все плохо то 🙈 мозг не включается даже после того как носом тыкнули в ответ... ппц

тупите?