OI

Size: a a a

2019 August 07

Я не понимаю как спарк даже с намбой может к GPU подключаться ) Или ты про пользовательские функции? Работа по кодогенерации куды в Спарке уже ведется одной из наших команд, вот здесь есть детали https://medium.com/rapids-ai/nvidia-gpus-and-apache-spark-one-step-closer-2d99e37ac8fd

Да, про пользовательские ф-ции. В них можно вызвать numba, кот. дергает cuda.

DU

Просто вызвать функции нельзя, нужна ещё вся остальная обвязка, которая будет данные на видюху заливать, собственно чем rapids и занимается

PK

Просто вызвать функции нельзя, нужна ещё вся остальная обвязка, которая будет данные на видюху заливать, собственно чем rapids и занимается

Ну, в намбе есть возможность класть данные на gpu. Толку от этого, правда, пшик. Потому что даже при довольно большом батче накладные расходы на трансфер из системной памяти мажорируют вычисления на gpu

DU

Если это через отображение системной памяти, да, скорее всего быстро вряд ли будет работать, но интересное замечание, да

KS

есть смысл на pyspark (2.4.1) пытаться считать approximateNearestNeighbours для контентных рекомендаций? Или лучше не начинать ?

KS

BucketedRandomProjectionLSH пробую, чет не очень взлетает

KS

или сразу идти в nmslib/faiss

DG

Ну, в намбе есть возможность класть данные на gpu. Толку от этого, правда, пшик. Потому что даже при довольно большом батче накладные расходы на трансфер из системной памяти мажорируют вычисления на gpu

А как должно быть "правильно"?

DU

А как должно быть "правильно"?

Колоночный формат+загрузка данных сразу, ещё можно компрессию добавить

DU

Не знаю, что из этого делает намба, но это явно за рамками кодогенерации удф находится

PK

А как должно быть "правильно"?

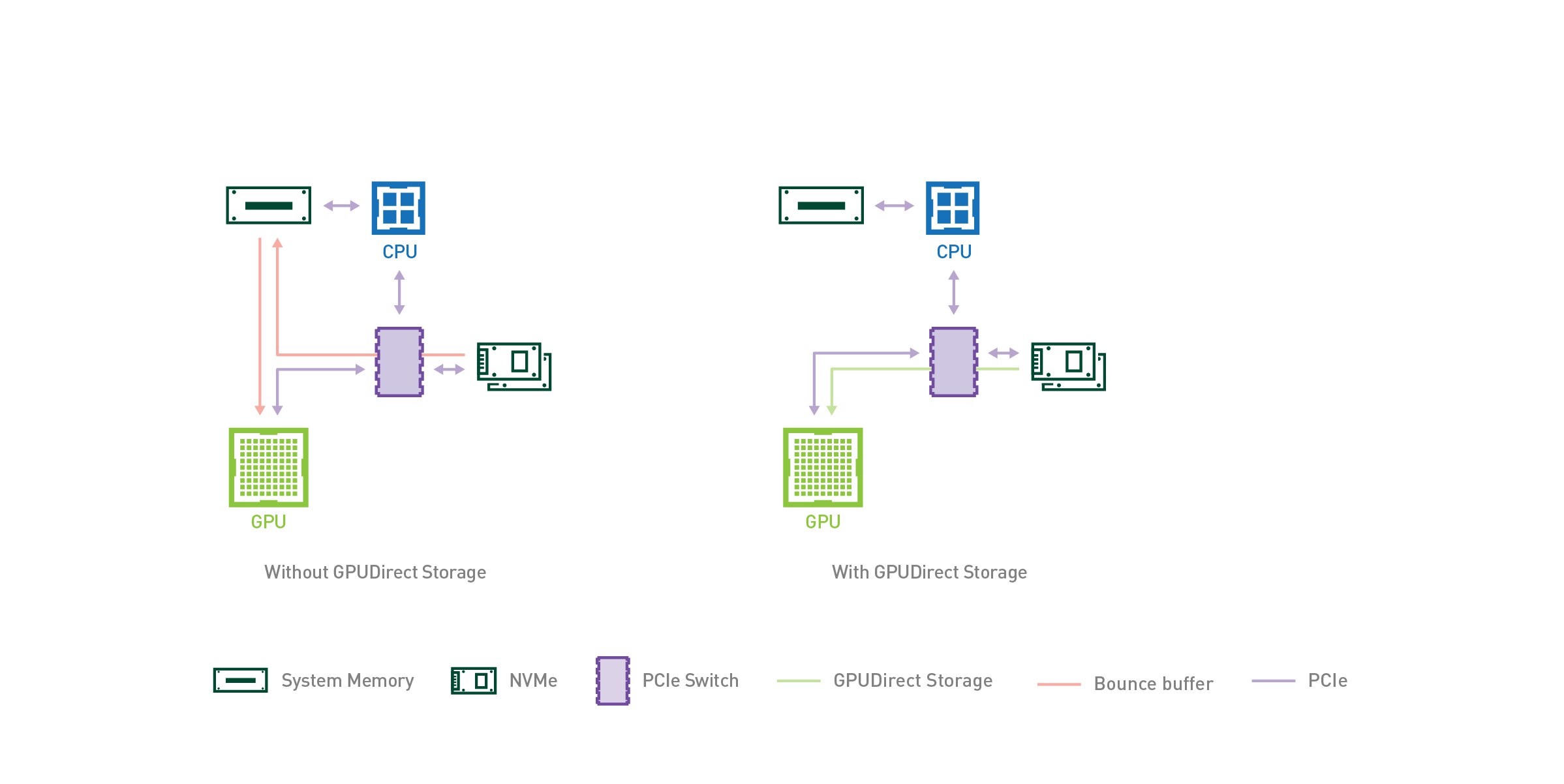

В идеале правильно - это когда данные партиций спарка уже лежат в GPU. На худой конец в системной памяти они должны лежать в формате Arrow, чтобы все было не так печально. Вообще быстрая загрузка данных в GPU - это один из двух основных консернов использования GPU для процессинга, но тут есть подвижки, например https://devblogs.nvidia.com/gpudirect-storage/

PK

Приобретение нвидией меланокса - это тоже шаг в ту сторону http://www.mellanox.com/page/products_dyn?product_family=295&mtag=gpudirect

PK

Колоночный формат+загрузка данных сразу, ещё можно компрессию добавить

Не увидел твой пост, сорри

DU

Нвидия хорошо взялась за дело ) Крутые новости

PK

Нвидия хорошо взялась за дело ) Крутые новости

Дык, RAPIDS-то во все дырки суют, а у конечных пользователей есть щекотливые вопросики )) Одними маркетинговыми презами тут не обойтись )

DU

Ага, ну быстро двигаются в правильную сторону и в плане спарка и меланокс

2019 August 08

YG

Из баз данных на gpu вот такую находил https://ru.m.wikipedia.org/wiki/Blazegraph а потом их Амазон купил и сделал Нептуна.

YG

Больше всех обещают скорости

2019 August 09

PK

Да их 100500 уже. Blazing, OmniSci (бывший MapD), вот это вот, еще пучок. Но толку от них в реальной жизни (где больше одного запроса и пользователя одновременно мало). Хотя, это все же особенность архитектуры CUDA. Ожидание от GPU как от general-purpose архитектуры строятся на укоренившихся представлениях о работе CPU. А это не так

ZM

Да их 100500 уже. Blazing, OmniSci (бывший MapD), вот это вот, еще пучок. Но толку от них в реальной жизни (где больше одного запроса и пользователя одновременно мало). Хотя, это все же особенность архитектуры CUDA. Ожидание от GPU как от general-purpose архитектуры строятся на укоренившихся представлениях о работе CPU. А это не так

из тех, что попадались в обзорах, все были комбинированными