t

Size: a a a

2020 January 10

Anton Alekseev

Не помогает, к сожалению. Судя по треду жиры, это проблема не батчей а буфера, который на 2гб.

тогда полагаю увеличение количества воркеров должно помочь

AA

Я немного не уловил суть проблемы между максимальным размером партиции и буфера arrow, который может заполнятся, как я понял батчами от партиции любого размера, но упрется только в свои 2 гб.

AA

тогда полагаю увеличение количества воркеров должно помочь

тоесть идея в уменьшении партиции? А почему репартишн не сделать тогда?))

t

Anton Alekseev

тоесть идея в уменьшении партиции? А почему репартишн не сделать тогда?))

ну условно если буфер один на воркер, то просто увеличение кол-ва партиций не поможет

AA

ну условно если буфер один на воркер, то просто увеличение кол-ва партиций не поможет

ааа, понятно.

t

вообще, у меня опыт с pandas/arrow двоякий - на стабильных версиях проблем почти нет, но есть некоторые сборки и вот на них какие то совершенно мутные ошибки были, вроде твоей

t

поэтому я бы на твоем месте локально проверил код на разных версиях спарка и эрроу, а потом бы уже емр траблшутил

AA

поэтому я бы на твоем месте локально проверил код на разных версиях спарка и эрроу, а потом бы уже емр траблшутил

Да, я локально дебажу, чтобы емр не разгонять каждый раз. Попробую обновиться, вот только у нас на новом arrow другие ошибки всплывали, поэтому откатились до 0.14.1. Видимо пора фиксить)

AA

вообще, у меня опыт с pandas/arrow двоякий - на стабильных версиях проблем почти нет, но есть некоторые сборки и вот на них какие то совершенно мутные ошибки были, вроде твоей

Проверили на всякий с большим числом воркеров и экзекьюторов, падает. Решение внезапно простое, перед pudf откинуть лишние колонки, там их было в 2 раза больше чем нужно, и данные стали пролезать. Тут конечно, сами себе буратины.😔

2020 January 13

ДА

Выгружаю питончиком данные из Postgres и делаю из них DataFrame.

Получаю ворненг

Где бы подкрутить, чтобы от него избавиться

Получаю ворненг

20/01/13 16:41:39 WARN TaskSetManager: Stage 597 contains a task of very large size (101634 KB). The maximum recommended task size is 100 KB.Где бы подкрутить, чтобы от него избавиться

YG

Выгружаю питончиком данные из Postgres и делаю из них DataFrame.

Получаю ворненг

Где бы подкрутить, чтобы от него избавиться

Получаю ворненг

20/01/13 16:41:39 WARN TaskSetManager: Stage 597 contains a task of very large size (101634 KB). The maximum recommended task size is 100 KB.Где бы подкрутить, чтобы от него избавиться

Может просто закрыть сессию и открыть новую? У вас странно большое кол-во “stage 597” ...

ДА

Там длинный файпланй с кучей трансформаций. Он нормально работает, не падает - просто ворненги не нравятся

С

Выгружаю питончиком данные из Postgres и делаю из них DataFrame.

Получаю ворненг

Где бы подкрутить, чтобы от него избавиться

Получаю ворненг

20/01/13 16:41:39 WARN TaskSetManager: Stage 597 contains a task of very large size (101634 KB). The maximum recommended task size is 100 KB.Где бы подкрутить, чтобы от него избавиться

--executor-memory увеличь

ЕГ

Выгружаю питончиком данные из Postgres и делаю из них DataFrame.

Получаю ворненг

Где бы подкрутить, чтобы от него избавиться

Получаю ворненг

20/01/13 16:41:39 WARN TaskSetManager: Stage 597 contains a task of very large size (101634 KB). The maximum recommended task size is 100 KB.Где бы подкрутить, чтобы от него избавиться

Можно сразу спарком грузить, если есть доступ в данный постгрес с датанод

NM

Выгружаю питончиком данные из Postgres и делаю из них DataFrame.

Получаю ворненг

Где бы подкрутить, чтобы от него избавиться

Получаю ворненг

20/01/13 16:41:39 WARN TaskSetManager: Stage 597 contains a task of very large size (101634 KB). The maximum recommended task size is 100 KB.Где бы подкрутить, чтобы от него избавиться

Как вариант, задать logging level в log4j.properties до critical в драйвере через Spark.driver.extraJavaOpts

2020 January 14

SK

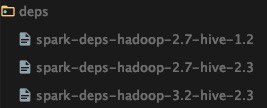

Всем привет, кто нибудь собирал spark 2.4 с hadoop 3.2 и с hive? пытаюсь

./dev/make-distribution.sh --name with-hadoop-3.2.0 --pip --r --tgz -Psparkr,hadoop-3.2,hive,hive-thriftserver,yarn -Dhadoop.version=3.2.0и онон мне выкидывает ошибки при сборе

GP

Всем привет, кто нибудь собирал spark 2.4 с hadoop 3.2 и с hive? пытаюсь

./dev/make-distribution.sh --name with-hadoop-3.2.0 --pip --r --tgz -Psparkr,hadoop-3.2,hive,hive-thriftserver,yarn -Dhadoop.version=3.2.0и онон мне выкидывает ошибки при сборе

нет такого профиля https://github.com/apache/spark/blob/v2.4.4/pom.xml#L2710 попробуй hadoop-3.1

SK

нет такого профиля https://github.com/apache/spark/blob/v2.4.4/pom.xml#L2710 попробуй hadoop-3.1

эмн я опираюсь, на git

SK

или я что то не так понял

GP

может у тебя спарк 3? я ссылку на гит дал тебе и спарк 2.4