K

Size: a a a

2020 February 04

Ну что , кто нибудь сделал уже пункт управления для стриминг жоб с фронтом красивым ?

K

From Today, we have

https://github.com/apache/spark/tree/branch-3.0

All open JIRA issues whose type is

- Most of them are re-targeted to

- Some of them are resolved according to the JIRA content.

- Some unauthorized target versions are removed according to the community policy.

To sum up, we have no open

branch-3.0 as a tool of Feature Freeze.https://github.com/apache/spark/tree/branch-3.0

All open JIRA issues whose type is

Improvement or New Feature and had 3.0.0 as a Target Version are changed accordingly first.- Most of them are re-targeted to

3.1.0.- Some of them are resolved according to the JIRA content.

- Some unauthorized target versions are removed according to the community policy.

To sum up, we have no open

Improvement/New Feature JIRA issues targeting 3.0.0 officially. For exceptional cases, we will discuss on them case by case during 3.0.0 QA phase.PK

На Спарк саммите зарелизят видимо

A🦕

как думаете спарк "достаточно умный" чтобы в таком коде

считать длину сначала на каждой партиции и потом сложить их?

https://spark.apache.org/docs/latest/api/python/_modules/pyspark/rdd.html#RDD.groupByKey

или нужно самому вручную пилить aggregateByKey

?

.groupByKey()

.mapValues(len)

считать длину сначала на каждой партиции и потом сложить их?

https://spark.apache.org/docs/latest/api/python/_modules/pyspark/rdd.html#RDD.groupByKey

или нужно самому вручную пилить aggregateByKey

?

PK

как думаете спарк "достаточно умный" чтобы в таком коде

считать длину сначала на каждой партиции и потом сложить их?

https://spark.apache.org/docs/latest/api/python/_modules/pyspark/rdd.html#RDD.groupByKey

или нужно самому вручную пилить aggregateByKey

?

.groupByKey()

.mapValues(len)

считать длину сначала на каждой партиции и потом сложить их?

https://spark.apache.org/docs/latest/api/python/_modules/pyspark/rdd.html#RDD.groupByKey

или нужно самому вручную пилить aggregateByKey

?

В Spark Core (RDD) никаких оптимизаторов нет. Хочешь оптимизацию - пиши на датафреймах/датасетах. Иначе - сам

A🦕

ну просто вот по ссылке вроде показалось что есть, я просто код не вывез (буду вывозить сейчас)

SS

Фигню написал)

A🦕

Фигню написал)

) а я уже начал имплементить

AA

) а я уже начал имплементить

и даже что-то получилось?)))

A🦕

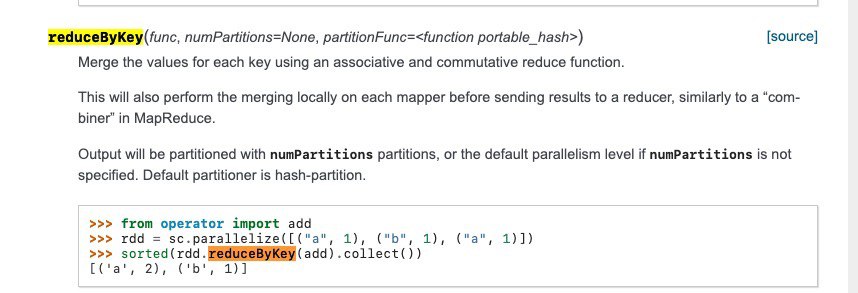

вот в

reduce, reduceByKey, aggregate, aggregateByKey точно такая оптимизация естьA🦕

типа делаем reduce сначала на нодах а потом редьюс результатов на драйвере

A🦕

но все эти функции присылают результат на драйвер а мне это не нужно, у меня он не влезет, мне нужно оставить в RDD

DK

но все эти функции присылают результат на драйвер а мне это не нужно, у меня он не влезет, мне нужно оставить в RDD

А как тогда вы результат хотите извлечь?

DK

Можно сделать любой редьюс, он пошафлит результат, но коллект на драйвер делать не будет

DK

Это не подходит?

A🦕

Daniel Kogan

Можно сделать любой редьюс, он пошафлит результат, но коллект на драйвер делать не будет

как?

A🦕

Daniel Kogan

А как тогда вы результат хотите извлечь?

ды я его просто сохраню в пикл saveAsPickle / потом прочту / либо сконверчу .toDF() .write.saveAsTable

DK

rdd.reduceByKey(...) а дальше просто писать в любую базу/диск

DK

Он не будет держать всю rdd физически на драйвере

DK

Будет записывать по партишенам, но пикл конечно не прокатит, его нельзя писать/читать по частям вроде бы