IK

Size: a a a

2020 April 12

нашел воркэраунд в виде spark.python.worker.reuse = false, но такое себе.

PK

нашел воркэраунд в виде spark.python.worker.reuse = false, но такое себе.

Ну просто у spacy конская инициализация, сколько он там памяти отжирает на подсос своих моделек? А учитывая, что питоша форкается на каждый таск, а тасков, очевидно, дофига, то да, не лучшее решение. Попробуй инициализировать spacy на драйвере и заброадкастить.

PK

может зум митап?

Я самоизолриуюсь в деревке. Тут с инетом траблы бывают, поэтому лучше не надо ))

IK

оно не броадкастится, проблемы с серелизатором.

У меня вообще специфичный конфиг - я стартую батч на одном инстансе в AWS с local[*] . 100мб данных отжирают 60гб инстанса =)) Вот пока приходится лавировать количеством партиций и включенным форком на таски.

У меня вообще специфичный конфиг - я стартую батч на одном инстансе в AWS с local[*] . 100мб данных отжирают 60гб инстанса =)) Вот пока приходится лавировать количеством партиций и включенным форком на таски.

PK

оно не броадкастится, проблемы с серелизатором.

У меня вообще специфичный конфиг - я стартую батч на одном инстансе в AWS с local[*] . 100мб данных отжирают 60гб инстанса =)) Вот пока приходится лавировать количеством партиций и включенным форком на таски.

У меня вообще специфичный конфиг - я стартую батч на одном инстансе в AWS с local[*] . 100мб данных отжирают 60гб инстанса =)) Вот пока приходится лавировать количеством партиций и включенным форком на таски.

Ох уж этот мэшин лернинг ))

IK

и не говори)

GP

оно не броадкастится, проблемы с серелизатором.

У меня вообще специфичный конфиг - я стартую батч на одном инстансе в AWS с local[*] . 100мб данных отжирают 60гб инстанса =)) Вот пока приходится лавировать количеством партиций и включенным форком на таски.

У меня вообще специфичный конфиг - я стартую батч на одном инстансе в AWS с local[*] . 100мб данных отжирают 60гб инстанса =)) Вот пока приходится лавировать количеством партиций и включенным форком на таски.

а зачем тогда надо на одном инстансе стартовать это) если один инстанс ток, может над без спарка

IK

Ну у меня требование потом мигрировать решение на кластер)

GP

понятно)

IK

а подкиньте около Data Science чатик кто-нибудь, где можно адресовать вопрос))

SO

а подкиньте около Data Science чатик кто-нибудь, где можно адресовать вопрос))

ODS?

PK

а подкиньте около Data Science чатик кто-нибудь, где можно адресовать вопрос))

Так тут много датасатанистов, ты спрашивай, не стейсняйся )

IK

Это одна из питонячих библиотек =) Сделал с ней pandas UDF валится с oom python worker. Явно в ней течет память на долгоживущих тасках.

Вопрос все тот же)

PK

Так ответили же вроде. Ежели не сериализуется, то делать нечего. Либо свою обертку писать, либо тикет разрабам ставить. Ну а OOM можно либо твоим способом решить, либо репартиционирование и spark.sql.shuffle.partitions уменьшать. Питону же похер, ему ограничения ресурс менеджера побоку

PK

Просто я не очень догоняю, чем тебе дата сайнс тут поможет. Только если поплясать с инициализацией spacy и не скармливать ему en-web-core или какой там у тебя словарь, а что поменьше.

IK

угум, это ясно. Я может надеялся на то как memory leak самого spacy побороть =)

en-web-core он самый :D

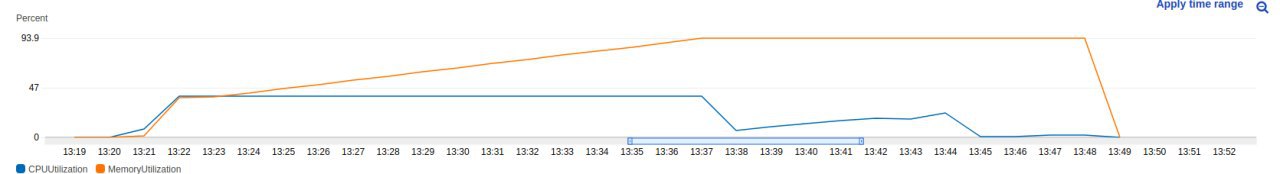

Да проблема даже не в инициализации, а в том, что чем больше через модель текста прогоняешь тем больше она жрет памяти. То ли сохраняет что то толи ещё что. Если бы падало при инициализации, уже было бы легче, ясно куда копать.

а он работает какое то время, а когда python worker нажинает непомерно жрать - падает

en-web-core он самый :D

Да проблема даже не в инициализации, а в том, что чем больше через модель текста прогоняешь тем больше она жрет памяти. То ли сохраняет что то толи ещё что. Если бы падало при инициализации, уже было бы легче, ясно куда копать.

а он работает какое то время, а когда python worker нажинает непомерно жрать - падает

IK

PK

Вот тут посоны тоже негодуют https://github.com/explosion/spaCy/issues/3618

IK

ага, и типа issue closed, как то пофиксили, но нет, нифига. Пойду наверное строчить в гитхаб им. Но судя по всему они не сильно любят на спарко-темы реагировать

IK