M

Size: a a a

2020 May 12

учитвая что это временные файлы, то сильной проблемы я не вижу, также учитвая что у S3 грустно с move операцией которую спарк активно использует, то может быть даже быстрее

M

мне казалось что distcp тоже создает временные файлы

точно создает, учитывая что это набор MR задач

JF

@meosit, спасибо

M

да не за что

2020 May 13

G

Народ, подскажите

Я поднял на сервере в докере ванильный HADOOP в singlnode и туда на HDFS положил файлег

С сервера читаю его в в spark-shell без проблем

Пытаюсь с локальной машинки прочитать а мне выдается :

java.io.IOException: Could not read footer for file и полный путь к файлику

Порт и сервер, к которому коннекчусь - прокинуты и читаются но похоже какой то касяк с доступом или может я чтото не так прописал при попытке достучаться до файла

Может у кого то есьт опыт таких плясок с бубном

Ванильный HADOOP в докере на удаленном сервере

Я поднял на сервере в докере ванильный HADOOP в singlnode и туда на HDFS положил файлег

С сервера читаю его в в spark-shell без проблем

Пытаюсь с локальной машинки прочитать а мне выдается :

java.io.IOException: Could not read footer for file и полный путь к файлику

Порт и сервер, к которому коннекчусь - прокинуты и читаются но похоже какой то касяк с доступом или может я чтото не так прописал при попытке достучаться до файла

Может у кого то есьт опыт таких плясок с бубном

Ванильный HADOOP в докере на удаленном сервере

PL

Всем привет! Был бы очень благодарен, если кто-то поделится успешным опытом использования Snowflake вместе со Spark-ом.

Есть некоторые Snowflake специфичные вопросы с которыми столкнулся и документация никак не помогает в них, а именно query queued time / execution time - который неожиданно очень сильно растет если использовать SF из Спарка

Заранее спасибо!

Есть некоторые Snowflake специфичные вопросы с которыми столкнулся и документация никак не помогает в них, а именно query queued time / execution time - который неожиданно очень сильно растет если использовать SF из Спарка

Заранее спасибо!

GP

очень плохо

K

очень плохо

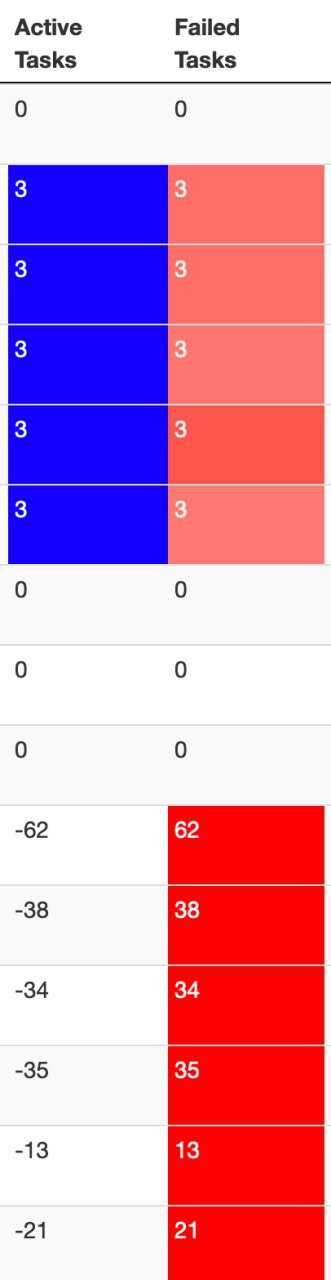

я может в танке, а при каких ситуациях отрицательное число тасок

2020 May 14

GP

я может в танке, а при каких ситуациях отрицательное число тасок

когда ты не очень продуктивен

PK

А вот и анонсик Spark on GPU https://m.youtube.com/watch?list=PLZHnYvH1qtOZ2BSwG4CHmKSVHxC2lyIPL&v=tpeGZ7nm0J0&index=3

GP

А вот и анонсик Spark on GPU https://m.youtube.com/watch?list=PLZHnYvH1qtOZ2BSwG4CHmKSVHxC2lyIPL&v=tpeGZ7nm0J0&index=3

круто что они вкладываются в это

GP

может родится новый ‘спарк’ в итоге

PK

может родится новый ‘спарк’ в итоге

Ну он, по факту, уже есть при чём, что радует, если оператор не реализован на gpu, то он не падает, а продолжает работать на CPU. В отличие от даска того же

GP

Ну он, по факту, уже есть при чём, что радует, если оператор не реализован на gpu, то он не падает, а продолжает работать на CPU. В отличие от даска того же

очень хорошо; а будет все у опенсурсе?

GP

а удобоно использовать? стоит ли ждать нового распределенного фреймворка или пока все же он топ оф спарк планируют?

R

Ну он, по факту, уже есть при чём, что радует, если оператор не реализован на gpu, то он не падает, а продолжает работать на CPU. В отличие от даска того же

А есть какие-нибудь бенчмарки вроде vanilla vs gpu? На TPC-H скажем

PK

А есть какие-нибудь бенчмарки вроде vanilla vs gpu? На TPC-H скажем

Есть, но пока внутри

PK

а удобоно использовать? стоит ли ждать нового распределенного фреймворка или пока все же он топ оф спарк планируют?

Как обычный спарк. Ну и с десяток опций как обычно )

R

Есть, но пока внутри

да-да, я нашел (тоже внутри 😁)