DZ

Size: a a a

2020 September 22

Дф это вот совсем не материализованное что-то

А

нельзя будет заменить вызов внутри udf:

spark.sql("select * from hive where id = ?")

на:

val df = spark.sql("select * from hive").persist()

udf(df)

df.filter("id"===1)

?

spark.sql("select * from hive where id = ?")

на:

val df = spark.sql("select * from hive").persist()

udf(df)

df.filter("id"===1)

?

А

или df нельзя передавать параметром?

DZ

или df нельзя передавать параметром?

Ты придумал джоин

А

Ты придумал джоин

ну человек пишет, что не может переделать удф в полной мере, конечно лучше было бы джойн

А

но, чтобы не дергать хайв отдельными запросами и не плодить подключения, которые медленные

DZ

но, чтобы не дергать хайв отдельными запросами и не плодить подключения, которые медленные

Чтобы не плодить, надо сделать как я написал выше

R

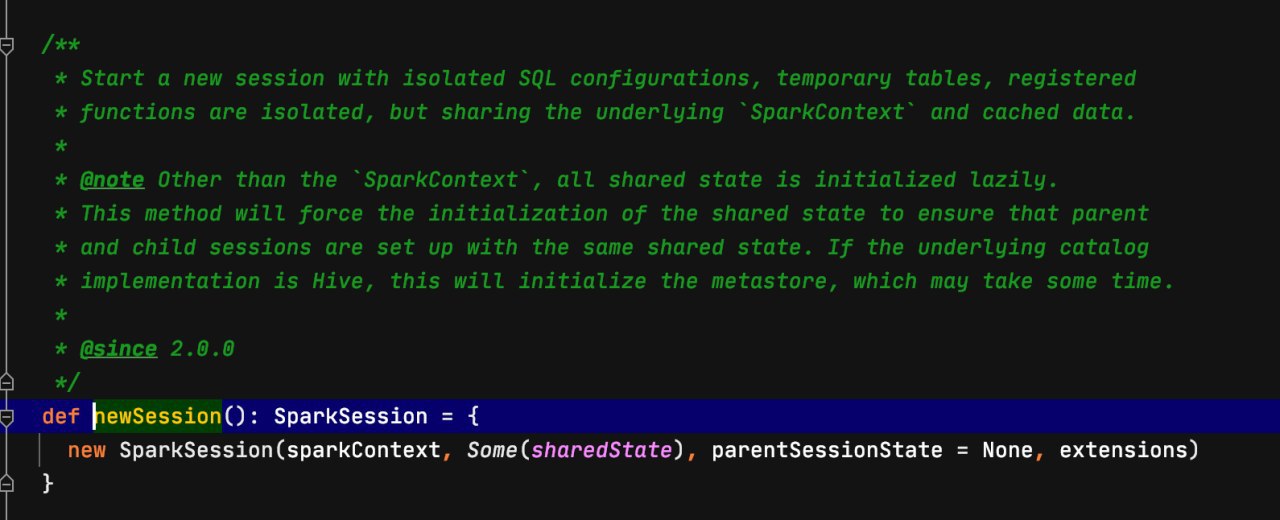

Это либо mapPartition

Я же правильно понял, что предлагается в map функции поднять новую спарксессию на экзекьюторе и через нее уже шухер делать в udf? (интереса ради)

DZ

Я же правильно понял, что предлагается в map функции поднять новую спарксессию на экзекьюторе и через нее уже шухер делать в udf? (интереса ради)

Нет конечно

PK

Я же правильно понял, что предлагается в map функции поднять новую спарксессию на экзекьюторе и через нее уже шухер делать в udf? (интереса ради)

Сессия - это синглтон

K

Сессия - это синглтон

GP

Я же правильно понял, что предлагается в map функции поднять новую спарксессию на экзекьюторе и через нее уже шухер делать в udf? (интереса ради)

не надо так делать ток; оно и не сработает и не стоит

2020 September 23

PK

А, это контекст синглтон, соррян

ИК

Всем привет!

Поясните такую ситуацию: spark 2.2 записывает датафрейм в паркет в HDFS с партиционирование по одному из полей.

Затем это же приложение начинает обрабатывать записанный датафрейм по партициям, читая каждую отдельно. Но иногда (не всегда) падает с ошибкой, потому что через некоторое время не может найти файл. Файлы в партициях есть, но UUID в их названиях не такой, как spark ожидает. Время создания файлов - намного позже, чем они были записаны изначально, по есть, в логе запись об окончании первого этапа в 5:00, файл записан в 6:00,а падение произошло в 6:30.

После перезапуска все норм, воспроизвести ошибку под контролем не удаётся.

Возможно ли, что UUID был изменен самим спарком в том же приложении? И как это предотвратить?

Поясните такую ситуацию: spark 2.2 записывает датафрейм в паркет в HDFS с партиционирование по одному из полей.

Затем это же приложение начинает обрабатывать записанный датафрейм по партициям, читая каждую отдельно. Но иногда (не всегда) падает с ошибкой, потому что через некоторое время не может найти файл. Файлы в партициях есть, но UUID в их названиях не такой, как spark ожидает. Время создания файлов - намного позже, чем они были записаны изначально, по есть, в логе запись об окончании первого этапа в 5:00, файл записан в 6:00,а падение произошло в 6:30.

После перезапуска все норм, воспроизвести ошибку под контролем не удаётся.

Возможно ли, что UUID был изменен самим спарком в том же приложении? И как это предотвратить?

2020 September 25

PK

Moscow Spark #10 быть! https://moscowspark.timepad.ru/event/1440202/

С

Moscow Spark #10 быть! https://moscowspark.timepad.ru/event/1440202/

Done

PK

Друзья, мне начали приходить письма про ссылку на участие. Ссылу на зум для первых 100 регистраций, ссылку на YouTube-трансляцию и ссылку на spatial chat вышлю во вторник или среду

С

Друзья, мне начали приходить письма про ссылку на участие. Ссылу на зум для первых 100 регистраций, ссылку на YouTube-трансляцию и ссылку на spatial chat вышлю во вторник или среду

Топ10 первых зареганных опубликуешь?)

PK

Сюткин

Топ10 первых зареганных опубликуешь?)

Нет канеш, там звёзды шоу бизнеса встречаются )

С