DT

Size: a a a

2021 June 15

Как перевести это на спарковый?

DT

Возникают на этапах шафла и записи, у меня подозрение в нехватке памяти

N

А там нету что ли спарк юай?

C

Sonja Cornelius has been banned! Reason: CAS ban.

DT

Есть, но причём здесь он

ММ

Посмотреть в нем метрики и логи

N

при том, что там записаны логи. можно посмотреть, какие таски умерли и по какой причине.

DT

Я написал причину смерти

DT

Там ничего конкретного не написано, ни в логах драйвера, ни воркеров, поэтому я и спросил про тех, кто сталкивался с такой ошибкой в датабриксе

EC

В ui есть лог по каждому потерянному воркеру, кидай пример. Если будет что то действительно экзотическое, найдем контакты в самом датабриксе, не вопрос

EC

Просто пример, fair отстрелит и будет worker losr или нода здоровье потеряет, исход будет тот же

EC

Короче с бухты барахты, никто тебе не скажет причину

2021 June 16

P

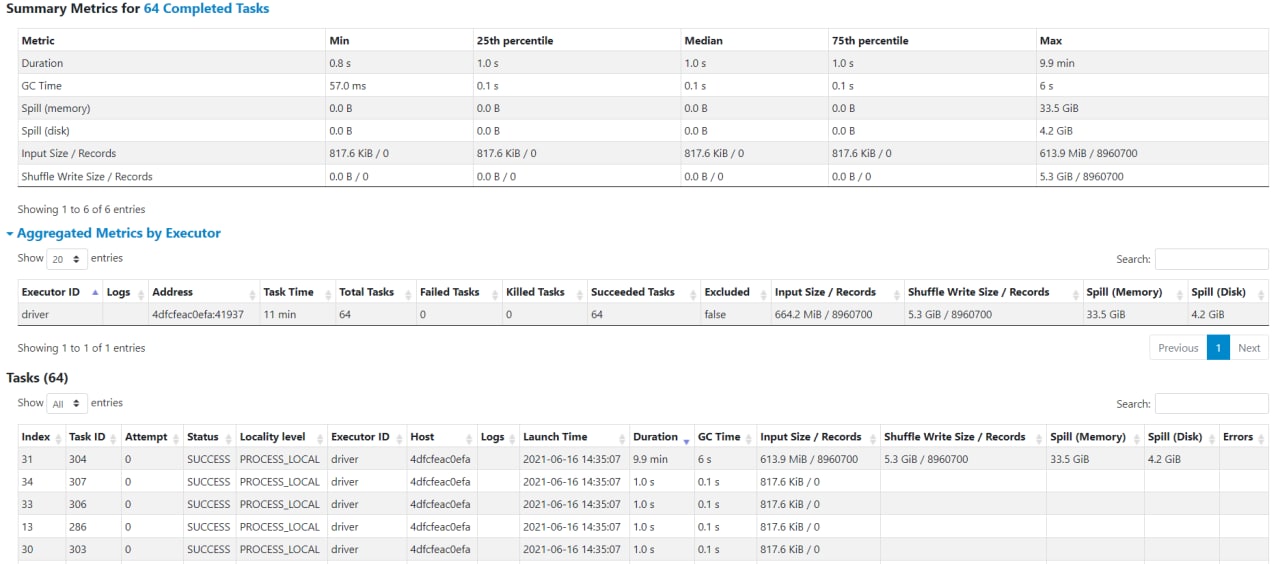

Всем привет, может кто-то знает в чем может быть проблема.

Запускаю спарк в local моде.

Код по сути две строчки на pyspark - прочитать паркет файл / сохранить этот же паркет файл без каких либо доп действий.

Файл 9млн строк и 250 колонок.

На 64 ядрах получается 64 таски, из которых 63 исполняются мгновенно, а 1 очень долго. На сколько я понимаю информацию из WebUI все данные обрабатываются в одной таске одним ядром.

Запускаю спарк в local моде.

Код по сути две строчки на pyspark - прочитать паркет файл / сохранить этот же паркет файл без каких либо доп действий.

Файл 9млн строк и 250 колонок.

На 64 ядрах получается 64 таски, из которых 63 исполняются мгновенно, а 1 очень долго. На сколько я понимаю информацию из WebUI все данные обрабатываются в одной таске одним ядром.

АБ

Не знаток спарка, но там как-то можно указывать партицирование входных данных, возможно тогда распараллелит

IS

Выглядит так, будто в одной партиции паркета все 9 миллионов строк

P

repartition всяко разно пытался использовать, и кол-во строк в одном partition смотрел, четко кол-во строк в датасете деленное на кол-во партиций

не помогает

не помогает

N

А сколько партиций сразу после чтения получается?

ММ

Покажи dag

P

Если читаю таким образом df = spark.read.parquet(path), то партиция получается одна, как раз таки с id=31, id таска такой же.

+-----------+-------+Если добавляю repartition(8), то 8 пратиций по равному кол-ву записей

|partitionId| count|

+-----------+-------+

| 31|8960700|

+-----------+-------+

+-----------+-------+Но при любом из вариантов все выполняется в одной таске.

|partitionId| count|

+-----------+-------+

| 4|1120087|

| 5|1120087|

| 3|1120087|

| 2|1120087|

| 6|1120088|

| 0|1120088|

| 1|1120088|

| 7|1120088|

+-----------+-------+

ИК

Размер файла? Сжатие snappy?