AA

Size: a a a

2018 December 23

После прочтения завелось как положено

AA

Нет, если ты его записал на диск, то count уже не нужен

В любом случае починилось, спасибо большое!!!

AS

Anton Alekseev

После прочтения завелось как положено

Так я это имел ввиду, записал а потом это прочитал :)

AA

Так я это имел ввиду, записал а потом это прочитал :)

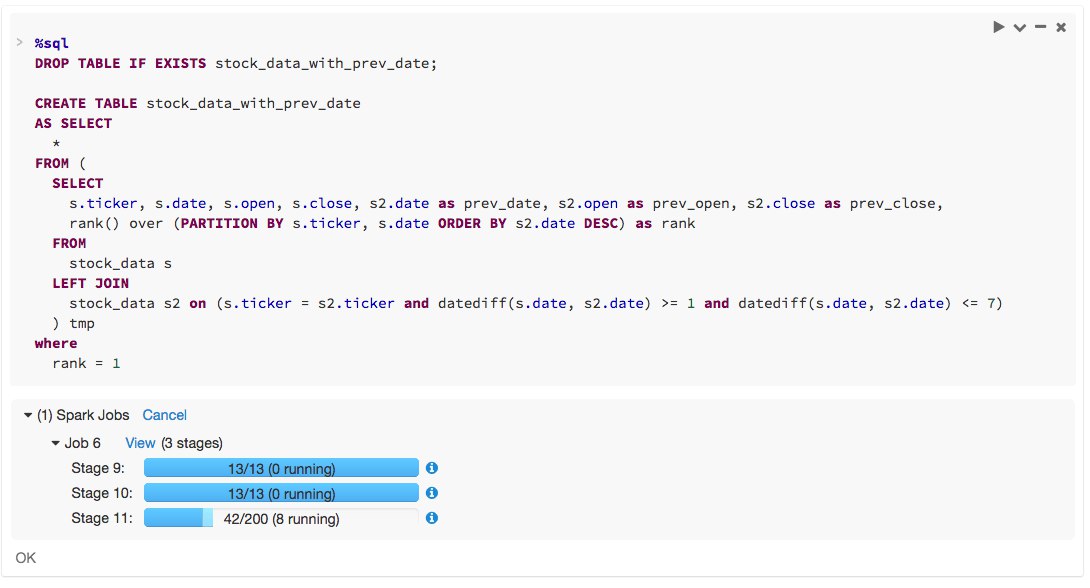

А вообще как вы определяете когда запустить процесс сохранения-чтения на датафрейме, сами глазами поглядываете где проседает перформанс? Из статьи не совсем понял. Я вообще практику count взял из статьи databricks, не ожидал что они такой нюанс не покроют. https://databricks.com/blog/2016/10/18/7-tips-to-debug-apache-spark-code-faster-with-databricks.html

AS

Я глазами (но не факт что это бест практис) , если что-то выполняется долго, смотрю граф выполнения, насколько он соответствует моему представлению о прекрасном :)

Чаще всего это итерактивный процесс в zeppelin

Чаще всего это итерактивный процесс в zeppelin

2018 December 24

PK

Всем привет! У нас появился свой канал на YouTube https://www.youtube.com/channel/UCb5cNv__wJLSbbc1k7iXXeQ. Подписывайтесь, чтобы быть в курсе записей с митапов, туда же буду постепенно накидывать клевые, на мой вкус, видео про Spark. Запись Moscow Spark #6 уже там, ссылка на презентации в описании.

AI

Ура

PM

PK

Видео с предыдущих митапов тоже буду туда потихоньку заливать.

2018 December 27

AA

Добрый день. Никто не заморачивался вопросом нормальной реализации melt (параллельного) над датафреймом? Топовое решение что для pyspak, что для scala довольно медленное на этапе формирования _vars_and_vals. https://stackoverflow.com/questions/41670103/how-to-melt-spark-dataframe

AA

Просто распараллелить не проблема, а вот реализация еще и с учетом задействования всех cpu кластера было бы интересно посмотреть.

2019 January 06

E

Всем привет, а с snowflake никто не работал?

2019 January 07

D

Я бы не советовал , зачем тебе лишнее соединение(я)

VE

Всем привет, не подскажете где можно найти полный список поддерживаемых датасорс форматов у dataframe?

Нашёл список у датабрикса, но насколько я понимаю, тут некоторые коннекторы только у них в экосистеме есть, правильно?

https://docs.databricks.com/spark/latest/data-sources/cassandra.html

Нашёл список у датабрикса, но насколько я понимаю, тут некоторые коннекторы только у них в экосистеме есть, правильно?

https://docs.databricks.com/spark/latest/data-sources/cassandra.html

2019 January 09

AI

Всем привет, не подскажете где можно найти полный список поддерживаемых датасорс форматов у dataframe?

Нашёл список у датабрикса, но насколько я понимаю, тут некоторые коннекторы только у них в экосистеме есть, правильно?

https://docs.databricks.com/spark/latest/data-sources/cassandra.html

Нашёл список у датабрикса, но насколько я понимаю, тут некоторые коннекторы только у них в экосистеме есть, правильно?

https://docs.databricks.com/spark/latest/data-sources/cassandra.html

Помимо встроенных в сам спарк, есть ещё кастомные: https://spark-packages.org

2019 January 14

N

Подскажите. Если читаю csv файл через и использую inferSchema

. То на основании каких строк выводятся типы ? Первой строки или первой ненулевой . Или все строк в файле?

. То на основании каких строк выводятся типы ? Первой строки или первой ненулевой . Или все строк в файле?

NU

Nikolay

Подскажите. Если читаю csv файл через и использую inferSchema

. То на основании каких строк выводятся типы ? Первой строки или первой ненулевой . Или все строк в файле?

. То на основании каких строк выводятся типы ? Первой строки или первой ненулевой . Или все строк в файле?

inferSchema – infers the input schema automatically from data. It requires one extra pass over the data. If None is set, it uses the default value, false.

я так понимаю, всех строк

я так понимаю, всех строк

N

Спасибо.