AK

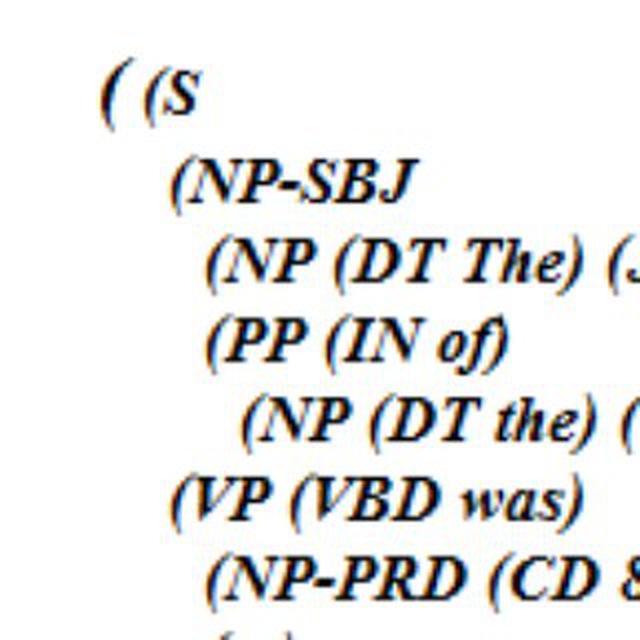

Есть 50 000 000 pdf-документов из российских судов (пример pdf-а https://gist.github.com/alexanderkuk/84c02d7b95f83de3e5befe27c03cdbfe#file-zzz_example-pdf, больше на http://kad.arbitr.ru/). Для подготовки к заседанию, юрист просматривает практику по аналогичным делам. Архив pdf-документов нужно фильтровать по имени судьи, ссылкам на законы и массе других критериев.

Есть крупный клиент, который хочет сделать сервис, основанный на этих данных, исправить проблемы существующих решений, добавить магию машинного обучения. Сейчас есть альфа-версия сервиса, нужно править баги, которые приходят от заказчика, добавлять новую функциональность.

Задачи:

* Разработка, поддержка грамматик для Yargy-парсера https://github.com/natasha/yargy.

* Создание, отладка статистических моделей. Иногда не получается извлечь сущности с помощью правил, тогда используются простые CRF-модели. Может быть, стоит перейти на что-то посложнее.

* Тестирование качества, починка багов.

* Разработка и поддержка веб-сервиса с REST-API.

* Оптимизация скорости обработки. Нужно чтобы сервис периодически обрабатывал 50 000 000 дел из архива и ежедневно парсил несколько тысяч новых дел.

Необходимые навыки:

* Хорошее знание Python, опыт работы с Git.

* Опыт обработки текстов на естественном языке. Плюсом будет опыт использования Томита-парсера или Yargy-парсера, представление об ML-алгоритмах для обработки текста.

* Плюсом будет опыт создания несложных веб-сервисов.

Работа удалённая. Возможна частичная занятость. Нужно будет сделать тестовую задачу https://gist.github.com/alexanderkuk/554499843fb3875ad3861e2b403126cc. Советую заранее посмотреть, она даёт хорошее представление о том, чем нужно будет заниматься. Рассказ о себе и вашем опыте, пожалуйста, присылайте на alex@alexkuk.ru.