SМ

Size: a a a

2021 January 20

Может и для поиска кто использует)

SМ

Месье разные бывают)

PV

да. гуглите BERT for google search

(GPT — генератор текста, а BERT — хорошие эмбеддинги).

или интересует именно генерация текста? тогда мне непонятна задача

(GPT — генератор текста, а BERT — хорошие эмбеддинги).

или интересует именно генерация текста? тогда мне непонятна задача

Да, верное замечание. Генератор текста в моем предположении как хилый способ брать наиндексированное и выдавать кратко, без издержек. Понятно что лишний слой, но если провести поиск как "общение" с поисковиком, мб что-то можно получить путного

YB

Знаю что ребята юзали для токсика гпт эмбеддинги)

у gpt эмбеддинги обычно похуже после fine-tuning. но может им это как-то помогало в их конкретной задаче.

SМ

Яндекс недавно писал, как они берт в поиск воткнули

https://habr.com/ru/company/yandex/blog/529658/

https://habr.com/ru/company/yandex/blog/529658/

Четкая статья! Вот видео с выступлением https://youtu.be/M0-UGNFa0PA

DD

Да, верное замечание. Генератор текста в моем предположении как хилый способ брать наиндексированное и выдавать кратко, без издержек. Понятно что лишний слой, но если провести поиск как "общение" с поисковиком, мб что-то можно получить путного

Яндекс.Алиса сейчас постепенно в этом направлении ползёт) Некоторая доля её ответов на фактоидные запросы как раз генерируется gpt-подобной нейронкой на основе поисковой выдачи.

PV

Вот, идея достаточно на поверхности, чтобы гиганты заинтересовались подобным))

Хотя в моем случае больше сторона "а возможно ли selfhosted", и полагаю что ответ да

Хотя в моем случае больше сторона "а возможно ли selfhosted", и полагаю что ответ да

AK

Да, верное замечание. Генератор текста в моем предположении как хилый способ брать наиндексированное и выдавать кратко, без издержек. Понятно что лишний слой, но если провести поиск как "общение" с поисковиком, мб что-то можно получить путного

тоже думаем в том направлении, что пробелма поиска именно в том, что он по одной фразе должен понять контекст. хотя контекст лучше понять из диалога. у вас какая задача в целом?

DD

Вот, идея достаточно на поверхности, чтобы гиганты заинтересовались подобным))

Хотя в моем случае больше сторона "а возможно ли selfhosted", и полагаю что ответ да

Хотя в моем случае больше сторона "а возможно ли selfhosted", и полагаю что ответ да

Selfhosted поисковый индекс - нуууу только если у вас очень много ресурсов, либо если вы ищете по достаточно ограниченному числу документов.

Selfhosted суммаризатор поисковой выдачи - изи, если у вас есть размеченные данные для его обучения.

Selfhosted суммаризатор поисковой выдачи - изи, если у вас есть размеченные данные для его обучения.

PV

Никакой пока, просто гипотетический интерес. Под это нужны свободные умные лапки и много железа, так что фантазии. Скажем если набирать самостоятельно информацию с вручную отобранных сайтов. Типа опеннет, хабр, либген и прочее. И потом хранить для локального использования. Целиком наиндексированное, а не гиперссылками на источники

AK

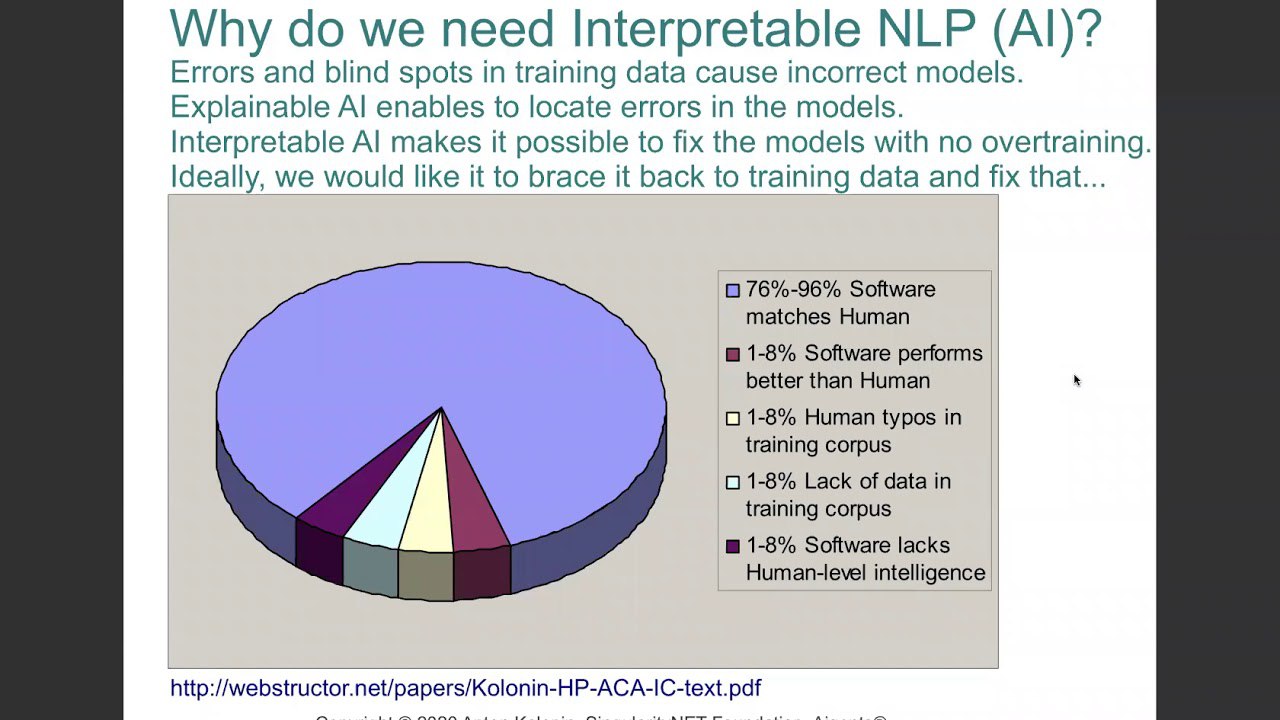

Если кого-то интересует "нейросимвольный NLP", вот тут я делюсь опытом нескольких проектов: https://www.youtube.com/watch?v=8RiNxYEk4D0

DD

Если кого-то интересует "нейросимвольный NLP", вот тут я делюсь опытом нескольких проектов: https://www.youtube.com/watch?v=8RiNxYEk4D0

А в текстовой форме есть?

Статьи, посты и т.п.

Статьи, посты и т.п.

AK

А в текстовой форме есть?

Статьи, посты и т.п.

Статьи, посты и т.п.

Ссылки на статьи есть в слайдах http://aigents.com/papers/2020/InterpretableLanguageProcessing2020.pdf

DD

Ссылки на статьи есть в слайдах http://aigents.com/papers/2020/InterpretableLanguageProcessing2020.pdf

О, спасибище!

ЕТ

Поясните, пожалуйста. Вот, есть у меня два набора имён: эльфийские, людоящеров и людские))0) Они сильно различаются на мой взгляд.

И я хочу сделать три модели, которые будут генерировать имя, похожее на один из трёх наборов.

Вопросы:

1) Я так понимаю, тут не особо подойдёт решение в лоб через цепи Маркова, потому что разная длина имён и всё такое;

2) Может, можно обойтись одной моделью?

И я хочу сделать три модели, которые будут генерировать имя, похожее на один из трёх наборов.

Вопросы:

1) Я так понимаю, тут не особо подойдёт решение в лоб через цепи Маркова, потому что разная длина имён и всё такое;

2) Может, можно обойтись одной моделью?

DD

Через цепи Маркова или посимвольную нейросетку вполне может получиться. Разница в длине имён тут не играет роли, ведь "конец имени" - такой же символ, как и все остальные, и модель точно так же может научиться его генерировать.

Думаю, что сделать три модели будет проще, чем одну модель, описывающую все три распределения.

Думаю, что сделать три модели будет проще, чем одну модель, описывающую все три распределения.

AA

Помню в курсе Andrew Ng по deep learning была похожая домашка - нужно было генерировать названия динозавров. Но там что-то с нейросетью было

ЕТ

Спасибо за направление!

A

Поясните, пожалуйста. Вот, есть у меня два набора имён: эльфийские, людоящеров и людские))0) Они сильно различаются на мой взгляд.

И я хочу сделать три модели, которые будут генерировать имя, похожее на один из трёх наборов.

Вопросы:

1) Я так понимаю, тут не особо подойдёт решение в лоб через цепи Маркова, потому что разная длина имён и всё такое;

2) Может, можно обойтись одной моделью?

И я хочу сделать три модели, которые будут генерировать имя, похожее на один из трёх наборов.

Вопросы:

1) Я так понимаю, тут не особо подойдёт решение в лоб через цепи Маркова, потому что разная длина имён и всё такое;

2) Может, можно обойтись одной моделью?

Можно заморочиться и описать по набору фонологических правил для каждого из "языков", а потом по нужному набору генерировать новые слова

Как здесь: https://www.zompist.com/gen.html

Как здесь: https://www.zompist.com/gen.html

ЕТ

Можно заморочиться и описать по набору фонологических правил для каждого из "языков", а потом по нужному набору генерировать новые слова

Как здесь: https://www.zompist.com/gen.html

Как здесь: https://www.zompist.com/gen.html

А вот это уже интереснее!