OS

Size: a a a

2021 May 31

я brat и толоку, но в обоих случаях надо переводить из их формата в BIO руками

OS

ну вообще там критична версия питона в первую очередь

EE

спасибо, питон у меня не тот - 3.9

AK

Добрый день!

Я тоже не смог пока установить на windows deep pavlov, даунгрейдил по одной версии постепенно , питон до 3.6, но не получается пока установка. ((

Отложил установку, думаю использовать коллаб

Я тоже не смог пока установить на windows deep pavlov, даунгрейдил по одной версии постепенно , питон до 3.6, но не получается пока установка. ((

Отложил установку, думаю использовать коллаб

VA

Попробуйте tensorflow версию проверить, помнится DP не переваривал выше 1.14 или 1.15

SМ

1.15 точно работает

OS

тф вроде нужен для большинства моделей но опциональный.

на винде я использую диппавлов из под wsl

на винде я использую диппавлов из под wsl

RS

А нет случайно описания данных?

A

Добрый день.

Помогите, пожалуйста, разобраться.

Вот Ярги-парсер - это однозначно rule-based подход к NER.

А вот Natasha? Она же на основе нейросетевого подхода реализована?

Помогите, пожалуйста, разобраться.

Вот Ярги-парсер - это однозначно rule-based подход к NER.

А вот Natasha? Она же на основе нейросетевого подхода реализована?

РН

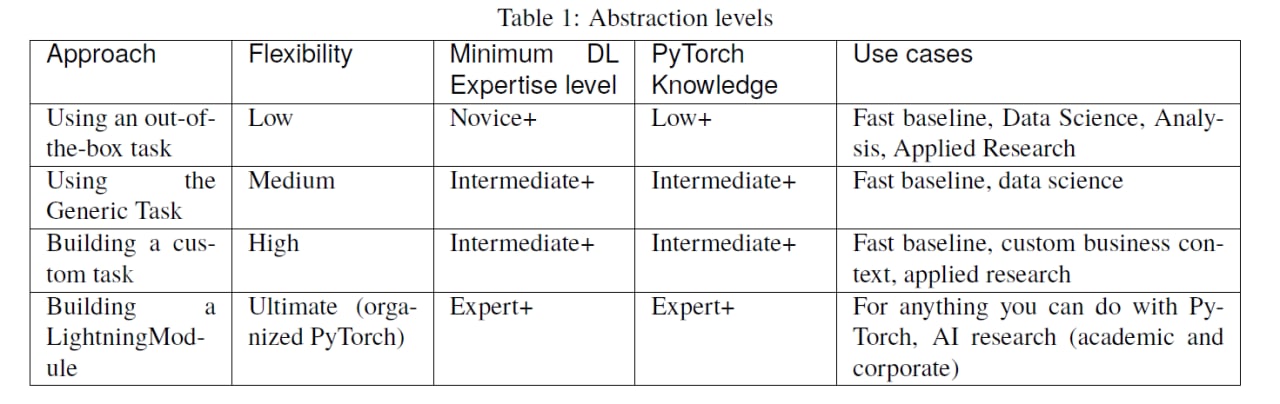

В экосреде PyTorch появились неплохие возможности для быстрого старта новичков (библиотека Flash) и экспертов (Lightning) в парадигме Tensorflow/keras. Для гуру по-прежнему доступен ванильный PyTorch. Не реклама) Возможность быстрого старта на серьёзном фреймворке.

OS

а что это за талица?

РН

Скриншот из документации библиотеки Flash-Lightning (надстройки Lightning, которая в свою очередь является надстройкой PyTorch). keras для PyTorch https://lightning-flash.readthedocs.io/en/latest/

МП

РН

Поправил)) Сорри.

A

давно пора было. а то чтобы быстрый эксперимент поставить приходилось слегка корячиться с бойлерплэйтом. спасибо

Е

Дистилляция BERT-модели

A

Спасибо большое за ответ. Т.е., переводя на язык "чайника". Natasha - это библиотека на основе нейронной сети. Этой сетью является "оптимизированная" ("упрощенная") нейронная сеть BERT. Я все правильно понял?

DD

Да, примерно так.

Вот пост, объясняющий детали: https://natasha.github.io/ner/

Вот пост, объясняющий детали: https://natasha.github.io/ner/

A

Спасибо

TM

выполняем задачу классификации очень коротких фраз (1-3 токена). Сейчас используем иерархическую классификацию на основе близости фразы к контрольным (косинусное расстояние). Пока точность удовлетворительная, но с ростом количества классов понимаем, что такой подход усложнит развитие сервиса. Хотелось бы спросить куда еще смотреть в плане признаков (кроме значения коэф. близости): n-граммы для слов не подходят, как использовать части речи пока тоже идей нет (вся фраза будет представлена с высокой вероятностью или ГЛ + СУЩ / СУЩ + ГЛ или СУЩ , так что непонятно как разделять с помощью POS) что порекомендуете еще? n граммы букв? добавить ливенштейна? построить связи родитель-потомок?