A

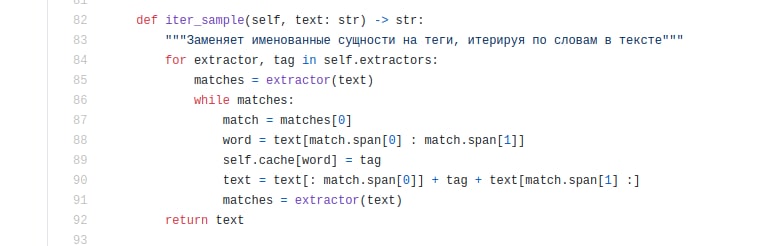

Я юзал вот этот скрипт https://github.com/pituganov/pyanonymizer (чуть ли не единственное решение по анонимизации для русского языка с открытым кодом, что я смог нагуглить. А так, только предложения от всяких Сберов и Ростелекомов купить их нейронку, которая обучалась n лет на суперкомпьютерах и якобы умеет всё... ну и стоит всего 10 лямов🙈). Там автор использует deppavlov и наташу именно для поиска NER'ов. Если подскажете как этот код подкрутить можно, чтобы туда можно было добавить в качестве исключений этот list_of_officials - буду вам очень благодарен 😃