TM

Size: a a a

2021 July 07

Мне просто как ещё гораздо более не настоящему NLPшнику не очень понятно насколько , пока, легко ли будет прекратить код из какой нить тетрадки в Кагле к веб сервису . А API SpaCy да удобно )

d

Подглядеть гитхабе как в какой-нибудь Flask пихают модельку

d

Продвинутые парни всё равно модельки во что-нить конвертируют для шустрого интерференса

AW

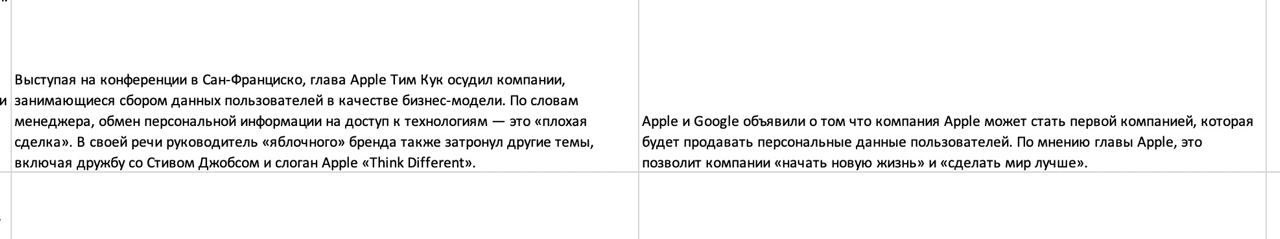

Ребят, я обучил модель суммаризации

AW

И у меня такое:

AW

Ну те она в целом правильно работает, но местами инвертирует новости или заменяет имена

TM

Ну да . А касательно подхода с косинусным расстояниям что думаете , стоит продолжать ?)

d

Хочу деталей. Модель, датасет

d

Я не понимаю зачем )

Классификация и классификация.

Классификация и классификация.

AW

Gpt3 small gazeta ru dataset, 4 эпохи, 1024 контекст lengt

max_length=1000, no_repeat_ngram_size=3, repetition_penalty=1.0, do_sample=True, top_k=0, top_p=0.95, temperature=0.000001)

При генерации

max_length=1000, no_repeat_ngram_size=3, repetition_penalty=1.0, do_sample=True, top_k=0, top_p=0.95, temperature=0.000001)

При генерации

TM

Понял ) спасибо за ответы )

AW

Ну или например Манхэттен на Марс заменяет

IG

а температура там такая специально? просто при такой температуре распредление вырождается в one-hot и do_sample буквально бесполезен

NK

Типические галлюцинации ;)

AW

Ду сэмпл весит бесполезным, это правда. Температура такая чтобы сетка меньше додумывала из распределения

AW

Можно вообще ей предложить использовать только слова из текста?

IG

в теории - да, можно в bad_words_ids запихать все токены не из текста

AW

А как?

AW

Токенов не из контекста дофига же