FF

Size: a a a

2020 August 26

Можно алгоритм агломеративной кластеризации попробовать c разными правилами объединения

AW

Товарищи а как вы сохраняете очищенные и токенизированные тексты? я когда выгрузил pd dataframe в csv я не смог обратно загрузить очищенную дату

KL

в каком смысле не смог, напиши подробнее

AW

Ну он видит питон массив как строку

AW

Те как" ['пример']"

DD

если хочешь питоновские объекты неизменными держать, сохраняй в pickle, дёшево и сердито

AW

Спасибо!

2020 August 27

AW

Смоделировал топики lsi шкой из новостей за несколько лет, бОльшая часть новостей грубо говоря шум?

выглядит так топик :

'0.189*"США" + 0.156*"Украины" + 0.090*"Он" + 0.090*"сказал" + 0.089*"Сирии" + 0.085*"отметил" + 0.083*"Путин" + 0.080*"Трамп" + 0.079*"Ранее" + 0.079*"Россия"'),

выглядит так топик :

'0.189*"США" + 0.156*"Украины" + 0.090*"Он" + 0.090*"сказал" + 0.089*"Сирии" + 0.085*"отметил" + 0.083*"Путин" + 0.080*"Трамп" + 0.079*"Ранее" + 0.079*"Россия"'),

AK

Сегодня - очередной еженедельный онлайн-семинар по "сильному ИИ" AKA AGI

AK

Переслано от Anton Kolonin

Меньше чем через 12 часов встречаемся с Serge в AGI in Russian https://aigents.timepad.ru/event/1412596/

YB

Смоделировал топики lsi шкой из новостей за несколько лет, бОльшая часть новостей грубо говоря шум?

выглядит так топик :

'0.189*"США" + 0.156*"Украины" + 0.090*"Он" + 0.090*"сказал" + 0.089*"Сирии" + 0.085*"отметил" + 0.083*"Путин" + 0.080*"Трамп" + 0.079*"Ранее" + 0.079*"Россия"'),

выглядит так топик :

'0.189*"США" + 0.156*"Украины" + 0.090*"Он" + 0.090*"сказал" + 0.089*"Сирии" + 0.085*"отметил" + 0.083*"Путин" + 0.080*"Трамп" + 0.079*"Ранее" + 0.079*"Россия"'),

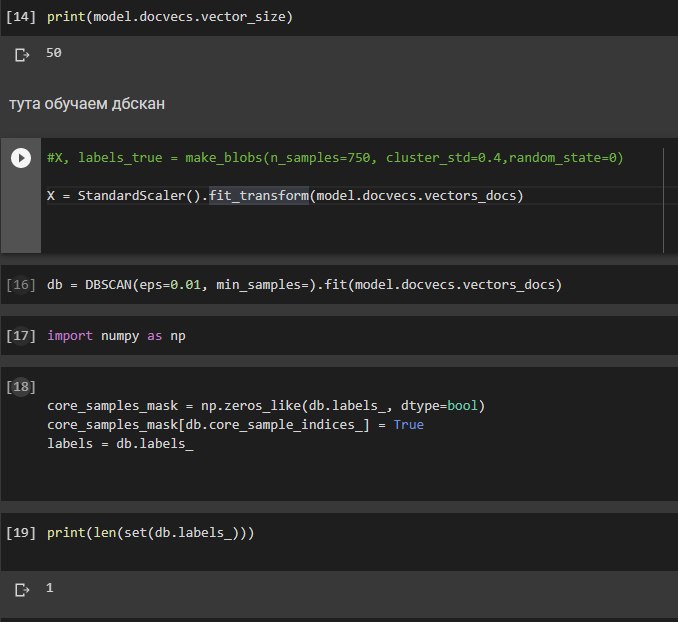

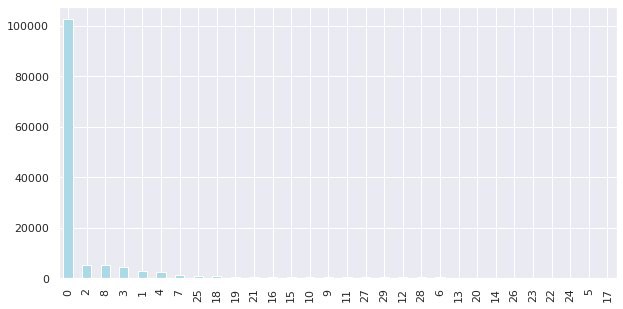

Нет, не шум, тема "внешняя политика". Но LSA алгоритмы приклеивают мелкие подтемы к основной большой теме, да и определение полученной темы плохо совпадает с человеческим. Всякие dbscan на эмбеддингах дают варианты получше, а supervised на имеющихся темах -- ещё лучше. В проекте "визуализация новостей" коллеги сначала делают supervised классификацию по крупным темам, а потом topic modelling с bigartm внутри темы. Тогда для их целей неплохо работает.

AW

Спасибо!

JG

Здравствуйте. Есть подзадача понять является название улицы именем человека (проспект Маяковского) или просто образовано от него и таким не является (Кутузовский проспект). Ярги это легко делает: для Маяковского list(addr_extractor.parser.findall(text))[3].tokens[2].forms[0] возвращает

Form('маяковский', Grams(NOUN,Sgtm,Surn,anim,gent,masc,sing)), а для Кутузовского - Form('кутузовский', Grams(ADJF,gent,masc,sing)) Где хранится атрибут Sgtm нашёл: grams.number. А вот где лежит так нужный мне Surn - ну никак. Можно взять из фрозен сета grams.values - но ведь должен же он где-то явно лежать.AB

Смоделировал топики lsi шкой из новостей за несколько лет, бОльшая часть новостей грубо говоря шум?

выглядит так топик :

'0.189*"США" + 0.156*"Украины" + 0.090*"Он" + 0.090*"сказал" + 0.089*"Сирии" + 0.085*"отметил" + 0.083*"Путин" + 0.080*"Трамп" + 0.079*"Ранее" + 0.079*"Россия"'),

выглядит так топик :

'0.189*"США" + 0.156*"Украины" + 0.090*"Он" + 0.090*"сказал" + 0.089*"Сирии" + 0.085*"отметил" + 0.083*"Путин" + 0.080*"Трамп" + 0.079*"Ранее" + 0.079*"Россия"'),

Можно попробовать сделать LSA+matrix rotation. На новостях темы выделяются довольно подробно. https://habr.com/ru/post/470618/ моя статья

AW

Спасибо

AB

Можно попробовать сделать LSA+matrix rotation. На новостях темы выделяются довольно подробно. https://habr.com/ru/post/470618/ моя статья

прототип такой.

YA

Переслано от Yerlan Amanzholov

Всем привет! Начинаю делать чатбота для казахского языка и хотел узнать, как можно сделать open-domain чатбот без большого количества данных? Буду рад любым советам или ресурсам, может кто то уже делал подобное.

SS

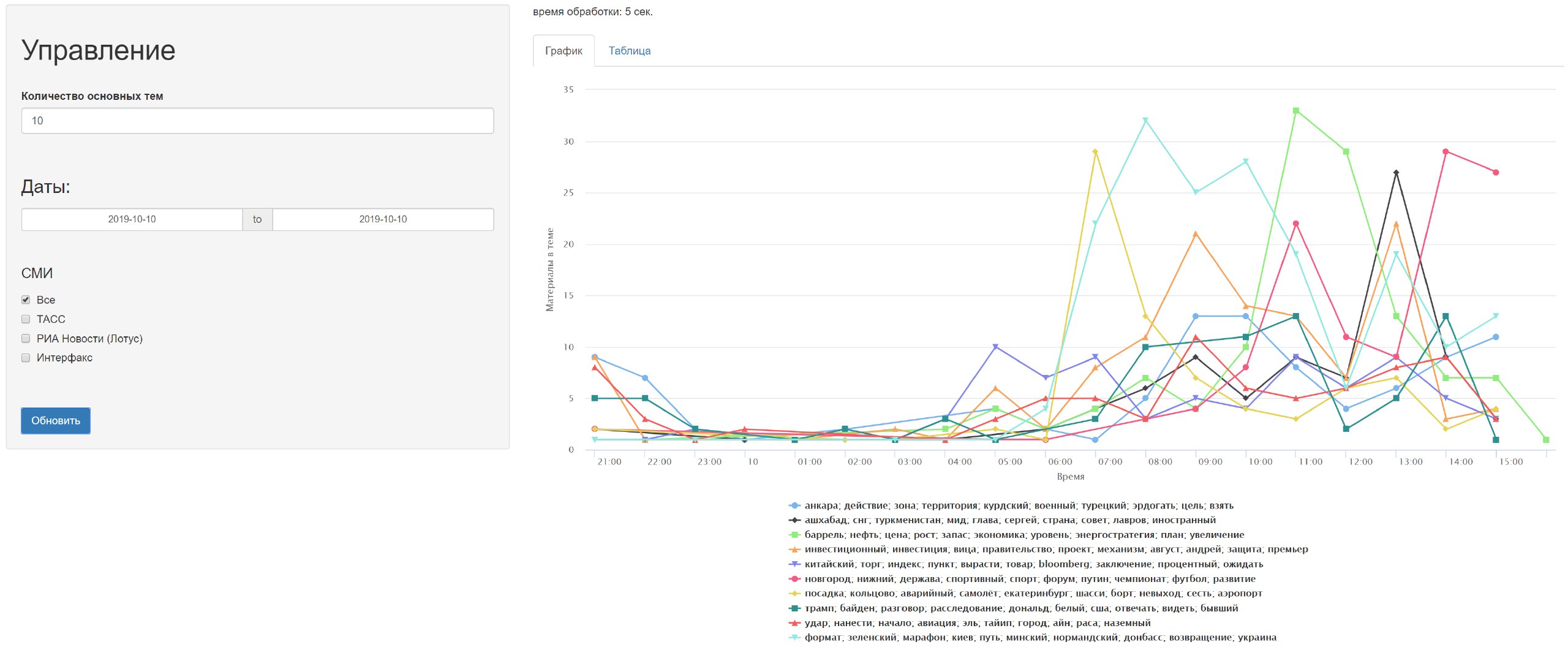

Нет, не шум, тема "внешняя политика". Но LSA алгоритмы приклеивают мелкие подтемы к основной большой теме, да и определение полученной темы плохо совпадает с человеческим. Всякие dbscan на эмбеддингах дают варианты получше, а supervised на имеющихся темах -- ещё лучше. В проекте "визуализация новостей" коллеги сначала делают supervised классификацию по крупным темам, а потом topic modelling с bigartm внутри темы. Тогда для их целей неплохо работает.

А что за проект про визуализацию новостей?

AW

А что за проект про визуализацию новостей?

Их много существует. И у ods и не только

AW

По сути если сможешь предсказать временной ряд новостей то много чего можно делать