AW

Size: a a a

2020 December 25

Народ а у кого то knowledge graph работают в компании?

BZ

Народ а у кого то knowledge graph работают в компании?

у нас работают в Сбере

K

Krep Kospit

Оффтоп,но, надеюсь, ничего не нарушаю. Я тут собрал книги Ницше в txt, на русском. Вдруг кому ещё надо)

Да

KK

Закинь плиз в датасеты Наташи))

Посоветуйте, как его подготовить. Я пока убрал отступы между главами и убрал цифры и их сочетания типа [56], *49

A

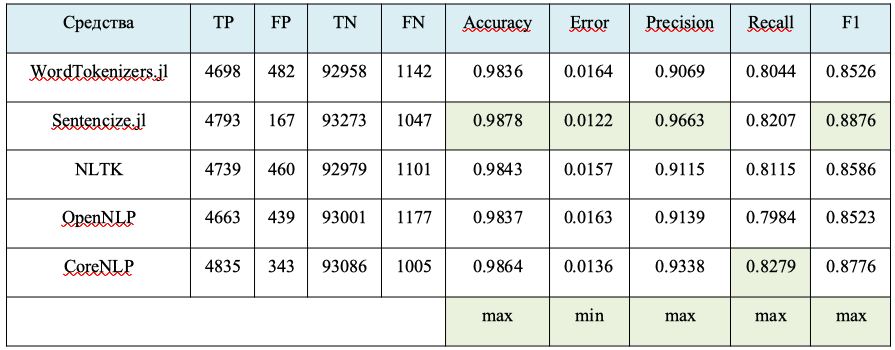

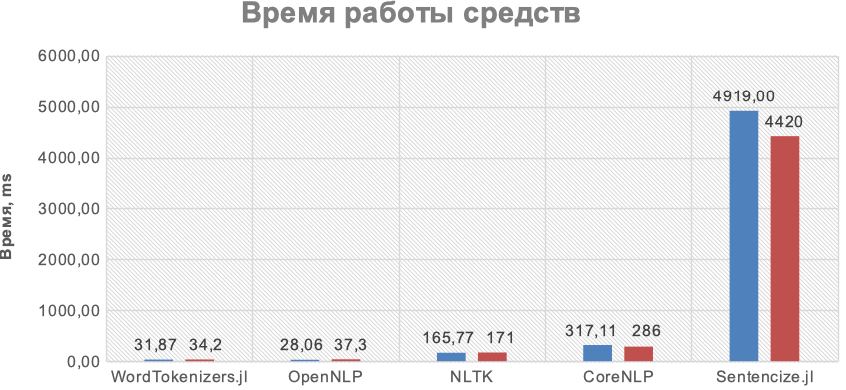

Какой метод разделения текста на предложения на английском языке является наиболее качественным? (в сравнении с nltk)

AW

Krep Kospit

Посоветуйте, как его подготовить. Я пока убрал отступы между главами и убрал цифры и их сочетания типа [56], *49

Оставь лучше ещё сырой, мб разные цели есть.

DK

Natalia

ну, видимо, так, да (хотя надо подумать, как написать так, чтобы в потоке issues не потонуло)

мы смотрим за issues у нас 🙂 это раз.

два, кстати, есть замечательные коллеги, работавшие ранее над Алисой, а затем сделавшие Label Studio

https://labelstud.io/

выглядит очень вдохновляюще.

С нашей стороны мы в целом за то, чтобы тоже такие инструменты делать, и даже ищем людей с опытом в разработке фронтендов 😉

https://deeppavlov.ai/careers

два, кстати, есть замечательные коллеги, работавшие ранее над Алисой, а затем сделавшие Label Studio

https://labelstud.io/

выглядит очень вдохновляюще.

С нашей стороны мы в целом за то, чтобы тоже такие инструменты делать, и даже ищем людей с опытом в разработке фронтендов 😉

https://deeppavlov.ai/careers

DK

Никаких примочек нет. Но лицензирование двойное. Поэтому открытую версию можно использовать только для некоммерческого использования и только под GPL-проекты. Впрочем, исправлять ошибки за эти деньги они будут.

Откровенно говоря, их размер лицензии примерно соответствует годовой зп инженера в тех краях.

Откровенно говоря, их размер лицензии примерно соответствует годовой зп инженера в тех краях.

у нас Apache 2.0 лицензия, в отличие от Stanford

RS

Ну так и CoreNLP - это, в первую очередь, Java. А у вас, судя по https://github.com/deepmipt и https://labelstud.io/, стек другой

DK

Ну так и CoreNLP - это, в первую очередь, Java. А у вас, судя по https://github.com/deepmipt и https://labelstud.io/, стек другой

Это не у нас в DeepPavlov, Label Stud.io делают мои бывшие коллеги из Яндекса

RS

Это не у нас в DeepPavlov, Label Stud.io делают мои бывшие коллеги из Яндекса

А что именно у DeepPavlov на Java?

OS

Оставь лучше ещё сырой, мб разные цели есть.

++

DK

Так 🙂

Сорри за путаницу.

Есть библиотека DeepPavlov, она написана на Python (преимущественно). Её лицензия - Apache 2.0.

Есть Stanford NLP, у которых код на Java (преимущественно). У них есть GPL для некоммерческих проектов и т.д., а для коммерческих - отдельная платная лицензия

Сорри за путаницу.

Есть библиотека DeepPavlov, она написана на Python (преимущественно). Её лицензия - Apache 2.0.

Есть Stanford NLP, у которых код на Java (преимущественно). У них есть GPL для некоммерческих проектов и т.д., а для коммерческих - отдельная платная лицензия

RS

Так 🙂

Сорри за путаницу.

Есть библиотека DeepPavlov, она написана на Python (преимущественно). Её лицензия - Apache 2.0.

Есть Stanford NLP, у которых код на Java (преимущественно). У них есть GPL для некоммерческих проектов и т.д., а для коммерческих - отдельная платная лицензия

Сорри за путаницу.

Есть библиотека DeepPavlov, она написана на Python (преимущественно). Её лицензия - Apache 2.0.

Есть Stanford NLP, у которых код на Java (преимущественно). У них есть GPL для некоммерческих проектов и т.д., а для коммерческих - отдельная платная лицензия

Ну, так, если надо проект на Java, то либо OpenNLP, либо Gate, либо CoreNLP с платной лицензией….

DK

Т.е, если "в лоб" сравнивать что университеты (Стэнфорд и МФТИ), что проекты (Stanford NLP и DeepPavlov), то видно, что возможности и ресурсы у Стэнфорда и у нас разные; не говоря уже о том, что DeepPavlov - молодой проект )

OS

Ну, так, если надо проект на Java, то либо OpenNLP, либо Gate, либо CoreNLP с платной лицензией….

jython 🤪

RS

Не вариант

RS

Производительность всегда есть на что потратить и без питона в проекте 🙂

RS

К вопросу о производительности на сегментации предложений. Черновые материалы. GUM Corpus. Фрагмент ~ 5 тыс предложений