АП

Size: a a a

2020 January 18

потому нужно 1. фильтровать все данные полученные извне скрипта. 2. разделять запросы и данные

ЯЗ

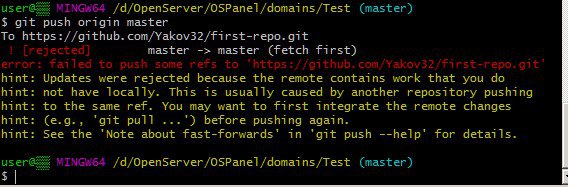

Немогу отправить, залупа якась вылазит((, помогити

P

там же написано что сделать нужно

P

якась залупа запушила в твій репозиторій, а ти завтикав спулити як лошара

О

якась залупа запушила в твій репозиторій, а ти завтикав спулити як лошара

Что ты готов сделать за сало

P

ничего, в общем-то

ЯЗ

якась залупа запушила в твій репозиторій, а ти завтикав спулити як лошара

Непонял

ЯЗ

Ну помогите пожалуйста, эта проблема уже хер знает сколько меня бьет

О

Непонял

В укропа играит

R

Ну помогите пожалуйста, эта проблема уже хер знает сколько меня бьет

Яж те видео скинул в личку, сделай пока так

P

В укропа играит

о, днр форэва?

h🐴

Всем привет! Поздно ли в 28 начинать изучать веб разработку?

нет

MB

Норм тестовое, многое позволит проверить

Задание (максимальное время выполнения 6-8 часов)

Реализовать CLI приложение-парсер сайта по заданному url со следующим функционалом:

1. Команда parse - запускает парсер, принимает обязательный параметр url (как с протоколом, так и без).

1.1. При переходе по переданному url, приложение должно найти все картинки, расположенные на странице, и сохранить их полные пути и страницу источник.

1.2. На анализируемой странице должны быть найдены все ссылки, ведущие на другие страницы данного домена, для каждой из этих страниц должен быть выполнен пункт 1.1. и 1.2.

1.3. В конце выполнения команда должна выдать ссылку на CSV файл с результатами анализа.

2. Команда report - выводит в консоль результаты анализа для домена, принимает обязательный параметр domain (как с протоколом, так и без).

3. Команда help - выводит список команд с пояснениями.

Дополнительные требования к заданию:

— архитектура должна быть легко расширяема.

Например: если нужно дополнительно сохранять все внешние ссылки или все заголовки на странице, должна быть возможность создать отдельный обработчик (реализовывать это не надо).

Обязательные требования:

— реализация на plain PHP;

— использование composer;

— OOP, SOLID, DRY;

— реализация должна быть размещена в публичном репозитории (bitbucket, github).

Запрещается:

— использовать фреймворки и их компоненты;

— использовать чужие библиотеки (даже Guzzle).

Разрешается:

— использовать свои библиотеки (при условии подключения их через composer);

— использовать любой удобный способ хранения данных.

Реализовать CLI приложение-парсер сайта по заданному url со следующим функционалом:

1. Команда parse - запускает парсер, принимает обязательный параметр url (как с протоколом, так и без).

1.1. При переходе по переданному url, приложение должно найти все картинки, расположенные на странице, и сохранить их полные пути и страницу источник.

1.2. На анализируемой странице должны быть найдены все ссылки, ведущие на другие страницы данного домена, для каждой из этих страниц должен быть выполнен пункт 1.1. и 1.2.

1.3. В конце выполнения команда должна выдать ссылку на CSV файл с результатами анализа.

2. Команда report - выводит в консоль результаты анализа для домена, принимает обязательный параметр domain (как с протоколом, так и без).

3. Команда help - выводит список команд с пояснениями.

Дополнительные требования к заданию:

— архитектура должна быть легко расширяема.

Например: если нужно дополнительно сохранять все внешние ссылки или все заголовки на странице, должна быть возможность создать отдельный обработчик (реализовывать это не надо).

Обязательные требования:

— реализация на plain PHP;

— использование composer;

— OOP, SOLID, DRY;

— реализация должна быть размещена в публичном репозитории (bitbucket, github).

Запрещается:

— использовать фреймворки и их компоненты;

— использовать чужие библиотеки (даже Guzzle).

Разрешается:

— использовать свои библиотеки (при условии подключения их через composer);

— использовать любой удобный способ хранения данных.

MB

На джуна тестовое

P

На джуна тестовое

Без газла конечно дичь

АП

Задание (максимальное время выполнения 6-8 часов)

Реализовать CLI приложение-парсер сайта по заданному url со следующим функционалом:

1. Команда parse - запускает парсер, принимает обязательный параметр url (как с протоколом, так и без).

1.1. При переходе по переданному url, приложение должно найти все картинки, расположенные на странице, и сохранить их полные пути и страницу источник.

1.2. На анализируемой странице должны быть найдены все ссылки, ведущие на другие страницы данного домена, для каждой из этих страниц должен быть выполнен пункт 1.1. и 1.2.

1.3. В конце выполнения команда должна выдать ссылку на CSV файл с результатами анализа.

2. Команда report - выводит в консоль результаты анализа для домена, принимает обязательный параметр domain (как с протоколом, так и без).

3. Команда help - выводит список команд с пояснениями.

Дополнительные требования к заданию:

— архитектура должна быть легко расширяема.

Например: если нужно дополнительно сохранять все внешние ссылки или все заголовки на странице, должна быть возможность создать отдельный обработчик (реализовывать это не надо).

Обязательные требования:

— реализация на plain PHP;

— использование composer;

— OOP, SOLID, DRY;

— реализация должна быть размещена в публичном репозитории (bitbucket, github).

Запрещается:

— использовать фреймворки и их компоненты;

— использовать чужие библиотеки (даже Guzzle).

Разрешается:

— использовать свои библиотеки (при условии подключения их через composer);

— использовать любой удобный способ хранения данных.

Реализовать CLI приложение-парсер сайта по заданному url со следующим функционалом:

1. Команда parse - запускает парсер, принимает обязательный параметр url (как с протоколом, так и без).

1.1. При переходе по переданному url, приложение должно найти все картинки, расположенные на странице, и сохранить их полные пути и страницу источник.

1.2. На анализируемой странице должны быть найдены все ссылки, ведущие на другие страницы данного домена, для каждой из этих страниц должен быть выполнен пункт 1.1. и 1.2.

1.3. В конце выполнения команда должна выдать ссылку на CSV файл с результатами анализа.

2. Команда report - выводит в консоль результаты анализа для домена, принимает обязательный параметр domain (как с протоколом, так и без).

3. Команда help - выводит список команд с пояснениями.

Дополнительные требования к заданию:

— архитектура должна быть легко расширяема.

Например: если нужно дополнительно сохранять все внешние ссылки или все заголовки на странице, должна быть возможность создать отдельный обработчик (реализовывать это не надо).

Обязательные требования:

— реализация на plain PHP;

— использование composer;

— OOP, SOLID, DRY;

— реализация должна быть размещена в публичном репозитории (bitbucket, github).

Запрещается:

— использовать фреймворки и их компоненты;

— использовать чужие библиотеки (даже Guzzle).

Разрешается:

— использовать свои библиотеки (при условии подключения их через composer);

— использовать любой удобный способ хранения данных.

со следующей функциональностью... ... функционалы - они в европах всяких

АП

Задание (максимальное время выполнения 6-8 часов)

Реализовать CLI приложение-парсер сайта по заданному url со следующим функционалом:

1. Команда parse - запускает парсер, принимает обязательный параметр url (как с протоколом, так и без).

1.1. При переходе по переданному url, приложение должно найти все картинки, расположенные на странице, и сохранить их полные пути и страницу источник.

1.2. На анализируемой странице должны быть найдены все ссылки, ведущие на другие страницы данного домена, для каждой из этих страниц должен быть выполнен пункт 1.1. и 1.2.

1.3. В конце выполнения команда должна выдать ссылку на CSV файл с результатами анализа.

2. Команда report - выводит в консоль результаты анализа для домена, принимает обязательный параметр domain (как с протоколом, так и без).

3. Команда help - выводит список команд с пояснениями.

Дополнительные требования к заданию:

— архитектура должна быть легко расширяема.

Например: если нужно дополнительно сохранять все внешние ссылки или все заголовки на странице, должна быть возможность создать отдельный обработчик (реализовывать это не надо).

Обязательные требования:

— реализация на plain PHP;

— использование composer;

— OOP, SOLID, DRY;

— реализация должна быть размещена в публичном репозитории (bitbucket, github).

Запрещается:

— использовать фреймворки и их компоненты;

— использовать чужие библиотеки (даже Guzzle).

Разрешается:

— использовать свои библиотеки (при условии подключения их через composer);

— использовать любой удобный способ хранения данных.

Реализовать CLI приложение-парсер сайта по заданному url со следующим функционалом:

1. Команда parse - запускает парсер, принимает обязательный параметр url (как с протоколом, так и без).

1.1. При переходе по переданному url, приложение должно найти все картинки, расположенные на странице, и сохранить их полные пути и страницу источник.

1.2. На анализируемой странице должны быть найдены все ссылки, ведущие на другие страницы данного домена, для каждой из этих страниц должен быть выполнен пункт 1.1. и 1.2.

1.3. В конце выполнения команда должна выдать ссылку на CSV файл с результатами анализа.

2. Команда report - выводит в консоль результаты анализа для домена, принимает обязательный параметр domain (как с протоколом, так и без).

3. Команда help - выводит список команд с пояснениями.

Дополнительные требования к заданию:

— архитектура должна быть легко расширяема.

Например: если нужно дополнительно сохранять все внешние ссылки или все заголовки на странице, должна быть возможность создать отдельный обработчик (реализовывать это не надо).

Обязательные требования:

— реализация на plain PHP;

— использование composer;

— OOP, SOLID, DRY;

— реализация должна быть размещена в публичном репозитории (bitbucket, github).

Запрещается:

— использовать фреймворки и их компоненты;

— использовать чужие библиотеки (даже Guzzle).

Разрешается:

— использовать свои библиотеки (при условии подключения их через composer);

— использовать любой удобный способ хранения данных.

+

АП

вот это человечее что то