НТ

Size: a a a

2020 July 23

Они чутка хуже и ресурс ниже

Хуже чем? Шумят сильнее или в плане подшипников?

НТ

И конструкции в целом

AB

Они чутка хуже и ресурс ниже

вряд ли будет хуже того тчо есть

НТ

вряд ли будет хуже того тчо есть

А что за магаз? Ттн бай или кст?

AB

А что за магаз? Ттн бай или кст?

Сокет

НТ

А, я как раз у них брал свои такие же

AB

М

Аккет самое лучшее агенство сми в мире

М

И шо

М

Без звука

AB

да там все гудит

AB

надо подумать еще может вентилятор в БП поменять

A

пздц у тебя там пыли)

М

да там все гудит

А почему без звука видос отправил

М

пздц у тебя там пыли)

Да это еще адекватно

AB

пздц у тебя там пыли)

Ну я не стал чистить, завтра уже все. В видюхе совсем плохо

СЮ

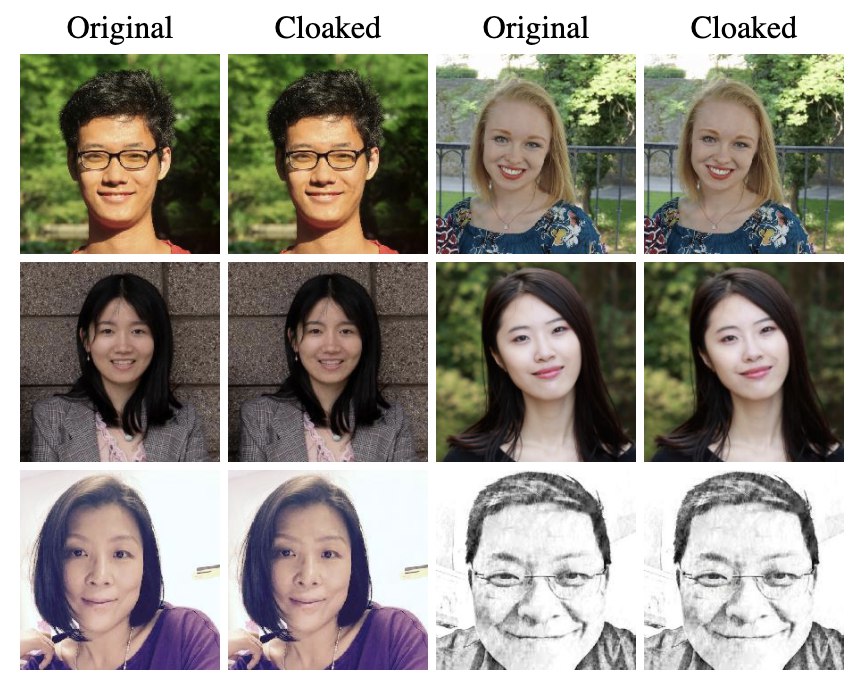

Техника незаметного искажения фотографий для нарушения работы систем распознавания лиц

Исследователи из лаборатории SAND при Чикагском университете разработали инструментарий Fawkes с реализацией метода искажения фотографий, препятствующего их использованию для обучения систем распознавания лиц и идентификации пользователей. В изображение вносятся пиксельные изменения, которые незаметны при просмотре людьми, но приводят к формированию некорректных моделей при использовании для тренировки систем машинного обучения. Код инструментария написан на языке Python и опубликован под лицензией BSD. Сборки подготовлены для Linux, macOS и Windows.

Обработка фотографий предложенной утилитой перед публикацией в социальных сетях и других публичных площадках позволяет защитить пользователя от использования данных фотографий в качестве источника для обучения систем распознавания лиц. Предложенный алгоритм предоставляет защиту от 95% попыток распознавания лиц (для API распознавания Microsoft Azure, Amazon Rekognition и Face++ эффективность защиты составляет 100%). Более того, даже если в будущем оригинальные, необработанные утилитой, фотографии будут использованы в модели, при обучении которой уже применялись искажённые варианты фотографий, уровень сбоев при распознавании сохраняется и составляет не менее 80%.

Из близких по назначению практических разработок можно отметить проект Camera Adversaria, развивающий мобильное приложение для добавления на изображения шума Перлина, мешающего корректной классификации системами машинного обучения. Код Camera Adversaria доступен на GitHub под лицензией EPL. Другой проект Invisibility cloak нацелен на блокирование распознавания камерами наблюдения через создание специальных узорчатых плащей, футболок, свитеров, накидок, плакатов или шляп.

https://github.com/Shawn-Shan/fawkes

Исследователи из лаборатории SAND при Чикагском университете разработали инструментарий Fawkes с реализацией метода искажения фотографий, препятствующего их использованию для обучения систем распознавания лиц и идентификации пользователей. В изображение вносятся пиксельные изменения, которые незаметны при просмотре людьми, но приводят к формированию некорректных моделей при использовании для тренировки систем машинного обучения. Код инструментария написан на языке Python и опубликован под лицензией BSD. Сборки подготовлены для Linux, macOS и Windows.

Обработка фотографий предложенной утилитой перед публикацией в социальных сетях и других публичных площадках позволяет защитить пользователя от использования данных фотографий в качестве источника для обучения систем распознавания лиц. Предложенный алгоритм предоставляет защиту от 95% попыток распознавания лиц (для API распознавания Microsoft Azure, Amazon Rekognition и Face++ эффективность защиты составляет 100%). Более того, даже если в будущем оригинальные, необработанные утилитой, фотографии будут использованы в модели, при обучении которой уже применялись искажённые варианты фотографий, уровень сбоев при распознавании сохраняется и составляет не менее 80%.

Из близких по назначению практических разработок можно отметить проект Camera Adversaria, развивающий мобильное приложение для добавления на изображения шума Перлина, мешающего корректной классификации системами машинного обучения. Код Camera Adversaria доступен на GitHub под лицензией EPL. Другой проект Invisibility cloak нацелен на блокирование распознавания камерами наблюдения через создание специальных узорчатых плащей, футболок, свитеров, накидок, плакатов или шляп.

https://github.com/Shawn-Shan/fawkes

AB

А почему без звука видос отправил

Смысл, этот чуть крутится и вряд ли что-то дает. Там притока нет, да и задница просила приключений