VS

Понимаю, что пишу не в тот чатик, но вдруг кто-то сталкивался с подобным.

Я хочу быстро перекладывать часть таблички из хайва в вертику, но etl инструменты делают это достаточно медленно в силу пропускной способности сети.

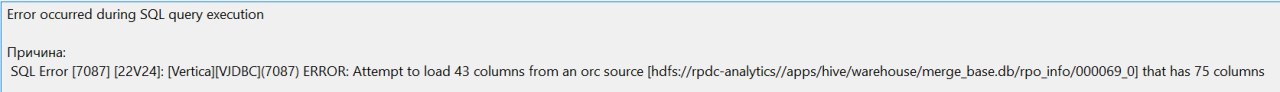

Хотела сделать external table, чтобы просто обращаться к hdfs, но... Оно сообщает мне, что я пишу не все столбцы, что есть в файле. Проблема в том, что в таблице порядка 100 столбцов, мне нужно только 40 штук, не хочу я вручную это все писать.

Тем более я думала, что ORC позволяет так делать...

Какие еще могут быть варианты для попробовать?