IL

AIRFLOW__CORE__DAGBAG_IMPORT_TIMEOUT=60 вроде не влияет на этоSize: a a a

IL

AIRFLOW__CORE__DAGBAG_IMPORT_TIMEOUT=60 вроде не влияет на этоSS

GB

VS

VS

GB

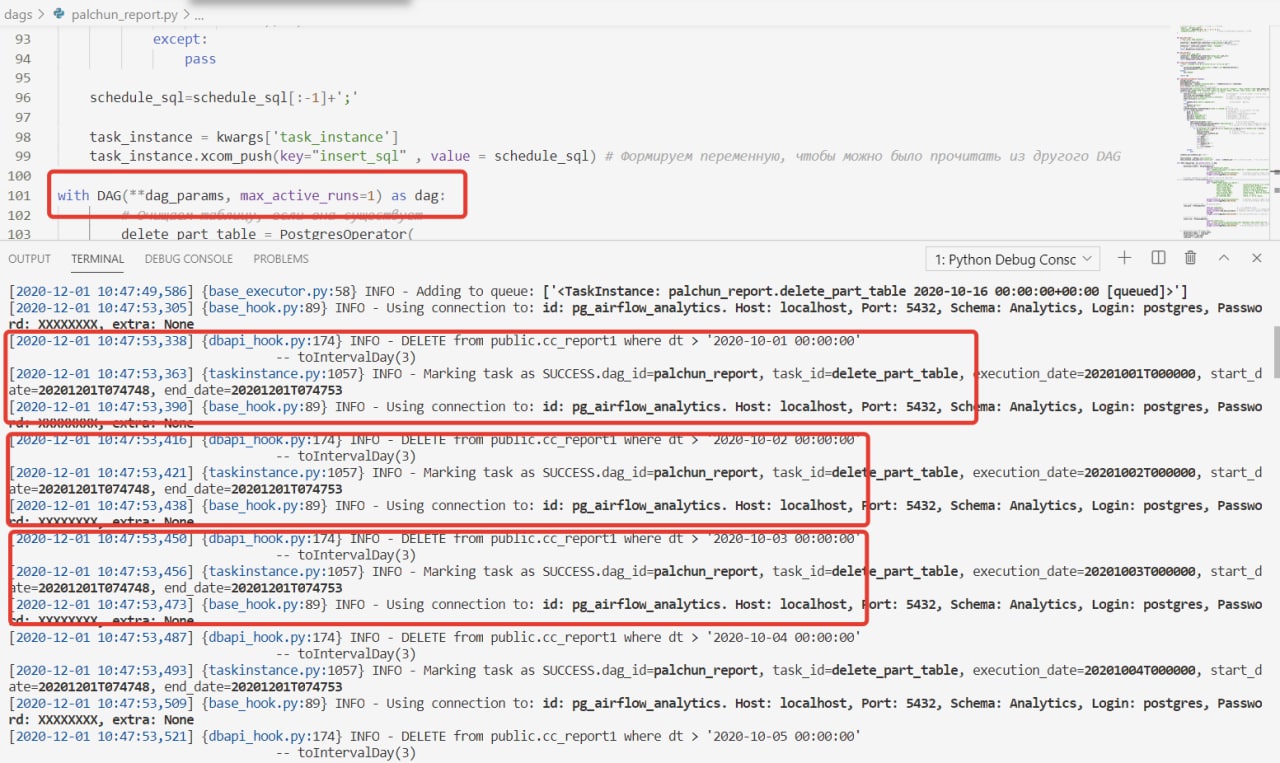

dag = DAG(max_active_runs = 1...)

catchup с самого раннего начинает вродеSS

dag = DAG(max_active_runs = 1...)

catchup с самого раннего начинает вродеА

VS

GB

GB

А

GB

SS

GB

GB

SS