ME

Size: a a a

ME

ME

ME

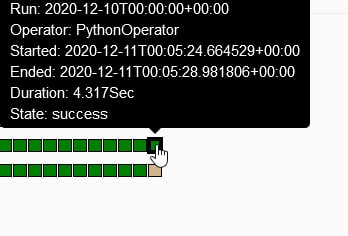

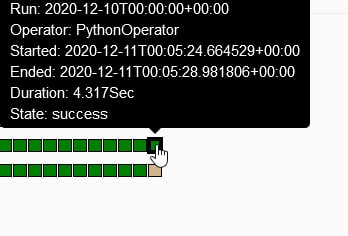

[2020-12-11 00:05:39,164] {taskinstance.py:662} INFO - Dependencies not met for <TaskInstance: ..... 2020-12-10T00:00:00+00:00 [scheduled]>, dependency 'Task Instance State' FAILED: Task is in the 'scheduled' state which is not a valid state for execution. The task must be cleared in order to be run.

[2020-12-11 00:05:39,294] {local_task_job.py:90} INFO - Task is not able to be runAB

ME

AB

ME

ME

ME

AB

A

AB

GB

min_file_process_interval побольше (дефолтный чуть ли не 1 секунда), и тогда вся логика, которая описана внутри файлов с дагами, но не в тасках, будет выполняться реже. Потому и считается правильным все задачи выполнять всё-таки в операторах. GB

AB

M