ME

Size: a a a

2021 March 01

можно так попробовать, тут через venv

🌌[

ME

либо pip install --target ./package

🌌[

У меня фишка в том, что я локально выкачиваю, перекидываю колёса на сервак, и там уже устанавливаю

🌌[

А, понял, под венвом выкачиваем, и крутим вертим в файлик

ME

да, он с нуля всё выкачает с депендами

ME

главное чтобы архитектура и ос совпадала с целевой машиной)

ME

а то под виндой будет немного не то, что под линуксом)

🌌[

Хе, вот тут и начинаются танцы

🌌[

Это я тож знаю

🌌[

Рабочие машины, такие рабочие..

🌌[

Так, тогда махнём в сторону изображения

🌌[

Ставим докер, дкомпост, и выкачиваем изображение

🌌[

Я там ссылку на изо скинул, можешь глянуть, это имелось ввиду :?

D

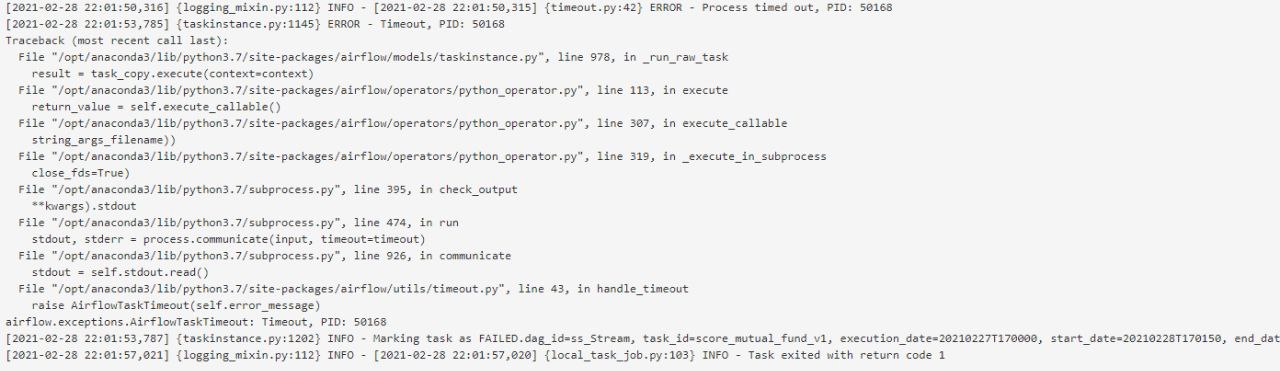

Всем привет! Есть лог ошибки выполнения таски, по таймауту. Локально все отрабатывает, а на сервере возникает таймаут для определённой модели. Подскажите пожалуйста что тут может быть или как протестировать. Заранее извините, если нет подробной инфы, надежда что у кого то подобное случалось...

🌌[

Если это все логи, то ГГ

НО вкратце: он к чему-то не может подключится, вот и всё.

НО вкратце: он к чему-то не может подключится, вот и всё.

DN

Всем привет, интересно услышать как архитектурно у вас организован запуск дагов. Для примера я встречал 2 подхода

1 - Все пишем в файле дага, то есть дописываем свои хуки/операторы

2 - Делаем отдельную папку /jobs где лежит вся кодовая база, а через airflow просто запускаем скрипты которые лежать в Jobs

Интересно услышать кто и почему выбрал одну из тактик, или вообще 3 подход. Буду рад советам о том как стоит организовать etl и какие проблемы и ограничения например у первого подхода.

1 - Все пишем в файле дага, то есть дописываем свои хуки/операторы

2 - Делаем отдельную папку /jobs где лежит вся кодовая база, а через airflow просто запускаем скрипты которые лежать в Jobs

Интересно услышать кто и почему выбрал одну из тактик, или вообще 3 подход. Буду рад советам о том как стоит организовать etl и какие проблемы и ограничения например у первого подхода.

GB

Всем привет, интересно услышать как архитектурно у вас организован запуск дагов. Для примера я встречал 2 подхода

1 - Все пишем в файле дага, то есть дописываем свои хуки/операторы

2 - Делаем отдельную папку /jobs где лежит вся кодовая база, а через airflow просто запускаем скрипты которые лежать в Jobs

Интересно услышать кто и почему выбрал одну из тактик, или вообще 3 подход. Буду рад советам о том как стоит организовать etl и какие проблемы и ограничения например у первого подхода.

1 - Все пишем в файле дага, то есть дописываем свои хуки/операторы

2 - Делаем отдельную папку /jobs где лежит вся кодовая база, а через airflow просто запускаем скрипты которые лежать в Jobs

Интересно услышать кто и почему выбрал одну из тактик, или вообще 3 подход. Буду рад советам о том как стоит организовать etl и какие проблемы и ограничения например у первого подхода.

Свои хуки/операторы/классы/функции держим в пакетах на приватном PyPi (в редких случаях – ставим по деплой токену гитлаба).

В самих файлах дага минимальная логика, описание ветвления, ну и очевидные импорты.

А так ничто не мешает складывать всё в одну кучу, просто не оч реюзабельно. Так сделали, потому что ETL-процессы уже были описаны, лежали по своим репозиториям и раньше крутились просто в докер-контейнерах по расписанию

В самих файлах дага минимальная логика, описание ветвления, ну и очевидные импорты.

А так ничто не мешает складывать всё в одну кучу, просто не оч реюзабельно. Так сделали, потому что ETL-процессы уже были описаны, лежали по своим репозиториям и раньше крутились просто в докер-контейнерах по расписанию

DN

Спасибо за ответ!

SG

Всем привет, интересно услышать как архитектурно у вас организован запуск дагов. Для примера я встречал 2 подхода

1 - Все пишем в файле дага, то есть дописываем свои хуки/операторы

2 - Делаем отдельную папку /jobs где лежит вся кодовая база, а через airflow просто запускаем скрипты которые лежать в Jobs

Интересно услышать кто и почему выбрал одну из тактик, или вообще 3 подход. Буду рад советам о том как стоит организовать etl и какие проблемы и ограничения например у первого подхода.

1 - Все пишем в файле дага, то есть дописываем свои хуки/операторы

2 - Делаем отдельную папку /jobs где лежит вся кодовая база, а через airflow просто запускаем скрипты которые лежать в Jobs

Интересно услышать кто и почему выбрал одну из тактик, или вообще 3 подход. Буду рад советам о том как стоит организовать etl и какие проблемы и ограничения например у первого подхода.

Структурирую как обычный питоновый проект, просто на самом верхнем уровне торчат кучи файлов dags_*.py всяких c объявлением дагов и импортами