ММ

Size: a a a

2021 May 24

Тег должен быть 3.8, а в repository нужно указать название образа в формате registry/image

SO

# The repository of the Kubernetes Image for the Worker to Run

worker_container_repository = my_registry_address_without_https/python

# The tag of the Kubernetes Image for the Worker to Run

worker_container_tag = 3.8

?

worker_container_repository = my_registry_address_without_https/python

# The tag of the Kubernetes Image for the Worker to Run

worker_container_tag = 3.8

?

SO

спасибо

АВ

Всем день добрый! Подскажите пожалуйста такой момент. Хочу на сервере развернуть airflow, вроде все ок, но когда запускаю webserver, workers вроде работают норм, но на локальной машине не открывается UI. С чем может такое может быть связано?

Думал дело в портах, если пробрасываю порт 8080 через ssh, то возникает ошибка, что порт занят...

Думал дело в портах, если пробрасываю порт 8080 через ssh, то возникает ошибка, что порт занят...

АВ

Как открыть его?

RM

всем привет, может кто подскажет

в JdbcHook пытаюсь динамически передать имя пользователя, но всеравно берет из подключения

JdbcHook(jdbc_conn_id='Oracle_jdbc', Login = 'user')

может кто подсказать что не так?

в JdbcHook пытаюсь динамически передать имя пользователя, но всеравно берет из подключения

JdbcHook(jdbc_conn_id='Oracle_jdbc', Login = 'user')

может кто подсказать что не так?

ME

в контексте всё есть

ME

можно через джинжа темплейты ещё

AA

Там много всякого, можно по-простому глянуть

def print_context(**kwargs):

print(kwargs)

print_context_task = PythonOperator(

task_id='print_context_task',

provide_context=True,

python_callable=print_context,

dag=dag,

)

MS

у нас на git(gitlab) настроен webhook, который дергает джоб дженкинс > джоб дженкинс делает git pull (на airflow переменные AIRFLOW__CORE__DAGS_FOLDER и AIRFLOW__CORE__PLUGINS_FOLDER смотрят в папки в склонированном git repo)

VA

ММ

dag в студию

VA

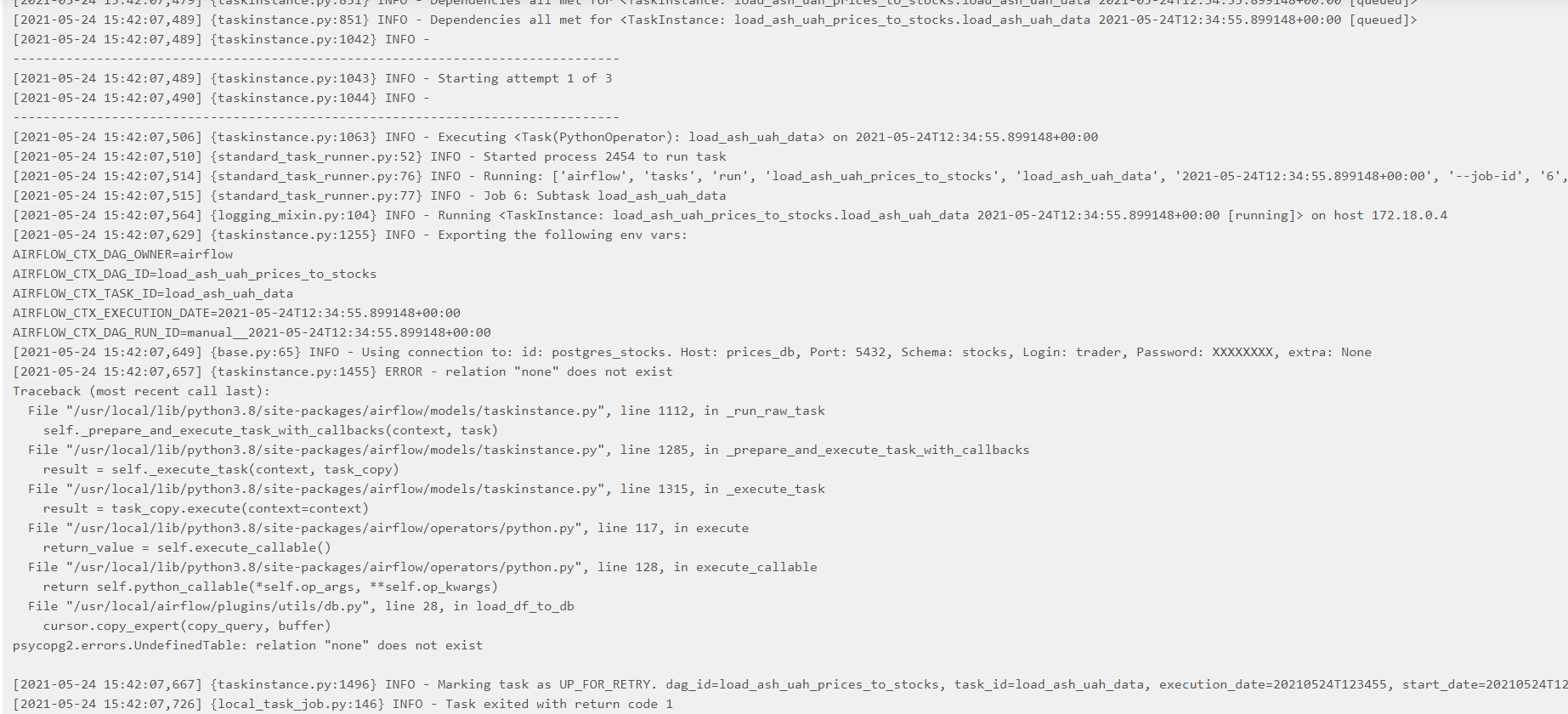

прикол в том, что на сервере в докере, который в интернете, то работает. а на локальном компьютере в докере не хочет (

но в принципе даг вот: from airflow import DAG

from airflow.operators.python import PythonOperator

from airflow.utils.dates import days_ago

from utils import db, whitebit, config

from datetime import timedelta

import os

DAG_ID = os.path.basename(file).replace('.pyc', '').replace('.py', '')

CONN_ID = 'postgres_stocks'

BASE_NAME_PRICE_TABLE = config.CONFIG.get(f'BASE_NAME_PRICE_TABLE')

TICKER = config.CONFIG.get('ASH_UAH_PAIR')

PRICE_TABLE = config.CONFIG.get(f'{TICKER}_{BASE_NAME_PRICE_TABLE}')

default_args = {

'owner': 'airflow',

'depends_on_past': False,

'start_date': days_ago(1),

'retries': 2,

'retry_delay': timedelta(minutes=5),

'email_on_failure': False,

'email_on_retry': False,

}

with DAG(

dag_id=DAG_ID,

default_args=default_args,

schedule_interval=None,

) as dag:

load_ash_uah_data = PythonOperator(

task_id='load_ash_uah_data',

python_callable=db.load_df_to_db,

op_kwargs={

'connector': CONN_ID,

'df': whitebit.get_price_by_ticker(

TICKER

),

'table_name': PRICE_TABLE,

}

)

но в принципе даг вот: from airflow import DAG

from airflow.operators.python import PythonOperator

from airflow.utils.dates import days_ago

from utils import db, whitebit, config

from datetime import timedelta

import os

DAG_ID = os.path.basename(file).replace('.pyc', '').replace('.py', '')

CONN_ID = 'postgres_stocks'

BASE_NAME_PRICE_TABLE = config.CONFIG.get(f'BASE_NAME_PRICE_TABLE')

TICKER = config.CONFIG.get('ASH_UAH_PAIR')

PRICE_TABLE = config.CONFIG.get(f'{TICKER}_{BASE_NAME_PRICE_TABLE}')

default_args = {

'owner': 'airflow',

'depends_on_past': False,

'start_date': days_ago(1),

'retries': 2,

'retry_delay': timedelta(minutes=5),

'email_on_failure': False,

'email_on_retry': False,

}

with DAG(

dag_id=DAG_ID,

default_args=default_args,

schedule_interval=None,

) as dag:

load_ash_uah_data = PythonOperator(

task_id='load_ash_uah_data',

python_callable=db.load_df_to_db,

op_kwargs={

'connector': CONN_ID,

'df': whitebit.get_price_by_ticker(

TICKER

),

'table_name': PRICE_TABLE,

}

)

ММ

скорее всего не хватает какого-нибудь значения в конфиге Airflow, проверь BASE_NAME_PRICE_TABLE или TICKER. если не поможет, нужно смотреть в исходники

db.load_df_to_db, без них пока не понятно, что происходит