🎱

Если сайт даёт (и не банит), и ты можешь прожевать - хоть мульён запрашивай

но кажется, это не самая лучшая практика, решил узнать мнение экспертов

Size: a a a

🎱

🎱

МС

🎱

🎱

МС

🎱

🎱

МС

🎅B

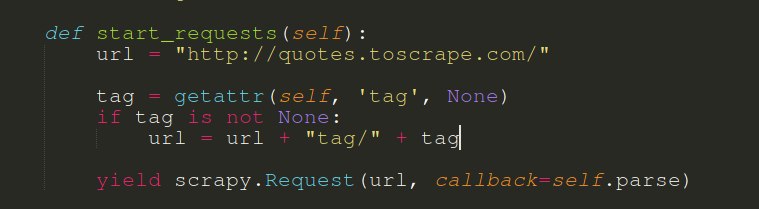

start_requestsнельзя передавать аргумент

responseНадеюсь, что хоть что-то вы поняли

МС

МС

🎅B

🎅B

МС

🎅B

def start_requests(self, response):

pass

🎅B

МС