i

Size: a a a

2020 June 18

Странно, если логиниться ручками через хром, не управляя им из селениума, то там в кукисах для ulogin.ru есть токен и этот же токен ulogin и для домена сайта пишется, а если логиниться через селениум, то этих токенов нет, но при этом я там также залогинен (т.к. цены товаров отличаются и кабинет я вижу). Бредятина.

SS

а google shop сильно сопротивляется парсингу?

AS

ufw у меня не установлен, а нули пробовал. Спасибо что помогаете

если мне не изменяет память, то чтобы контейнеры видели друг друга они должны быть в одной сети

AS

или уже не актуально?

OS

так они в одном docker-compose

AS

да, но надо еще networks объявить

AS

вот на примере упрощенного docker-compose для elasticsearch/kibana https://gist.github.com/al-serebrov/ac583ac799ebfaff1f27f96a3fdcc7db

AS

там есть инструкция networks для каждого контейнера и еще отдельно networks

AS

и, кажется, сеть еще и надо создать)

AS

это так, по памяти, когда-то давно в этом ковырялся))

OS

Спасибо большое, завтра поковыряю

AS

да, пожалуйста) let me know if it helps :)

OS

да, пожалуйста) let me know if it helps :)

обязательно

EB

как из bs4 получить назад html?

S

как из bs4 получить назад html?

str()

EB

хм, и правда, не думал что может быть так просто, после lxml…спасибо

2020 June 19

ПА

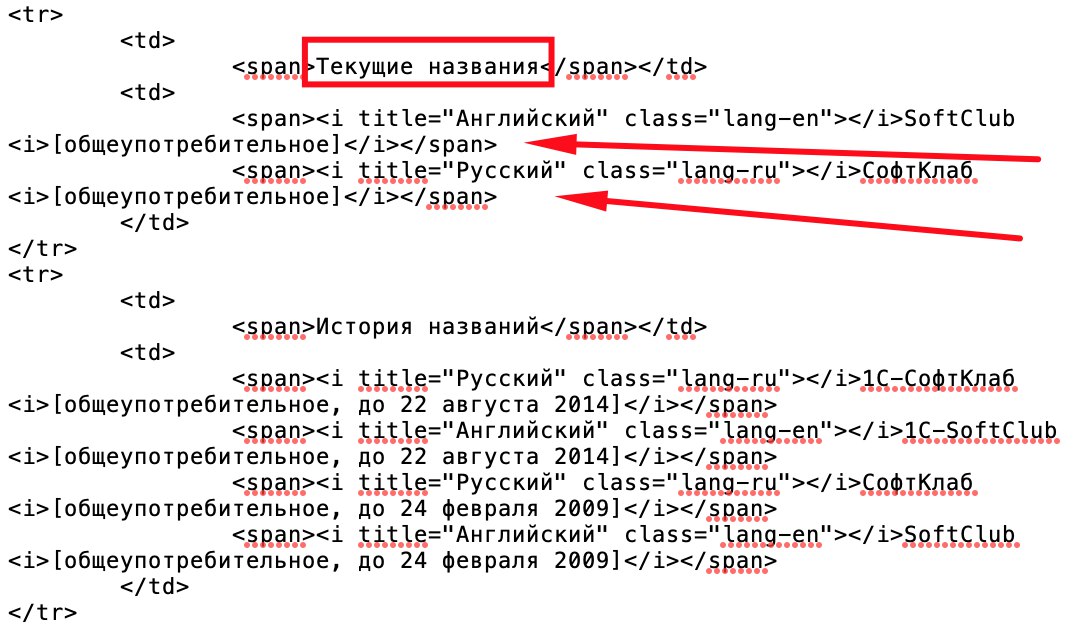

Привет, подскажите пожалуйста как с помощью XPATH выбрать все <span> которые выделил на скриншоте https://prnt.sc/t2mbtg

Пробовал так:

//tr[contains(./span,"Текущие названия")]/td[2]/span

По аналогии с CSS селекторами:

tr:contains("Текущие названия") td:nth-of-type(2) span::text

Но почему то этот CSS в Scrapy не работает.

Не могу понять как решить проблему.

Пробовал так:

//tr[contains(./span,"Текущие названия")]/td[2]/span

По аналогии с CSS селекторами:

tr:contains("Текущие названия") td:nth-of-type(2) span::text

Но почему то этот CSS в Scrapy не работает.

Не могу понять как решить проблему.

AS

//tr/span/[contains(text(),'Текущие названия')]/td[2]/span/text()