i

Size: a a a

2020 July 23

AR

что возвращает getall знает каждый кто паука отлаживал

МС

Народ, подскажите, авита после определенного количества IP банит? Если да - по какая цифра?

SS

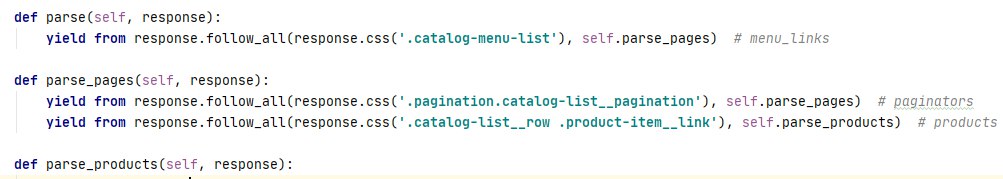

ну, щас можно (и следовательно нужно) делать

yield from response.follow_all()вместо

for i in range(len(urls)):

yield scrapy.Request(

url=response.urljoin(urls[i])

, callback=self.parse_productpage

)

можно написать

yield scrapy.follow_all(urls, , callback=self.parse_productpage)

?

for i in range(len(urls)):

yield scrapy.Request(

url=response.urljoin(urls[i])

, callback=self.parse_productpage

)

можно написать

yield scrapy.follow_all(urls, , callback=self.parse_productpage)

?

AR

жесть какая

AR

for i in range(len(urls)) не надо было писать в питоне вообще никогда

AR

или это юмор такой?

AR

а yield scrapy.Request(url=response.urljoin уже год или два можно сокращать до response.follow

МС

наверно человек просто с другого языка пришел

та же старая делфя или еще что

AR

да я понимаю что любой язык без foreach

AR

но надо ж базовые конструкции языка понимать

i

вместо

for i in range(len(urls)):

yield scrapy.Request(

url=response.urljoin(urls[i])

, callback=self.parse_productpage

)

можно написать

yield scrapy.follow_all(urls, , callback=self.parse_productpage)

?

for i in range(len(urls)):

yield scrapy.Request(

url=response.urljoin(urls[i])

, callback=self.parse_productpage

)

можно написать

yield scrapy.follow_all(urls, , callback=self.parse_productpage)

?

yield from только в случае с follow_all