МС

Size: a a a

2020 December 15

AP

Вот .... этот больше всего подошел )

МС

просто их овердохрена. И те, что подходят для одного, могут не подойти для другого. И это актуально и для пользователя и для сайта

AP

дык это понятно ) просто куда не кинся - большинство зарубежных АйПи, а сильно желательно только на територии РФ

МС

файнпрокси - максимальный пакет 3000 ip

AP

сейчас ознакомлюсь, спасиб

A

помогите понять где ошибка

A

проблема: если не решило капчу после запуска, тогда колбек назад на решение уже не дает никакого результата (никогда)

AR

а реквест выполняется?

A

да все ок, дает нормальную капчу, но решение по подходит

A

если после запуска с первого раза проходит - работает

AP

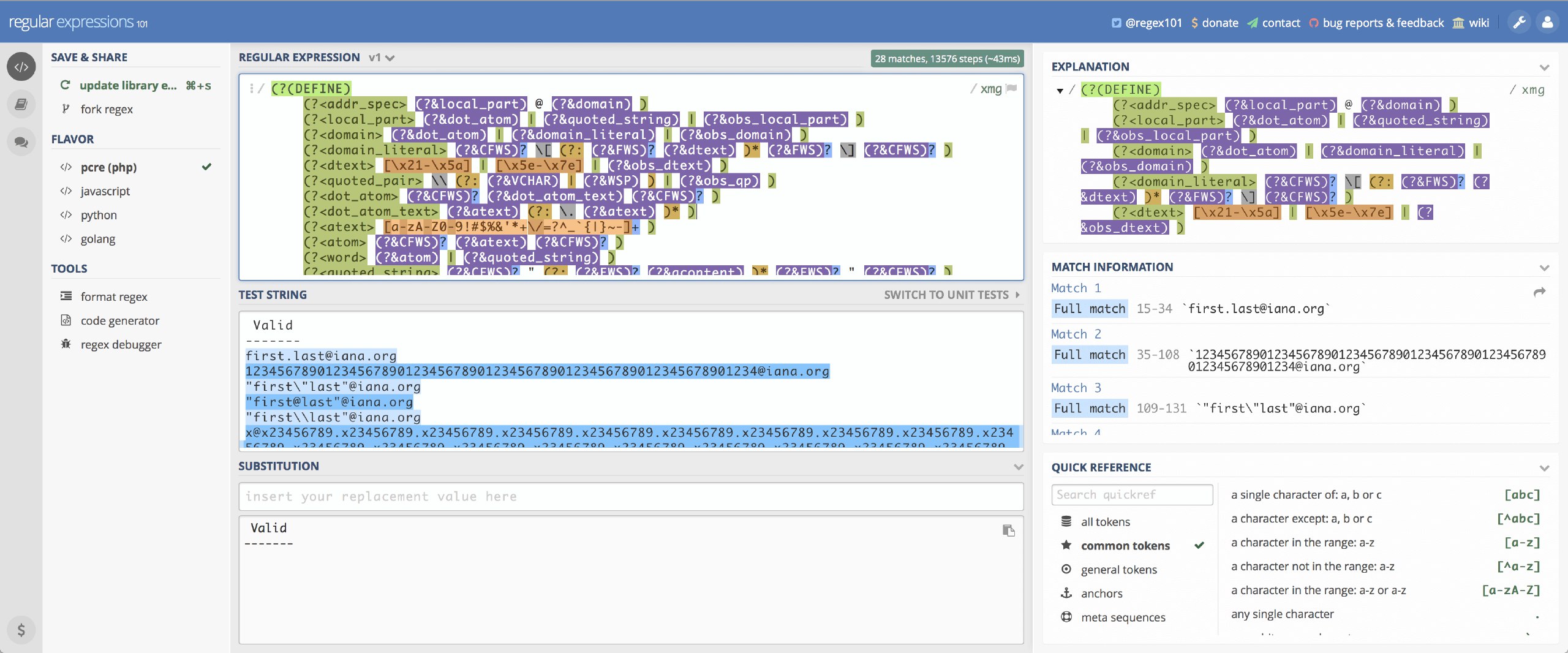

https://regex101.com/ лучше всех альтернатив.

спасибо

D

Скажите, пожалуйста, как можно установить задержку между ретрай запросами? Чтобы действовало именно для ретраев, а не для всех запросов. Пробовал переопрелелять метод RetryMiddleware используя time.sleep() - но это блокирующий способ. Нужно чтобы другие запросы выполнялись, пока для этого запроса ждём

МС

нашел какой то костыль, хз начсет рабочести

def parse(self, response):

nextreq = Request('http://en.wikipedia.org')

dfd = defer.Deferred()

reactor.callLater(DELAY, dfd.callback, nextreq)

return dfd

AR

переопрелеляй метод RetryMiddleware используя reactor.callLater

К

нашел какой то костыль, хз начсет рабочести

def parse(self, response):

nextreq = Request('http://en.wikipedia.org')

dfd = defer.Deferred()

reactor.callLater(DELAY, dfd.callback, nextreq)

return dfd

Можно примерно так, ещё можно через non-blocking sleep, ещё можно что-то с задержкой в слотах довнлоадера придумать

МС

насчет слотов, кстати, тут народ что то ковырял

https://github.com/scrapy/scrapy/issues/802, опять же, "рояль немой" :))

https://github.com/scrapy/scrapy/issues/802, опять же, "рояль немой" :))

D

Спасибо за идеи, буду пробовать!