IP

Size: a a a

2020 September 01

Яндекс вообще меня расстроил. Написал красивый дескрипшен для главной, в гугл все ок, в яндексе подгрузил какие то обрубки текста где часть jsом должна подгружаться. Зачем придумывать велосипед..

попробуй вместо обрубков текста написать свой дескрипшн прям на странице, по идее яндекс должен подставить его

DE

попробуй вместо обрубков текста написать свой дескрипшн прям на странице, по идее яндекс должен подставить его

ну такое) попробую конечно

S

A

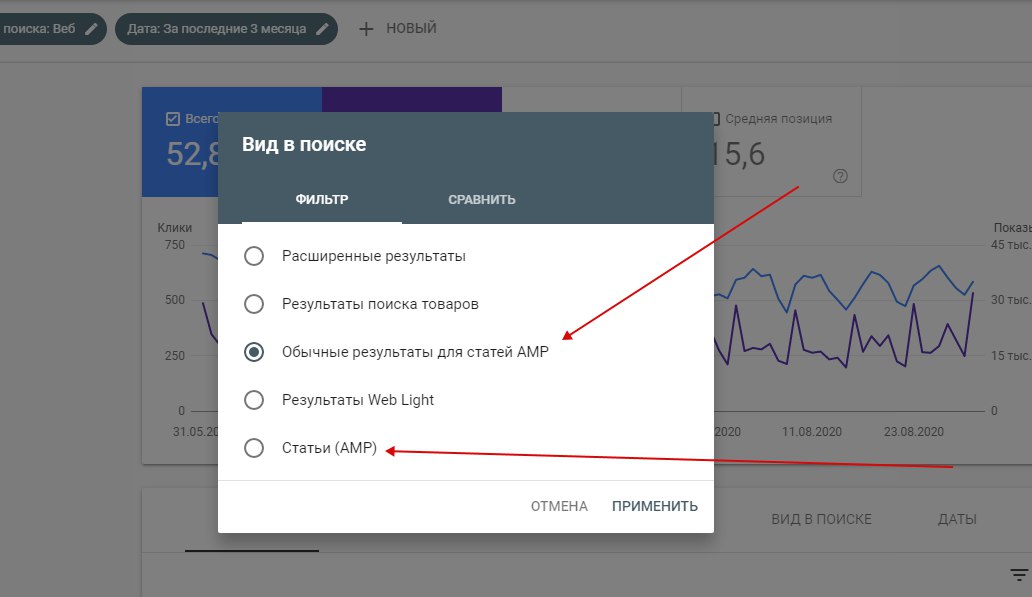

вы имеете в виду "Статьи АМП"?

S

Да

AI

Всем привет. Подскажите, пожалуйста, в Яндексе появились дубли главной вида site..ru/?p=xxxx. В этом случае Clean-param в роботсе будет просто p?

А

Лучше через метатег данный динамический параметр закрыть от индекса, чем через robots

AI

Лучше через метатег данный динамический параметр закрыть от индекса, чем через robots

Через noindex/nofollow?

А

AI

Просто дело в том, что я не знаю откуда взялись эти дубли. Фрог и паук не видит этих страниц, соответсвенно прописать им тег не получится

AI

Гугл их тоже не видит

А

У меня тоже было такое, что не выгружало таких страниц, но в вебмастере такие дубли были. Делал ТЗ прогеру и он закрывал их от индекса.

КБ

Лучше через метатег данный динамический параметр закрыть от индекса, чем через robots

а почему через роботс хуже? Я бы через роботс.тхт закрыла да и всё

КБ

интересно ваше мнение

А

Бывало такое, что когда закрываешь через роботс дин. параметры, они всё ровно попадали в выдачу. Когда закрывал через метатег - не попадали.

AI

У меня тоже было такое, что не выгружало таких страниц, но в вебмастере такие дубли были. Делал ТЗ прогеру и он закрывал их от индекса.

То чувство, когда ты вроде как сам им и являешься) ладно, спасибо большое, буду копаться, если что через роботс закрою и буду смотреть. Ну а вообще для site..ru/?p=xxx Clean-param: p, верно? Не будут другие урлы с таким параметром блочиться?

А

Верно. Думаю, может блочиться.

AI

Верно. Думаю, может блочиться.

Спасибо

А

Не за что

АЕ

Просто дело в том, что я не знаю откуда взялись эти дубли. Фрог и паук не видит этих страниц, соответсвенно прописать им тег не получится

Могу ошибаться, но у вас не Вордпресс ли?