EB

Size: a a a

2020 November 18

ВM

а оверлид беки анализирует?

в где?

ЕК

Дмитрий

Говорят как-то по liveinternet можно искать ключи, но как, может быть знаете?

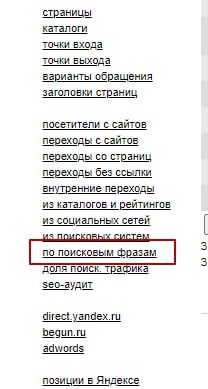

заходишь в общий список, ищешь открытые счетчики, заходишь во фразы

DT

Ребята, кто-то записывает "Оптимизация 2020"?)

ЕК

Damirka Tatarin

Ребята, кто-то записывает "Оптимизация 2020"?)

купи за 11к 😁

DT

купи за 11к 😁

Да, я поэтому и спросил)

ЕК

да сольют думаю

DT

да сольют думаю

Ждем!!!✊✊✊✊✊

С

а что тут странного если сайт на JS.

Если лягушка не парсит сайт - есть только 4 причины почему

1. robots.txt - перебирать useragent

2. сайт на JS - включить рендер

3. Сайт под паролем и логином - в лягушке прописать пароль и логин от сайта

4. сайт просто недоступен - отключён.

Если лягушка не парсит сайт - есть только 4 причины почему

1. robots.txt - перебирать useragent

2. сайт на JS - включить рендер

3. Сайт под паролем и логином - в лягушке прописать пароль и логин от сайта

4. сайт просто недоступен - отключён.

сайт не на js, просто этот сайт парсят (копируют контент) все, кому не лень. И у него куча примочек по защите от парсинга

Кстати, есть ли возможность в лягухе задать интервал пауза/старт? На минимальной скорости парсинга через некоторое время донор начинает выдавать лягухе пустые страницы (если открыть с браузера, страницы норм)

Помогло бы задать интервал: 5 минут парсит, передышка, продолжает. Есть какая-то возможность?

Кстати, есть ли возможность в лягухе задать интервал пауза/старт? На минимальной скорости парсинга через некоторое время донор начинает выдавать лягухе пустые страницы (если открыть с браузера, страницы норм)

Помогло бы задать интервал: 5 минут парсит, передышка, продолжает. Есть какая-то возможность?

AA

если есть доступ к статистике сайта в LI, то там есть сводка по запросам

как она тут называется?

AA

страница сводки

ЕК

как она тут называется?

AA

а, там закрыто :(

ЕК

значит не судьба, увы

AA

та и фиг с ним