DN

Size: a a a

2019 September 13

Получилось сделать запись?

Нет

2019 September 17

2019 September 24

P

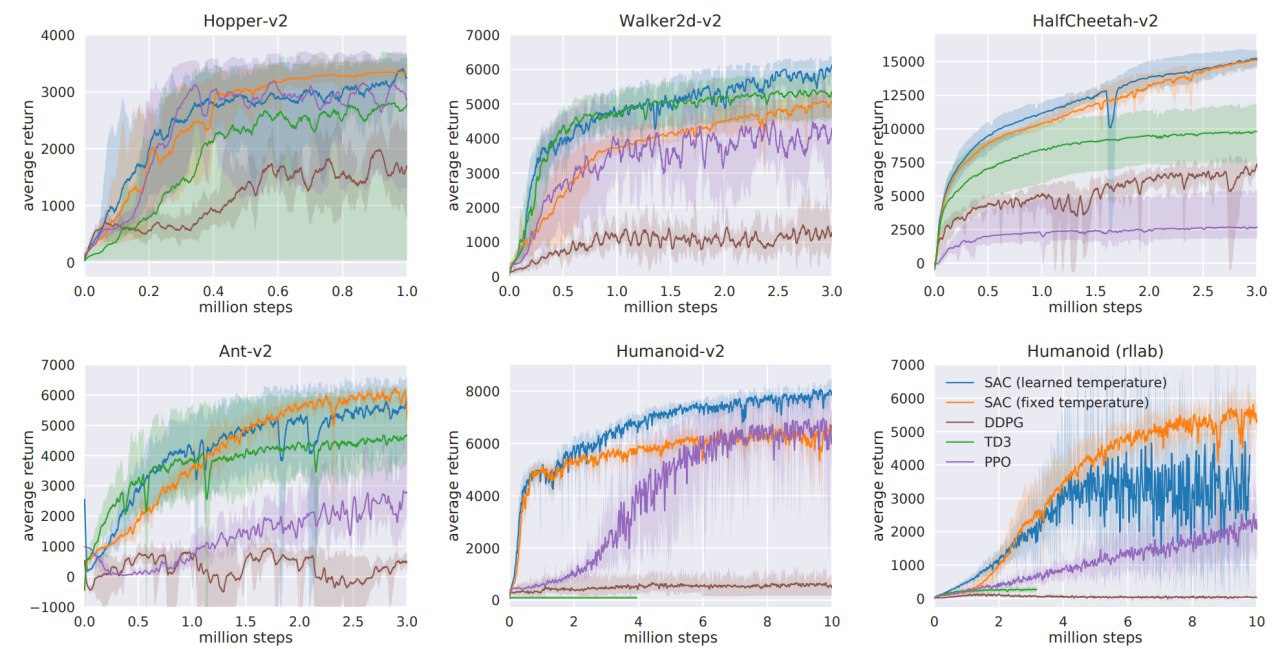

Коллеги, подскажите, пожалуйста, если кто шарит в continous control.

Знает ли кто методы с лучшим скором, чем SAC / TD3?

Знает ли кто методы с лучшим скором, чем SAC / TD3?

AP

PPO :) который готовят в OpenAI

AP

Я недавно чекнул метод кросс энтропии и был приятно удивлен

P

AP

Мне кажется это графики скорее про сэмпл эфишенси

AP

Ну и многое зависит от реализации может так быть что ваши имплементации обгонят эти

AP

Просто потому что у вас не будет багов

EZ

Просто потому что у вас не будет багов

Но обычно бывает наоборот

P

PPO :) который готовят в OpenAI

Trust Region-Guided Proximal Policy Optimization

https://arxiv.org/pdf/1901.10314.pdf

Говорят вот этот парень получше PPO, если кто еще PPO использует.

https://arxiv.org/pdf/1901.10314.pdf

Говорят вот этот парень получше PPO, если кто еще PPO использует.

P

Ну и многое зависит от реализации может так быть что ваши имплементации обгонят эти

Если кто знает имплементации, которые обгоняют графики выше — я был бы очень признателен.

AG

http://papers.nips.cc/paper/7451-simple-random-search-of-static-linear-policies-is-competitive-for-reinforcement-learning

Вот здесь есть более сильные цифры для Walker и Humanoid. Там, конечно, речи о sample efficiency идти не может, но зато есть примерная оценка потолка, который можно достичь.

Вообще, мне кажется, что все Mujoco среды достаточно задраны и текущие Sota-алгоритмы близки к максимально возможным наградам.

Вот здесь есть более сильные цифры для Walker и Humanoid. Там, конечно, речи о sample efficiency идти не может, но зато есть примерная оценка потолка, который можно достичь.

Вообще, мне кажется, что все Mujoco среды достаточно задраны и текущие Sota-алгоритмы близки к максимально возможным наградам.

EG

Но обычно бывает наоборот

Давно думаю о том, что баги регуляризуют модель

EZ

Давно думаю о том, что баги регуляризуют модель

Баян)

EG

Если уже есть что-то в сети про это, то было бы интересно посмотреть)

P

http://papers.nips.cc/paper/7451-simple-random-search-of-static-linear-policies-is-competitive-for-reinforcement-learning

Вот здесь есть более сильные цифры для Walker и Humanoid. Там, конечно, речи о sample efficiency идти не может, но зато есть примерная оценка потолка, который можно достичь.

Вообще, мне кажется, что все Mujoco среды достаточно задраны и текущие Sota-алгоритмы близки к максимально возможным наградам.

Вот здесь есть более сильные цифры для Walker и Humanoid. Там, конечно, речи о sample efficiency идти не может, но зато есть примерная оценка потолка, который можно достичь.

Вообще, мне кажется, что все Mujoco среды достаточно задраны и текущие Sota-алгоритмы близки к максимально возможным наградам.

Почти на 2тыс награда хуже, чем в скрине последнего SACa (walker, humanoid)

EZ

Если уже есть что-то в сети про это, то было бы интересно посмотреть)

Не могу найти первоисточник, но, например, вот https://twitter.com/beenwrekt/status/957290686386200576

AG

Почти на 2тыс награда хуже, чем в скрине последнего SACa (walker, humanoid)

В table 2 явно лучше награда

P

В table 2 явно лучше награда

Ссори не заметил вторую табличку.