EP

Size: a a a

2018 April 25

@Scitator с conda в ods у кого-то проблемы были. pip работает. Ты его обновил до 10?

SK

@soupault

короче говоря, кулстори

команда: `pip install http://download.pytorch.org/whl/cu91/torch-0.4.0-cp36-cp36m-linux_x86_64.whl`

без VPN - не работает, c VPN - работает

и да pip последний

PS. с conda - тоже самое

PS2. давно я не видел скорости меньше 1 MB/s

короче говоря, кулстори

команда: `pip install http://download.pytorch.org/whl/cu91/torch-0.4.0-cp36-cp36m-linux_x86_64.whl`

без VPN - не работает, c VPN - работает

и да pip последний

PS. с conda - тоже самое

PS2. давно я не видел скорости меньше 1 MB/s

EP

Только что обновил pytorch сам - pip его стянул с files.pythonhosted.org . Попробуй напрямую

📒

кстати как без Variable новый торч вам? Variable ведь удобная абстракция была, чем следить за градиентами

c

@soupault

короче говоря, кулстори

команда: `pip install http://download.pytorch.org/whl/cu91/torch-0.4.0-cp36-cp36m-linux_x86_64.whl`

без VPN - не работает, c VPN - работает

и да pip последний

PS. с conda - тоже самое

PS2. давно я не видел скорости меньше 1 MB/s

короче говоря, кулстори

команда: `pip install http://download.pytorch.org/whl/cu91/torch-0.4.0-cp36-cp36m-linux_x86_64.whl`

без VPN - не работает, c VPN - работает

и да pip последний

PS. с conda - тоже самое

PS2. давно я не видел скорости меньше 1 MB/s

Вчера через pip ставил, все ок

Conda не пашет

Conda не пашет

ME

кстати как без Variable новый торч вам? Variable ведь удобная абстракция была, чем следить за градиентами

Мне нравится. Есть глобальный переключатель для nograd.

SK

by the way, про pytorch 0.4 - выглядит очень годно, tensor=variable - это вообще шикарно (много обвязок можно убрать) +

миграция - вообще без боли, интересует только поведение tensor.to(device) и DataParallel model - еще не успел проверить на куче GPU (а с одной - не канон)

по скорости - кажется, что стало чуть быстрее (по графикам ~1-2%)

torch.tensor подвезли.миграция - вообще без боли, интересует только поведение tensor.to(device) и DataParallel model - еще не успел проверить на куче GPU (а с одной - не канон)

по скорости - кажется, что стало чуть быстрее (по графикам ~1-2%)

ME

by the way, про pytorch 0.4 - выглядит очень годно, tensor=variable - это вообще шикарно (много обвязок можно убрать) +

миграция - вообще без боли, интересует только поведение tensor.to(device) и DataParallel model - еще не успел проверить на куче GPU (а с одной - не канон)

по скорости - кажется, что стало чуть быстрее (по графикам ~1-2%)

torch.tensor подвезли.миграция - вообще без боли, интересует только поведение tensor.to(device) и DataParallel model - еще не успел проверить на куче GPU (а с одной - не канон)

по скорости - кажется, что стало чуть быстрее (по графикам ~1-2%)

почему ты выделил

torch.tensor? разве это не ренейм?SK

вроде только ввели, хотя, особой разницы от

torch.from_numpy пока не заметилEN

норм установилось с помощью

через вайфай в метро проблем никаких не было)

conda install pytorch torchvision -c pytorch

через вайфай в метро проблем никаких не было)

S

норм установилось с помощью

через вайфай в метро проблем никаких не было)

conda install pytorch torchvision -c pytorch

через вайфай в метро проблем никаких не было)

Повезло. Через mgts качает, но скорость 25KB/s

c

Всем привет!

Завтра на семинаре выступит Артём Рыжиков.

В 19:00

ШАД, Стенфорд

Доклад будет посвящён статье Action-Dependent Control Variates for Policy Optimization via Stein Identity

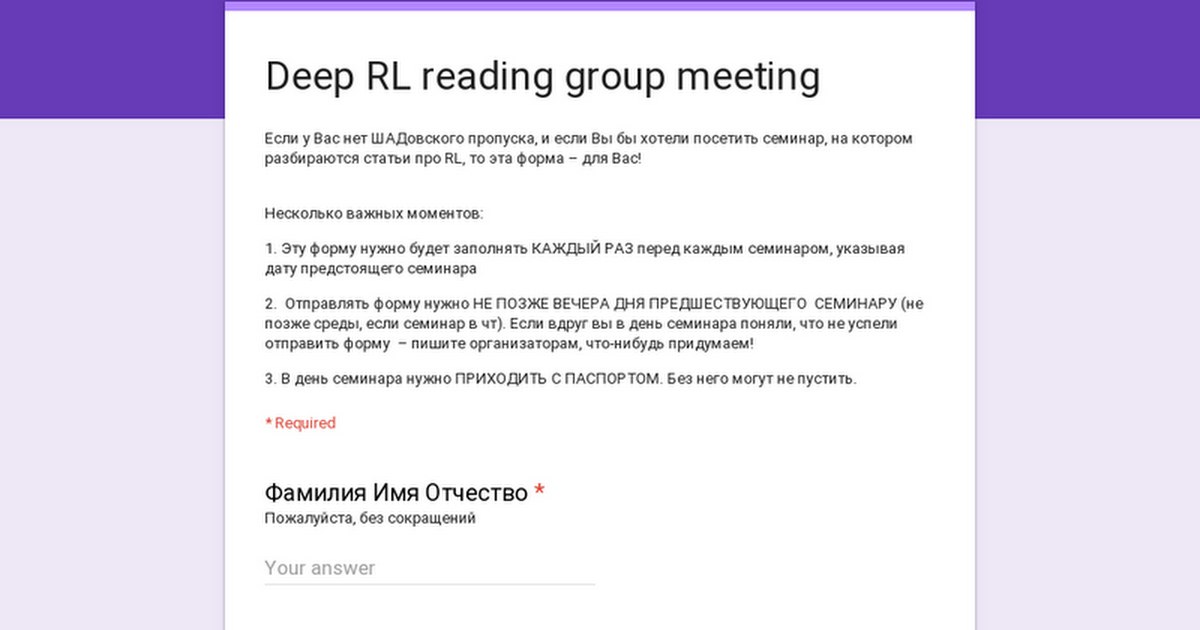

Если у вас нет пропуска, не забудьте зарегистрироваться по ссылке до сегодняшней ночи:

https://docs.google.com/forms/d/e/1FAIpQLSd18PGkZuOqkWThJhmNxnmiSVFicnH4YwLVTCOkEkVQV6ZIDg/viewform

Policy Gradient методы показывают высокую эффективность в задачах RL, однако страдают от высокой дисперсии в оценке градиента. Мы рассмотрим метод снижения дисперсии, основанный на уравнении Штейна. Метод вносит в бейзлайн функции зависимость от действий агента, тем самым, обобщая предыдущие подходы.

Было показано значительное повышение сэмпл эфишенси по сравнению с sota Policy Gradient методами.

Мы ещё раз поговорим о том, зачем в а2с value-голова, какое отношение она имеет к дисперсии градиента, а дальше введем более общий и широкий класс несмещенных поправок, порождаемых тождеством Штейна, обобщающий имеющиеся PG подходы (Q-prop, A2C и DDPG), а также модифицируем PPO этим семейством функций.

Приходите, будет интересно!

Завтра на семинаре выступит Артём Рыжиков.

В 19:00

ШАД, Стенфорд

Доклад будет посвящён статье Action-Dependent Control Variates for Policy Optimization via Stein Identity

Если у вас нет пропуска, не забудьте зарегистрироваться по ссылке до сегодняшней ночи:

https://docs.google.com/forms/d/e/1FAIpQLSd18PGkZuOqkWThJhmNxnmiSVFicnH4YwLVTCOkEkVQV6ZIDg/viewform

Policy Gradient методы показывают высокую эффективность в задачах RL, однако страдают от высокой дисперсии в оценке градиента. Мы рассмотрим метод снижения дисперсии, основанный на уравнении Штейна. Метод вносит в бейзлайн функции зависимость от действий агента, тем самым, обобщая предыдущие подходы.

Было показано значительное повышение сэмпл эфишенси по сравнению с sota Policy Gradient методами.

Мы ещё раз поговорим о том, зачем в а2с value-голова, какое отношение она имеет к дисперсии градиента, а дальше введем более общий и широкий класс несмещенных поправок, порождаемых тождеством Штейна, обобщающий имеющиеся PG подходы (Q-prop, A2C и DDPG), а также модифицируем PPO этим семейством функций.

Приходите, будет интересно!

AP

Ребята, завтра, к сожалению, не смогу быть на семинаре и провести трансляцию, если кто-то может провести и записать доклад - это было бы замечательно :)

2018 April 26

S

Возьму с собой ноут и камеру

SK

иии это опять я :)

notes по прошлому семинару - https://github.com/Scitator/papers/blob/master/papers/1803_behavioral_cloning.md

+ меня пнули и я начал читать больше - https://github.com/Scitator/papers/blob/master/papers/1803_cnn_vs_rnn.md

@tany_savelieva как на тебя сослаться в обзоре?

и вопрос по статье:

правильно ли я понял, что за место предикта, что надо делать агенту, авторы предиктили в какой состоянии окажется агент? т.е. в сетапе игры в баскетбол - они разибили все на сетку и имени конечное число состояний - и там так можно?

notes по прошлому семинару - https://github.com/Scitator/papers/blob/master/papers/1803_behavioral_cloning.md

+ меня пнули и я начал читать больше - https://github.com/Scitator/papers/blob/master/papers/1803_cnn_vs_rnn.md

@tany_savelieva как на тебя сослаться в обзоре?

и вопрос по статье:

правильно ли я понял, что за место предикта, что надо делать агенту, авторы предиктили в какой состоянии окажется агент? т.е. в сетапе игры в баскетбол - они разибили все на сетку и имени конечное число состояний - и там так можно?

SK

и почему-то все пропустили, а у авторов есть демка - http://basketball-ai.com

ТС

сережа, привет, можно так и сослаться на телеграм или как угодно) ага, все правильно

ТС

обзоры крутые

AG

Ребят, кто знает, во всех графиках на играх Атари обычно по оси х рисуют 200М фреймов. Значит ли это, что мы играли пока не набралось 200М фреймов, которые отстоят на расстоянии 4 (frame skip) друг от друга или же мы играем пока не наберётся 50М фреймов (что с учётом пропущенных посредством frameskip фреймов составит как раз таки 200М “отыгранных” фреймов).

MK

Первое. Всего 50М шагов град спуска.