SA

Size: a a a

2018 June 26

EZ

чудеса в решете

EZ

не искалось

SA

:D

2018 June 27

c

Всем привет

Летом у всех сессия, рабочие дедлайны и отпуска

Поэтому до сентября наш семинар RL reading group переходит в летний режим

А именно, будем проводить встречи, если есть желающий выступить

Если вы хотите рассказать о какой-либо статье / теме / своей собственной разработке на семинаре, пишите мне и мы организуем встречу

Кучу интересной литературы на почитать / рассказать вы можете найти на канале https://t.me/rlpapers

Ваша инициатива нам очень важна

Летом у всех сессия, рабочие дедлайны и отпуска

Поэтому до сентября наш семинар RL reading group переходит в летний режим

А именно, будем проводить встречи, если есть желающий выступить

Если вы хотите рассказать о какой-либо статье / теме / своей собственной разработке на семинаре, пишите мне и мы организуем встречу

Кучу интересной литературы на почитать / рассказать вы можете найти на канале https://t.me/rlpapers

Ваша инициатива нам очень важна

2018 June 28

MP

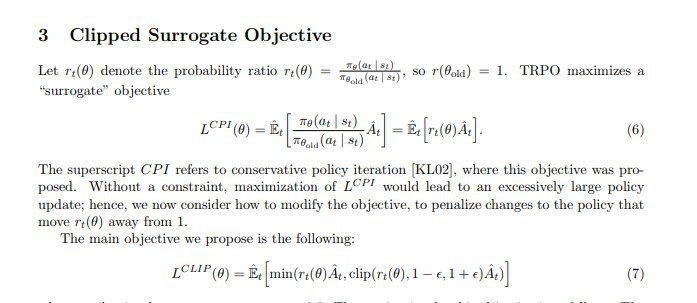

Привет, возник вопрос про PPO (может я туплю конечно где-то). В статье по PPO (https://arxiv.org/abs/1707.06347) есть такой кусок на стр.3 (скрин ниже).

Если мы посмотрим на формулу (7), то по идее первый апдейт там равен в точности апдейту для vanilla policy gradient. И получается, что фраза выше "Without a constraint, maximization of L^CPI would lead to an excessively large policy update" теряет всякий смысл, так как в PPO мы как раз делаем такой апдейт. А как я понял плюс PPO в том, что мы просто можем делать несколлько апдейтов с одними и теми же семплами. Я где-то ошибся?

Если мы посмотрим на формулу (7), то по идее первый апдейт там равен в точности апдейту для vanilla policy gradient. И получается, что фраза выше "Without a constraint, maximization of L^CPI would lead to an excessively large policy update" теряет всякий смысл, так как в PPO мы как раз делаем такой апдейт. А как я понял плюс PPO в том, что мы просто можем делать несколлько апдейтов с одними и теми же семплами. Я где-то ошибся?

AF

Привет!

Да, первый апдейт совпадает у них.

Просто идея PPO в том, что при данном наборе сэмплов у нас наш лосс ограничен засчет минимумов за границами для ratio, и плэтому если мы будем делать очень много апдейтов, то мы сойдемся к какой-то точке. А с обычным лоссом такое не прокатит.

Да, первый апдейт совпадает у них.

Просто идея PPO в том, что при данном наборе сэмплов у нас наш лосс ограничен засчет минимумов за границами для ratio, и плэтому если мы будем делать очень много апдейтов, то мы сойдемся к какой-то точке. А с обычным лоссом такое не прокатит.

MP

ясно, странно статья написана получается, типа пишут, что такой апдейт плохой, а сами его делают в итоге. И получается, что trust region в TRPO как бы не особо нужен, так как PPO дает лучше результаты

AF

Он плохой, если делать его многл раз на одних сэмплах

AF

Ну это ведь просто разные способы делать ограничения на разность политик между шагами

MP

ну как бы в PPO мы не делаем никакое ограничение на первом апдейте, там вобще любой апдейт может быть, я про это

AF

А, да. Но мы как раз поэтому lr не делаем слишком большим)

AF

Там же вроде в одной из реализаций я видел как люди начинают первый апдейт делать совсем малым lr, а потом его увеличивают с каждым шагом или эпохой

MP

ок, спасибо, хорошо, что не у меня одного такое понимание)

SK

можно немного удостовериться?

PPO, получается, на каждой итерации оптимизирует "обычный" PG, но в пределах trust region по изменению политики?

PPO, получается, на каждой итерации оптимизирует "обычный" PG, но в пределах trust region по изменению политики?

AF

Тут нестрогое ограничение стоит.

Оно заключается в том, что если мы выходим за рамки trust region, то мы занижаем полезность политики таким образом, что если после выхода за рамки политика стала хуже, то мы это учитываем, а если стала лучше, то мы улучшение не считаем

Оно заключается в том, что если мы выходим за рамки trust region, то мы занижаем полезность политики таким образом, что если после выхода за рамки политика стала хуже, то мы это учитываем, а если стала лучше, то мы улучшение не считаем

AF

И внутри однлй итерации PPO много обновлений весов при этом

AF

Я не знаю, насколько ты знаешь детали, поэтому наптсал из предположения, что не знаешь)

SK

хмм, точно, не строгая