А

Size: a a a

2020 June 30

Если кто интересуется iot и предиктивной а том числе на базе решений Microsoft - срочно ко мне в личку ) а то этот чат про другое немного. Перегрузим его от слова совсем.

a

Не удалось сохранить изменения на сервере. Возвращена ошибка "Ошибка OLE DB или ODBC: [DataFormat.Error] Не удалось преобразовать в число..".

привет. помогите, плиз. что за беда с датой?

привет. помогите, плиз. что за беда с датой?

AB

Привет всем

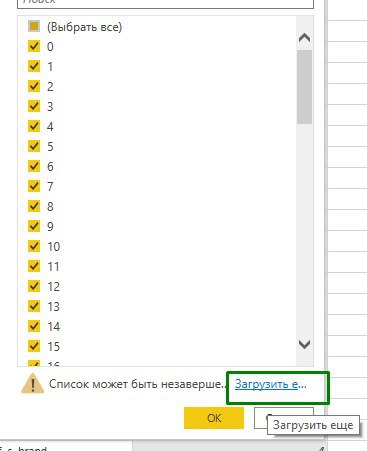

Подскажите, пожалуйста, можно ли ускорить подзгрузку файла в фильтре столбца?

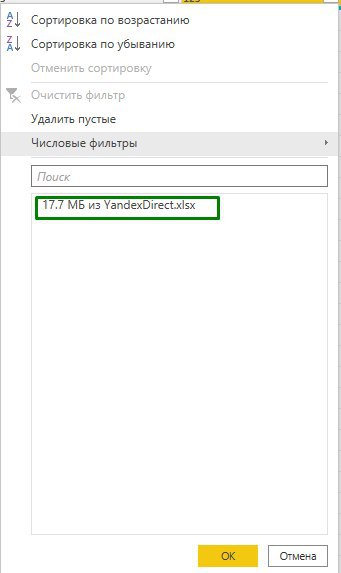

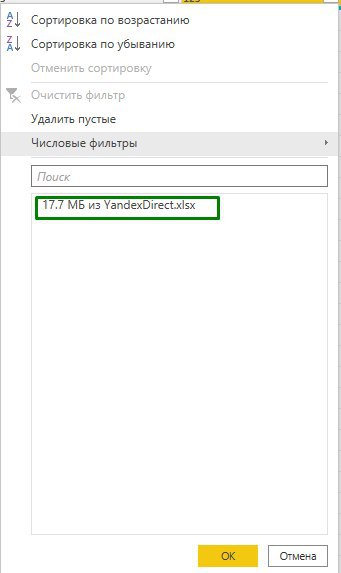

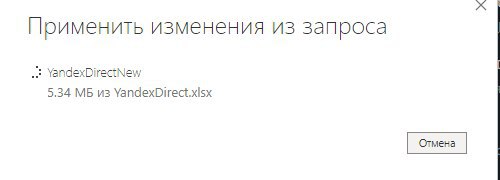

работаю с файлом выгрузки с YandexDirect, файл размером около 18 мегабайт. Каждый раз когда в каком-то столбце я выбираю значения в фильтре, нажимаю "Загрузить еще", чтобы отобразить все значения и убрать не нужные значения - эта самая подгрузка происходит около 50 секунд, и это еще файл не большой

с чем это может быть связано?

Подскажите, пожалуйста, можно ли ускорить подзгрузку файла в фильтре столбца?

работаю с файлом выгрузки с YandexDirect, файл размером около 18 мегабайт. Каждый раз когда в каком-то столбце я выбираю значения в фильтре, нажимаю "Загрузить еще", чтобы отобразить все значения и убрать не нужные значения - эта самая подгрузка происходит около 50 секунд, и это еще файл не большой

с чем это может быть связано?

А

С тем что файл большой, очевидно же

AB

18 мегебайт это считается большой? я просто хочу понять, я только учусь

a

та ну. 18 мб это же мелочь в мире экселя и больших данных. не?

AB

а если файл будет весить 100 мегабайт то я буду ждать 5 минут только открывая фильтр

AB

я тоже так думаю

AB

125000 строк, 11 столбцов

!

AB

Это крохи, ничтожно мало!

ID у Вас число или текст?

ID у Вас число или текст?

!

AK

Тут парни миллиардами строк меряются иногда...

AB

😋слышал о таком

O

Игорь Стерхов

О, моя тема :)

В общем, различие oltp/olap это основа, которая за последние 20+ лет особо и не изменилась

Всегда, вне зависимости от BI системы, данные для отчетов всегда стремились денормализовать вплоть до 1й плоской таблицы.

Но сам вопрос шире, и тут нужны годы, чтобы не только понять теорию, но и освоить, набить шишек на практике.

Можете попробовать пройти курсы для подготовки к экзаменам МС по разработке хранилищ данных и моделей данных.

К примеру курсы Специалиста, от Самородова, - для начинающих очень неплохо, мне в свое время понравилось, дается некий фундамент, подход Инмона, Кимбалла, отличие olap и oltp, построение всяких SCD2, паттерны захвата измененных данных и тд

Книжки итальянцев тоже хорошо раскрывают тонкости проектирования ХД и olap, причем старые книжки навроде "Expert Cube Development with SSAS Multidimensional Models" - раскрывают подходы к построению ХД в тч.. хотя новые наверное тоже )

Далее - уже практика и самостоятельное изучение. чтение статей, посещение конференций, вебинаров и тд. Подходов очень много, Кимбалл и Инмон - только основа, кроме них есть подходы гибридные, а есть вообще никак с ними не связанные, к примеру - на 6НФ (anchor modelling), плюс еще делают гибридную OLTP/OLAP базу, когда поверх OLTP базы строятся Nonclustered columnstore indexes для целей аналитики, плюс есть MPP базы для сверхбольших данных. Очень много всего, и это почти никак не структурировано концептуально, тк все очень специфично, структурированы только основы.

Teradata же, это Massive parallel processing БД, для реально больших объемов (десятки, сотни миллиардов и больше строк). На практике я дела с ними не имел, но опыт коллег мониторил. И тут подход в части BI уже другой, тут отказываются от какого либо импорта данных в средство BI или олап кубов ( ну либо только если есть возможность импортировать совсем сверхагрегированные данные), - от всего этого отказываются, а работают с помощью прямого подключения, Direct Query, т.е. БД должна отрабатывать все запросы к данным, фильтрацию, агрегацию - на лету, и понятно, что для этого необходимо специально проектировать хранилище, чтобы запросы максимально и равномерно параллелились между нодами. И соответственно куча заморочек, специфичных именно для MPP СУБД.

В общем, различие oltp/olap это основа, которая за последние 20+ лет особо и не изменилась

Всегда, вне зависимости от BI системы, данные для отчетов всегда стремились денормализовать вплоть до 1й плоской таблицы.

Но сам вопрос шире, и тут нужны годы, чтобы не только понять теорию, но и освоить, набить шишек на практике.

Можете попробовать пройти курсы для подготовки к экзаменам МС по разработке хранилищ данных и моделей данных.

К примеру курсы Специалиста, от Самородова, - для начинающих очень неплохо, мне в свое время понравилось, дается некий фундамент, подход Инмона, Кимбалла, отличие olap и oltp, построение всяких SCD2, паттерны захвата измененных данных и тд

Книжки итальянцев тоже хорошо раскрывают тонкости проектирования ХД и olap, причем старые книжки навроде "Expert Cube Development with SSAS Multidimensional Models" - раскрывают подходы к построению ХД в тч.. хотя новые наверное тоже )

Далее - уже практика и самостоятельное изучение. чтение статей, посещение конференций, вебинаров и тд. Подходов очень много, Кимбалл и Инмон - только основа, кроме них есть подходы гибридные, а есть вообще никак с ними не связанные, к примеру - на 6НФ (anchor modelling), плюс еще делают гибридную OLTP/OLAP базу, когда поверх OLTP базы строятся Nonclustered columnstore indexes для целей аналитики, плюс есть MPP базы для сверхбольших данных. Очень много всего, и это почти никак не структурировано концептуально, тк все очень специфично, структурированы только основы.

Teradata же, это Massive parallel processing БД, для реально больших объемов (десятки, сотни миллиардов и больше строк). На практике я дела с ними не имел, но опыт коллег мониторил. И тут подход в части BI уже другой, тут отказываются от какого либо импорта данных в средство BI или олап кубов ( ну либо только если есть возможность импортировать совсем сверхагрегированные данные), - от всего этого отказываются, а работают с помощью прямого подключения, Direct Query, т.е. БД должна отрабатывать все запросы к данным, фильтрацию, агрегацию - на лету, и понятно, что для этого необходимо специально проектировать хранилище, чтобы запросы максимально и равномерно параллелились между нодами. И соответственно куча заморочек, специфичных именно для MPP СУБД.

👍

V

Привет всем

Подскажите, пожалуйста, можно ли ускорить подзгрузку файла в фильтре столбца?

работаю с файлом выгрузки с YandexDirect, файл размером около 18 мегабайт. Каждый раз когда в каком-то столбце я выбираю значения в фильтре, нажимаю "Загрузить еще", чтобы отобразить все значения и убрать не нужные значения - эта самая подгрузка происходит около 50 секунд, и это еще файл не большой

с чем это может быть связано?

Подскажите, пожалуйста, можно ли ускорить подзгрузку файла в фильтре столбца?

работаю с файлом выгрузки с YandexDirect, файл размером около 18 мегабайт. Каждый раз когда в каком-то столбце я выбираю значения в фильтре, нажимаю "Загрузить еще", чтобы отобразить все значения и убрать не нужные значения - эта самая подгрузка происходит около 50 секунд, и это еще файл не большой

с чем это может быть связано?

Напрямую по api дергаете?

AB

Напрямую по api дергаете?

нет, файл локально xlsx загрузил

AB

только начал изучать PowerBI неделю назад

AB

вот к примеру сейчас вношу изменения, и подгрузка идет по 200 килобайт в секунду, где-то так

А

У меня 500 мб pbix / на 8 ГБ оперативки пересчитывается 4 секунды

А

При этом это полный объём данных тех же самых в postgre SQL гигов 25